Différence entre Petites et grandes données

Les petites données ne sont rien d'autre que des données suffisamment complètes pour être humaines dans un volume et également pour le formatage, ce qui les rend accessibles, informatives et exploitables. Le traitement traditionnel des données ne peut pas traiter des données volumineuses ou complexes, ces données sont qualifiées de Big Data. Lorsque le volume de données augmente au-delà d'une certaine limite, les systèmes et méthodologies traditionnels ne suffisent pas pour traiter les données ou transformer les données dans un format utile. C'est pourquoi les données sont généralement classées en deux - Small Data vs Big Data

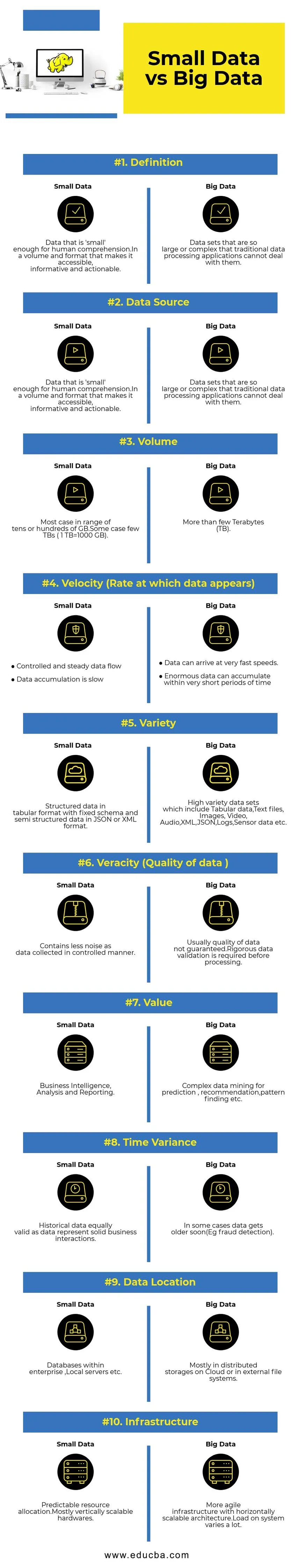

Comparaison directe entre Small Data et Big Data (Infographie)

Vous trouverez ci-dessous les 10 principales différences entre les petites et les grandes données

Différences clés entre Small Data et Big Data

- Collecte de données - Généralement, les petites données font partie des systèmes OLTP et sont collectées de manière plus contrôlée, puis insérées dans la couche de mise en cache ou la base de données. Les bases de données auront des répliques lues pour prendre en charge les requêtes analytiques immédiates si nécessaire. Le pipeline de collecte de Big Data aura des files d'attente comme AWS Kinesis ou Google Pub / Sub pour équilibrer les données à grande vitesse. L'aval aura des pipelines de streaming pour les analyses en temps réel et des travaux par lots pour le traitement des données à froid.

- Traitement des données - Comme la plupart des petites données générées par le système de transaction, les analyses en plus seront orientées par lots la plupart du temps. Dans de rares cas, les requêtes d'analyse s'exécutent directement sur les systèmes de transaction. Les environnements Big Data auront à la fois des pipelines de traitement par lots et par flux. Un flux est utilisé pour des analyses en temps réel telles que la détection de fraude par carte de crédit ou la prévision du cours des actions. Traitement par lots utilisé pour implémenter une logique métier complexe avec des données et des algorithmes avancés.

- Évolutivité - Les systèmes Small Data évoluent généralement verticalement. La mise à l'échelle verticale augmente la capacité du système en ajoutant plus de ressources à la même machine. La mise à l'échelle verticale est coûteuse mais moins complexe à gérer. Les systèmes de Big Data dépendent principalement d'une architecture évolutive horizontale qui donne plus d'agilité à moindre coût. Les machines virtuelles préventives disponibles dans le cloud rendent les systèmes évolutifs horizontalement encore plus abordables.

- Modélisation des données - Les petites données générées à partir des systèmes de transaction seront sous forme normalisée.Les pipelines de données ETL (Extract Transform Load) les convertissent en schéma en étoile ou en flocon de neige dans un entrepôt de données. Ici, le schéma est toujours appliqué lors de l'écriture de données, ce qui est relativement facile car les données sont plus structurées. Comme mentionné ci-dessus, les données tabulaires ne représentent qu'une fraction du Big Data. Ici, les données sont répliquées beaucoup plus pour diverses raisons telles que le transfert d'échec ou en raison de certaines limitations du moteur de base de données sous-jacent (par exemple, certaines bases de données ne prennent en charge qu'un seul index secondaire par ensemble de données). Un schéma n'est pas appliqué lors de l'écriture. Au lieu de cela, un schéma est validé lors de la lecture des données.

- Stockage et couplage de calcul - Dans les bases de données traditionnelles qui traitent principalement les petites données, le stockage et l'informatique sont étroitement couplés.L'insertion et la récupération de données vers et depuis la base de données ne sont possibles que via l'interface donnée. Les données ne peuvent pas être placées directement dans le système de fichiers de la base de données, ou les données existantes ne peuvent pas être interrogées à l'aide d'autres moteurs de base de données. En fait, cette architecture contribue grandement à garantir l'intégrité des données. Les systèmes Big Data ont un couplage très lâche entre le stockage et le calcul. Habituellement, les données sont stockées dans un système de stockage de données distribué comme HDFS, AWS S3 ou Google GCS et un moteur de calcul pour interroger les données ou faire ETL sélectionné ultérieurement. Par exemple, des requêtes interactives peuvent être exécutées à l'aide de Presto (Link) et ETL à l'aide d'Apache Hive sur les mêmes données.

- Science des données - Les algorithmes d'apprentissage automatique nécessitent des données d'entrée dans un format bien structuré et correctement codé, et la plupart du temps les données d'entrée proviendront à la fois de systèmes transactionnels comme un entrepôt de données et d'un stockage Big Data comme un lac de données. Les algorithmes d'apprentissage automatique fonctionnant uniquement sur Small Data seront faciles car la phase de préparation des données est étroite. Préparer et enrichir des données dans l'environnement Big Data prend beaucoup plus de temps. Le Big Data offre de nombreuses options d'expérimentation en science des données en raison du volume élevé et de la variété des données.

- Sécurité des données - Les pratiques de sécurité pour les petites données qui résident sur l'entrepôt de données d'entreprise ou les systèmes de transaction fournis par les fournisseurs de bases de données correspondants qui peuvent inclure des privilèges utilisateur, le chiffrement des données, le hachage, etc. La sécurisation des systèmes Big Data est beaucoup plus compliquée et difficile. Les meilleures pratiques de sécurité incluent le chiffrement des données au repos et en transit, l'isolement du réseau de clusters, des règles de contrôle d'accès strictes, etc.

Tableau de comparaison Small Data vs Big Data

| Base de comparaison | Petites données | Big Data |

| Définition | Des données suffisamment `` petites '' pour la compréhension humaine, dans un volume et un format qui les rendent accessibles, informatives et exploitables | Ensembles de données si volumineux ou complexes que les applications de traitement de données traditionnelles ne peuvent pas les traiter |

| La source de données | ● Données provenant de systèmes d'entreprise traditionnels tels que ○ Planification des ressources d'entreprise ○ Gestion de la relation client (CRM) ● Données financières comme les données du grand livre général ● Données de transaction de paiement du site Web | ● Acheter des données sur le point de vente ● Données Clickstream provenant de sites Web ● Données de flux GPS - Données de mobilité envoyées à un serveur ● Médias sociaux - facebook, twitter |

| Le volume | La plupart des cas dans une gamme de dizaines ou de centaines de Go. Quelques cas peu de TB (1 To = 1000 Go) | Plus de quelques téraoctets (To) |

| Vitesse (taux auquel les données apparaissent) | ● Flux de données contrôlé et stable ● L'accumulation de données est lente | ● Les données peuvent arriver à des vitesses très rapides. ● D'énormes données peuvent s'accumuler en très peu de temps |

| Variété | Données structurées au format tabulaire avec schéma fixe et données semi-structurées au format JSON ou XML | Ensembles de données très variés qui incluent des données tabulaires, des fichiers texte, des images, de la vidéo, de l'audio, du XML, du JSON, des journaux, des données de capteur, etc. |

| Véracité (qualité des données) | Contient moins de bruit que les données collectées de manière contrôlée. | Habituellement, la qualité des données n'est pas garantie. Une validation rigoureuse des données est requise avant le traitement. |

| Valeur | Intelligence d'affaires, analyse et rapports | Exploration de données complexes pour la prédiction, la recommandation, la recherche de modèles, etc. |

| Écart de temps | Les données historiques sont également valables car les données représentent de solides interactions commerciales | Dans certains cas, les données vieillissent bientôt (par exemple, détection de fraude). |

| Emplacement des données | Bases de données au sein d'une entreprise, serveurs locaux, etc. | Surtout dans des stockages distribués sur le cloud ou dans des systèmes de fichiers externes. |

| Infrastructure | Allocation des ressources prévisible.Matériel évolutif principalement verticalement | Infrastructure plus agile avec une architecture évolutive horizontalement. La charge sur le système varie beaucoup. |

Conclusion - Small Data vs Big Data

L'objectif ultime de l'analyse des données pour obtenir des informations en temps opportun à l'appui de la prise de décision. La catégorisation des données en petites et grandes aide à relever les défis de l'analyse séparée des données de chaque monde avec des outils appropriés. La ligne entre deux catégories varie en fonction des systèmes de traitement de données avancés émergents, ce qui rend les requêtes de données volumineuses beaucoup plus rapides et moins complexes.

Articles recommandés:

Cela a été un guide pour les petites et les grandes données, leur signification, leur comparaison directe, leurs principales différences, leur tableau de comparaison et leur conclusion. cet article comprend toutes les différences importantes entre les petites et les grandes données. Vous pouvez également consulter les articles suivants pour en savoir plus -

- Big Data vs Data Science - En quoi sont-ils différents?

- Big Data: important de la convergence de la technologie et de l'analyse commerciale

- Top 5 des tendances Big Data que les entreprises devront maîtriser

- 16 conseils intéressants pour transformer le Big Data en grand succès