Introduction au prétraitement des données dans l'apprentissage automatique

Le prétraitement des données dans le Machine Learning est un moyen de convertir les données du formulaire brut en un formulaire beaucoup plus formaté, inutilisable ou souhaité. C'est une tâche intégrale de l'apprentissage automatique qui est effectuée par le data scientist. Comme les données collectées sont dans un format brut, il pourrait ne pas être possible de former le modèle à l'aide de celui-ci. Il est important de traiter ces données brutes avec soin pour en faire une interprétation correcte et enfin éviter tout résultat négatif dans la prédiction. En bref, la qualité de notre algorithme d'apprentissage dépend fortement du type d'ensemble de données que nous avons utilisé pour alimenter le modèle, de sorte que le prétraitement des données est utilisé pour maintenir cette qualité.

Les données recueillies pour la formation du modèle proviennent de diverses sources. Ces données collectées sont généralement dans leur format brut, c'est-à-dire qu'elles peuvent avoir des bruits comme des valeurs manquantes et des informations pertinentes, des nombres au format chaîne, etc. ou elles peuvent être non structurées. Le prétraitement des données augmente l'efficacité et la précision des modèles d'apprentissage automatique. Comme cela aide à supprimer ces bruits de l'ensemble de données et à donner un sens à l'ensemble de données

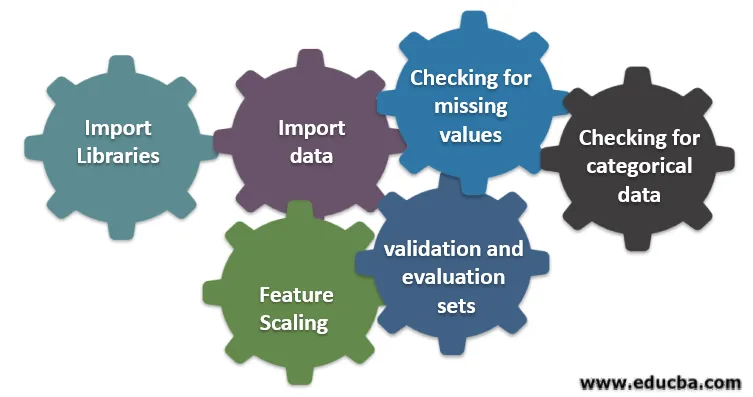

Six étapes différentes impliquées dans l'apprentissage automatique

Voici six étapes différentes impliquées dans l'apprentissage automatique pour effectuer le prétraitement des données:

Étape 1: importer des bibliothèques

Étape 2: importer des données

Étape 3: vérification des valeurs manquantes

Étape 4: vérification des données catégorielles

Étape 5: Mise à l'échelle des fonctionnalités

Étape 6: Division des données en ensembles de formation, de validation et d'évaluation

Comprenons chacune de ces étapes en détail:

1. Importer des bibliothèques

La toute première étape consiste à importer quelques-unes des bibliothèques importantes nécessaires au prétraitement des données. Une bibliothèque est une collection de modules qui peuvent être appelés et utilisés. En python, nous avons beaucoup de bibliothèques qui sont utiles dans le prétraitement des données.

Quelques-unes des bibliothèques importantes suivantes en python sont:

- Numpy: Principalement utilisé la bibliothèque pour implémenter ou utiliser des calculs mathématiques compliqués d'apprentissage automatique. Il est utile pour effectuer une opération sur des tableaux multidimensionnels.

- Pandas : Il s'agit d'une bibliothèque open source qui fournit des outils de structure de données et d'analyse de données hautes performances et faciles à utiliser en python. Il est conçu de manière à rendre le travail avec les données de relation et étiquetées facile et intuitif.

- Matplotlib: C'est une bibliothèque de visualisation fournie par python pour les tracés 2D du tableau. Il est construit sur un tableau numpy et conçu pour fonctionner avec une pile Scipy plus large. La visualisation des ensembles de données est utile dans le scénario où de grandes données sont disponibles. Les tracés disponibles dans matplot lib sont la ligne, la barre, la dispersion, l'histogramme, etc.

- Seaborn: C'est aussi une bibliothèque de visualisation fournie par python. Il fournit une interface de haut niveau pour dessiner des graphiques statistiques attrayants et informatifs.

2. Importer un jeu de données

Une fois les bibliothèques importées, notre prochaine étape consiste à charger les données collectées. La bibliothèque Pandas est utilisée pour importer ces jeux de données. La plupart du temps, les jeux de données sont disponibles au format CSV car ils sont de petite taille, ce qui le rend rapide pour le traitement. Donc, pour charger un fichier csv en utilisant la fonction read_csv de la bibliothèque du panda. Divers autres formats de l'ensemble de données qui peuvent être vus sont

Une fois l'ensemble de données chargé, nous devons l'inspecter et rechercher tout bruit. Pour ce faire, nous devons créer une matrice d'entités X et un vecteur d'observation Y par rapport à X.

3. Vérification des valeurs manquantes

Une fois que vous avez créé la matrice d'entités, vous pouvez constater qu'il manque des valeurs. Si nous ne le gérons pas, cela peut causer un problème au moment de la formation.

Il existe deux méthodes de gestion des valeurs manquantes:

- Suppression de la ligne entière contenant la valeur manquante, mais il est possible que vous finissiez par perdre des informations vitales. Cela peut être une bonne approche si la taille de l'ensemble de données est importante.

- Si une colonne numérique a une valeur manquante, vous pouvez estimer la valeur en prenant la moyenne, la médiane, le mode, etc.

4. Vérification des données catégoriques

Les données de l'ensemble de données doivent être sous forme numérique afin de pouvoir effectuer des calculs dessus. Étant donné que les modèles d'apprentissage automatique contiennent des calculs mathématiques complexes, nous ne pouvons pas leur fournir une valeur non numérique. Il est donc important de convertir toutes les valeurs de texte en valeurs numériques. La classe LabelEncoder () des données apprises est utilisée pour convertir ces valeurs catégorielles en valeurs numériques.

5. Mise à l'échelle des fonctionnalités

Les valeurs des données brutes varient considérablement et cela peut entraîner une formation biaisée du modèle ou peut finir par augmenter le coût de calcul. Il est donc important de les normaliser. La mise à l'échelle des fonctionnalités est une technique utilisée pour ramener la valeur des données dans une plage plus courte.

Les méthodes utilisées pour la mise à l'échelle des fonctionnalités sont les suivantes:

- Redimensionnement (normalisation min-max)

- Normalisation moyenne

- Normalisation (normalisation du score Z)

- Mise à l'échelle à la longueur unitaire

6. Division des données en ensembles de formation, de validation et d'évaluation

Enfin, nous devons diviser nos données en trois ensembles différents, un ensemble de formation pour former le modèle, un ensemble de validation pour valider la précision de notre modèle et enfin un ensemble de test pour tester les performances de notre modèle sur des données génériques. Avant de diviser l'ensemble de données, il est important de mélanger l'ensemble de données pour éviter tout biais. Une proportion idéale pour diviser l'ensemble de données est de 60:20:20 soit 60% comme ensemble de formation, 20% comme ensemble de test et de validation. Pour diviser l'ensemble de données, utilisez train_test_split de sklearn.model_selection deux fois. Une fois pour diviser l'ensemble de données en train et ensemble de validation, puis diviser l'ensemble de données de train restant en train et ensemble de test.

Conclusion - Prétraitement des données dans l'apprentissage automatique

Le prétraitement des données est quelque chose qui nécessite de la pratique. Ce n'est pas comme une simple structure de données dans laquelle vous apprenez et appliquez directement pour résoudre un problème. Pour obtenir de bonnes connaissances sur la façon de nettoyer un ensemble de données ou de visualiser votre ensemble de données, vous devez travailler avec différents ensembles de données.

Plus vous utiliserez ces techniques, meilleure sera votre compréhension. C'était une idée générale de la façon dont le traitement des données joue un rôle important dans l'apprentissage automatique. Parallèlement à cela, nous avons également vu les étapes nécessaires pour le prétraitement des données. Alors la prochaine fois avant d'aller former le modèle à l'aide des données collectées, assurez-vous d'appliquer un prétraitement des données.

Articles recommandés

Ceci est un guide sur le prétraitement des données dans l'apprentissage automatique. Nous discutons ici de l'introduction, Six étapes différentes impliquées dans l'apprentissage automatique. Vous pouvez également consulter nos autres articles suggérés pour en savoir plus–

- Importance de l'intelligence artificielle

- Technologie IoT

- Types de données PL / SQL

- Types de données de la ruche

- Types de données R