Introduction à l'architecture Big Data

Lorsqu'il s'agit de gérer des données volumineuses et d'effectuer des opérations complexes sur ces données massives, il devient nécessaire d'utiliser des outils et des techniques de Big Data. Lorsque nous disons que l'utilisation d'outils et de techniques Big Data signifie effectivement que nous demandons d'utiliser divers logiciels et procédures qui se trouvent dans l'écosystème Big Data et sa sphère. Il n'y a pas de solution générique qui est fournie pour chaque cas d'utilisation et par conséquent, elle doit être conçue et fabriquée de manière efficace selon les exigences commerciales d'une entreprise particulière. Ainsi, il devient nécessaire d'utiliser différentes architectures de Big Data, car la combinaison de diverses technologies se traduira par le cas d'utilisation résultant. En établissant une architecture fixe, il est possible de garantir qu'une solution viable sera fournie pour le cas d'utilisation demandé.

Qu'est-ce que l'architecture Big Data?

- Cette architecture est conçue de telle manière qu'elle gère le processus d'ingestion, le traitement des données et l'analyse des données se fait de manière trop grande ou trop complexe pour gérer les systèmes de gestion de base de données traditionnels.

- Différentes organisations ont des seuils différents pour leurs organisations, certaines l'ont pour quelques centaines de gigaoctets tandis que pour d'autres, même certains téraoctets ne sont pas une valeur seuil suffisamment bonne.

- En raison de cet événement qui se produit si vous regardez les systèmes de produits et le stockage des produits, les valeurs et les coûts de stockage ont considérablement diminué. Il existe une grande variété de données qui nécessitent différentes manières d'être prises en charge.

- Certains d'entre eux sont des données liées à des lots qui arrivent à un moment particulier et, par conséquent, les travaux doivent être planifiés de manière similaire tandis que d'autres appartiennent à la classe de streaming où un pipeline de streaming en temps réel doit être construit pour répondre à tous les exigences. Tous ces défis sont résolus par une architecture Big Data.

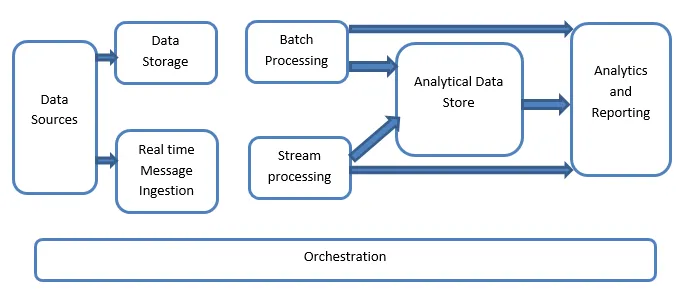

Explication de l'architecture Big Data:

Les systèmes de Big Data impliquent plusieurs types de charges de travail et ils sont généralement classés comme suit:

- Lorsque les sources basées sur les mégadonnées sont au repos, le traitement par lots est impliqué.

- Traitement des données volumineuses en mouvement pour un traitement en temps réel.

- Exploration d'outils et de technologies interactives de Big Data.

- Apprentissage automatique et analyse prédictive.

1. Sources de données

Les sources de données impliquent toutes ces sources d'or à partir desquelles le pipeline d'extraction de données est construit et, par conséquent, cela peut être considéré comme le point de départ du pipeline de Big Data.

Les exemples incluent:

(i) Banques de données d'applications telles que celles comme les bases de données relationnelles

(ii) Les fichiers qui sont produits par un certain nombre d'applications et font majoritairement partie de systèmes de fichiers statiques tels que les fichiers de serveur Web générant des journaux.

(iii) Dispositifs IoT et autres sources de données en temps réel.

2. Stockage des données

Cela inclut les données qui sont gérées pour les opérations construites par lots et qui sont stockées dans les magasins de fichiers qui sont distribués dans la nature et sont également capables de contenir de grands volumes de fichiers volumineux de formats différents. C'est ce qu'on appelle le lac de données. Cela constitue généralement la partie où notre stockage Hadoop tel que les stockages HDFS, Microsoft Azure, AWS, GCP est fourni avec les conteneurs d'objets blob.

3. Traitement par lots

Toutes les données sont séparées en différentes catégories ou segments, ce qui utilise des travaux de longue durée utilisés pour filtrer et agréger et également préparer les données à l'état traité pour l'analyse. Ces travaux utilisent généralement des sources, les traitent et fournissent la sortie des fichiers traités aux nouveaux fichiers. Le traitement par lots est effectué de différentes manières en utilisant des travaux Hive ou des travaux basés sur U-SQL ou en utilisant Sqoop ou Pig avec les travaux de réduction de carte personnalisés qui sont généralement écrits dans l'un des Java ou Scala ou tout autre langage tel que Python.

4. Ingestion de messages en temps réel

Cela inclut, contrairement au traitement par lots, tous ces systèmes de streaming en temps réel qui répondent aux données générées séquentiellement et selon un schéma fixe. Il s'agit souvent d'un simple magasin de données ou d'un magasin responsable de tous les messages entrants qui sont déposés dans le dossier nécessairement utilisé pour le traitement des données. Cependant, il existe une majorité de solutions qui nécessitent le besoin d'une mémoire d'ingestion basée sur les messages qui agit comme un tampon de messages et prend également en charge le traitement basé sur l'échelle, fournit une livraison relativement fiable avec d'autres sémantiques de mise en file d'attente de messagerie. Les options incluent celles comme Apache Kafka, Apache Flume, les hubs d'événements d'Azure, etc.

5. Traitement des flux

Il existe une légère différence entre l'ingestion de messages en temps réel et le traitement de flux. Le premier prend en considération les données ingérées qui sont collectées dans un premier temps, puis sont utilisées comme un type d'outil de publication, d'abonnement. Le traitement de flux, d'autre part, est utilisé pour gérer toutes les données de streaming qui se produisent dans les fenêtres ou les flux, puis écrit les données dans le récepteur de sortie. Cela inclut Apache Spark, Apache Flink, Storm, etc.

6. Datastore basé sur Analytics

Il s'agit du magasin de données qui est utilisé à des fins analytiques et, par conséquent, les données déjà traitées sont ensuite interrogées et analysées à l'aide d'outils d'analyse pouvant correspondre aux solutions de BI. Les données peuvent également être présentées à l'aide d'une technologie d'entrepôt de données NoSQL comme HBase ou de toute utilisation interactive de la base de données ruche qui peut fournir l'abstraction des métadonnées dans le magasin de données. Les outils incluent Hive, Spark SQL, Hbase, etc.

7. Rapports et analyse

Les informations doivent être générées sur les données traitées et cela est effectivement fait par les outils de reporting et d'analyse qui utilisent leur technologie et solution intégrées pour générer des graphiques, des analyses et des informations utiles aux entreprises. Les outils incluent Cognos, Hyperion, etc.

8. Orchestration

Les solutions basées sur le Big Data consistent en des opérations liées aux données qui sont de nature répétitive et sont également encapsulées dans les workflows qui peuvent transformer les données source et également déplacer les données entre les sources ainsi que les puits et les charger dans les magasins et les pousser dans des unités analytiques. Les exemples incluent Sqoop, oozie, data factory, etc.

Conclusion

Dans cet article, nous lisons sur l'architecture du Big Data nécessaire à la mise en œuvre de ces technologies dans l'entreprise ou l'organisation. J'espère que vous avez aimé notre article.

Articles recommandés

Cela a été un guide pour l'architecture Big Data. Ici, nous discutons de ce qu'est le Big Data? et nous avons également expliqué l'architecture des mégadonnées avec le diagramme. Vous pouvez également consulter nos autres articles suggérés pour en savoir plus -

- Technologies Big Data

- Analyse de Big Data

- Carrières en Big Data

- Questions d'entretiens chez Big Data

- Les 8 meilleurs appareils de l'IoT que vous devriez connaître

- Types de jointures dans Spark SQL (exemples)