Qu'est-ce que Hadoop?

Avant de comprendre les avantages de Hadoop, commencez par comprendre Hadoop. Hadoop est un paradigme de traitement des données volumineuses qui fournit un espace fiable et évolutif pour le stockage et le traitement des données. Hadoop a été créé par Doug Cutting et il est considéré comme le «père de Hadoop». Hadoop était le nom de l'éléphant jouet de son fils. Hadoop a ses racines dans Nutch Search Engine Project. Hadoop est un cadre de traitement qui a apporté d'énormes changements dans la façon dont nous traitons les données, la façon dont nous stockons les données. Par rapport aux outils de traitement traditionnels tels que le SGBDR, Hadoop a prouvé que nous pouvons lutter efficacement contre les défis du Big Data comme,

Variété de données: Hadoop peut stocker et traiter des formats de données structurés ainsi que semi-structurés et non structurés.

Le volume de données : Hadoop est spécialement conçu pour gérer l'énorme volume de données dans la plage de pétaoctets.

La vitesse des données : Hadoop peut traiter des pétaoctets de données à grande vitesse par rapport à d'autres outils de traitement comme le SGBDR, c'est-à-dire que le temps de traitement dans Hadoop est très inférieur.

Caractéristiques saillantes de Hadoop

- Hadoop est de nature open source.

- Il fonctionne sur un cluster de machines. La taille du cluster dépend des exigences.

- Il peut fonctionner sur du matériel standard.

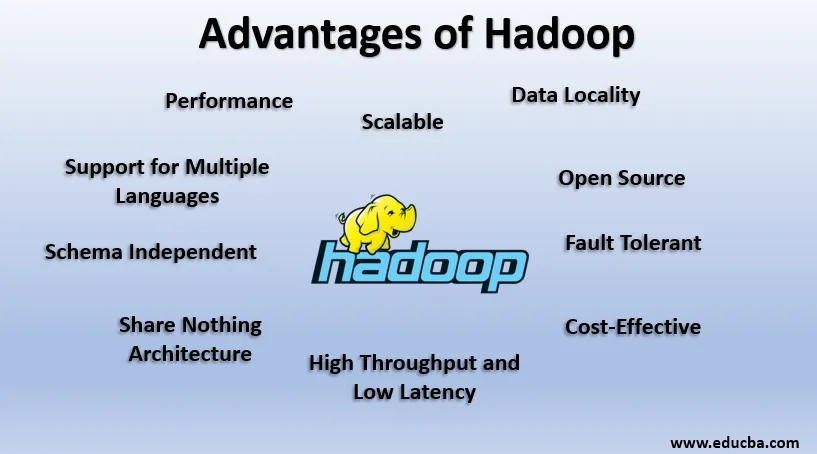

Avantages de Hadoop

Dans cette section, les avantages de Hadoop sont discutés. Examinons-les maintenant un par un:

1. Open Source

Hadoop est de nature open source, c'est-à-dire que son code source est disponible gratuitement. Nous pouvons modifier le code source selon nos exigences commerciales. Même des versions propriétaires de Hadoop comme Cloudera et Horton sont également disponibles.

2. évolutif

Hadoop travaille sur le cluster de machines. Hadoop est hautement évolutif. Nous pouvons augmenter la taille de notre cluster en ajoutant de nouveaux nœuds selon les besoins sans aucun temps d'arrêt. Cette façon d'ajouter de nouvelles machines au cluster est connue sous le nom de mise à l'échelle horizontale, tandis que l'augmentation de composants comme le doublement du disque dur et de la RAM est appelée mise à l'échelle verticale.

3. Tolérant aux pannes

La tolérance aux pannes est la caractéristique saillante de Hadoop. Par défaut, chaque bloc de HDFS a un facteur de réplication de 3. Pour chaque bloc de données, HDFS crée deux copies supplémentaires et les stocke à un emplacement différent dans le cluster. Si un bloc est manquant en raison d'une défaillance de la machine, nous avons encore deux copies du même bloc et celles-ci sont utilisées. De cette façon, la tolérance aux pannes est obtenue dans Hadoop.

4. Indépendant du schéma

Hadoop peut fonctionner sur différents types de données. Il est suffisamment flexible pour stocker différents formats de données et peut fonctionner à la fois avec des données de schéma (structurées) et sans schéma (non structurées).

5. Haut débit et faible latence

Le débit signifie une quantité de travail effectuée par unité de temps et une faible latence signifie de traiter les données sans délai ou moins. Hadoop étant guidé par le principe du stockage distribué et du traitement parallèle, le traitement est effectué simultanément sur chaque bloc de données et indépendamment les uns des autres. De plus, au lieu de déplacer des données, le code est déplacé vers les données du cluster. Ces deux éléments contribuent au débit élevé et à la faible latence.

6. Localité des données

Hadoop fonctionne sur le principe de «déplacer le code, pas les données». Dans Hadoop, les données restent stationnaires et pour le traitement des données, le code est déplacé vers les données sous forme de tâches, c'est ce que l'on appelle la localité de données. Comme nous traitons des données dans la plage de pétaoctets, il devient à la fois difficile et coûteux de déplacer les données à travers le réseau, la localité des données garantit que le mouvement des données dans le cluster est minimum.

7. Performance

Dans les systèmes hérités comme le SGBDR, les données sont traitées séquentiellement mais dans le traitement Hadoop démarre sur tous les blocs à la fois, ce qui permet un traitement parallèle. En raison des techniques de traitement parallèle, les performances de Hadoop sont beaucoup plus élevées que les systèmes hérités comme le SGBDR. En 2008, Hadoop a même battu le supercalculateur le plus rapide présent à l'époque.

8. Ne rien partager de l'architecture

Chaque nœud du cluster Hadoop est indépendant les uns des autres. Ils ne partagent pas de ressources ou de stockage, cette architecture est connue sous le nom de Share Nothing Architecture (SN). Si un nœud du cluster tombe en panne, il ne fera pas tomber l'ensemble du cluster car chaque nœud agit indépendamment, éliminant ainsi un point de défaillance unique.

9. Prise en charge de plusieurs langues

Bien que Hadoop ait été principalement développé en Java, il étend la prise en charge d'autres langages comme Python, Ruby, Perl et Groovy.

10. Rentable

Hadoop est de nature très économique. Nous pouvons créer un cluster Hadoop en utilisant du matériel standard, réduisant ainsi les coûts matériels. Selon l'ère du cloud, les coûts de gestion des données de Hadoop, à savoir le matériel et les logiciels et les autres dépenses, sont très minimes par rapport aux systèmes ETL traditionnels.

11. Abstraction

Hadoop fournit l'abstraction à différents niveaux. Cela rend le travail plus facile pour les développeurs. Un gros fichier est divisé en blocs de même taille et stocké à différents emplacements du cluster. Lors de la création de la tâche de réduction de carte, nous devons nous soucier de l'emplacement des blocs. Nous donnons un fichier complet en entrée et le framework Hadoop s'occupe du traitement de différents blocs de données qui se trouvent à différents endroits. La ruche fait partie de l'écosystème Hadoop et c'est une abstraction au-dessus de Hadoop. Comme les tâches Map-Reduce sont écrites en Java, les développeurs SQL du monde entier n'ont pas pu profiter de Map Reduce. Ainsi, Hive est introduit pour résoudre ce problème. Nous pouvons écrire des requêtes de type SQL sur Hive, ce qui déclenche à son tour des travaux de réduction de la carte. Ainsi, grâce à Hive, la communauté SQL est également en mesure de travailler sur les tâches de réduction de carte.

12. Compatibilité

Dans Hadoop, HDFS est la couche de stockage et Map Reduce est le moteur de traitement. Mais il n'y a pas de règle rigide selon laquelle Map Reduce devrait être le moteur de traitement par défaut. De nouveaux cadres de traitement comme Apache Spark et Apache Flink utilisent HDFS comme système de stockage. Même dans Hive, nous pouvons également changer notre moteur d'exécution en Apache Tez ou Apache Spark selon nos exigences. Apache HBase, qui est la base de données en colonnes NoSQL, utilise HDFS pour la couche de stockage.

13. Prise en charge de divers systèmes de fichiers

Hadoop est de nature très flexible. Il peut ingérer différents formats de données comme des images, des vidéos, des fichiers, etc. Il peut également traiter des données structurées et non structurées. Hadoop prend en charge divers systèmes de fichiers comme JSON, XML, Avro, Parquet, etc.

Fonctionnement de Hadoop

Ci-dessous les points montrent comment Hadoop fonctionne:

1. Stockage distribué et traitement parallèle

C'est le principe moteur de tous les cadres de l'écosystème Hadoop, y compris Apache Spark. Afin de comprendre le fonctionnement de Hadoop et Spark, nous devons d'abord comprendre ce qu'est le «stockage distribué et le traitement parallèle».

2. Stockage distribué

Hadoop ne stocke pas de données dans une seule machine, mais plutôt, il divise ces énormes données en blocs de taille égale qui sont 256 Mo par défaut et stocke ces blocs dans différents nœuds d'un cluster (nœuds de travail). Il stocke les métadonnées de ces blocs dans le nœud maître. Cette façon de stocker le fichier dans des emplacements distribués dans un cluster est connue sous le nom de système de fichiers distribué Hadoop - HDFS.

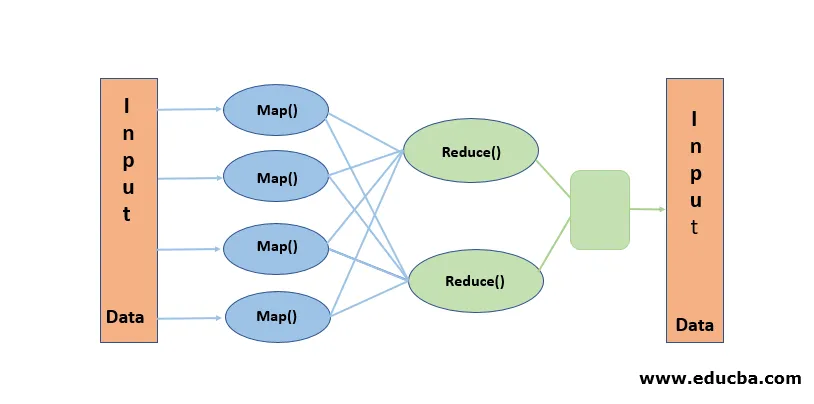

3. Traitement parallèle

Il s'agit d'un paradigme de traitement, où le traitement est effectué simultanément sur les blocs de données stockés dans HDFS. Le traitement parallèle fonctionne sur la notion de «déplacer le code, pas les données». Les données restent stationnaires dans HDFS mais le code est déplacé vers les données pour le traitement. En termes simples, si notre fichier est divisé en 100 blocs, alors 100 copies du travail sont créées et elles voyagent à travers le cluster jusqu'à l'emplacement où réside le bloc et le traitement sur 100 blocs démarre simultanément (phase de carte). Les données de sortie de tous les blocs sont collectées et réduites à la sortie finale (Phase de réduction). Map Reduce est considéré comme «Heart of Hadoop».

Conclusion-Avantages de Hadoop

À l'ère des données, Hadoop a ouvert la voie à une approche différente des défis posés par le Big Data. Lorsque nous disons, Hadoop, nous ne voulons pas dire Hadoop seul, il comprend des outils de l'écosystème Hadoop comme Apache Hive qui fournit des opérations de type SQL sur Hadoop, Apache Pig, Apache HBase pour la base de données de stockage Columnar, Apache Spark pour le traitement en mémoire et de nombreux autres plus. Bien que Hadoop ait ses propres inconvénients, il est hautement adaptable et évolue constamment avec chaque version.

Articles recommandés

Ceci est un guide des avantages de Hadoop. Nous discutons ici de ce qu'est le Hadoop et des principaux avantages de Hadoop. Vous pouvez également consulter nos autres articles connexes pour en savoir plus-

- Cadre HADOOP

- Qu'est-ce que le cluster Hadoop?

- Qu'est-ce que MapReduce dans Hadoop?

- Base de données Hadoop

- Qu'est-ce que Hadoop? | Applications et fonctionnalités