Qu'est-ce que l'écosystème Apache Hadoop?

Apache Hadoop Ecosystem est un framework ou une plate-forme de données open-source destinée à enregistrer et examiner les énormes collections de données non structurées. Partout dans le monde, il y a une tonne de données propulsées à partir de nombreuses plates-formes numériques avec la technologie innovante leader du big data. De plus, Apache Hadoop a été le premier à obtenir ce flux d'innovation.

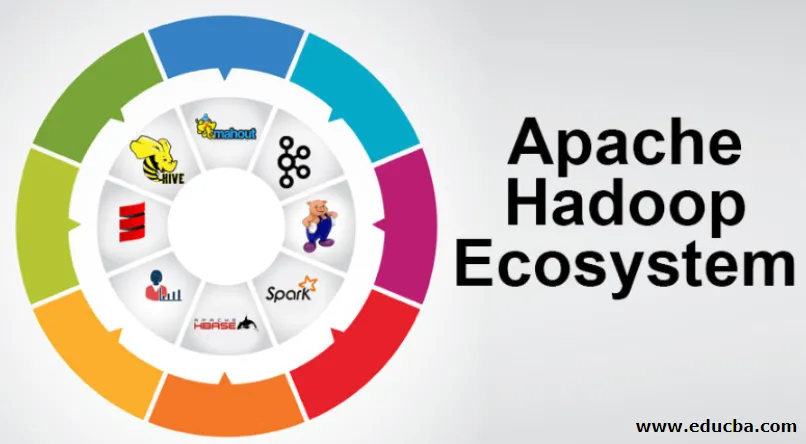

Que comprend l'architecture / l'écosystème Hadoop Data?

L'écosystème Hadoop n'est pas un langage de programmation ou un service, c'est un framework ou une plateforme qui s'occupe des problèmes de big data. Vous pouvez l'identifier comme une suite qui englobe divers services tels que le stockage, l'ingestion, la maintenance et l'analyse à l'intérieur. Ensuite, examinez et obtenez une réflexion concise sur le fonctionnement exclusif et en coopération des services. L'architecture Apache Hadoop comprend différentes innovations et éléments Hadoop grâce auxquels même les problèmes d'informations complexes peuvent être résolus efficacement.

Voici la représentation de chaque partie: -

1) Namenode: il guide le processus d'information

2) Datanode: il compose les informations sur le stockage local. Il n'est pas suggéré de sauvegarder toutes les informations à un endroit unique, car cela pourrait entraîner une perte d'informations en cas de panne.

3) Suivi des tâches: ils reçoivent les tâches attribuées au nœud esclave

4) Carte: elle prend les informations d'un flux et chaque ligne est traitée divisée pour la diviser en différents champs

5) Diminuer: Ici les champs, acquis via Map sont regroupés ou liés les uns aux autres

Écosystème Apache Hadoop - étape par étape

Chaque élément de l'écosystème Hadoop, comme des aspects spécifiques sont évidents. La perspective complète de la structure Hadoop offre une qualité remarquable aux systèmes de fichiers distribués Hadoop (HDFS), Hadoop YARN, Hadoop MapReduce et Hadoop MapReduce de l'écosystème de Hadoop. Hadoop donne même à chaque bibliothèque Java, des enregistrements Java importants, une réflexion au niveau du système d'exploitation, des avantages et des scripts pour faire fonctionner Hadoop. Dans la configuration Hadoop, le HDFS permet un passage à haut débit vers les informations d'application et Hadoop MapReduce permet la préparation parallèle basée sur YARN de vastes assortiments de données.

Présentation de l'écosystème Apache Hadoop

C'est un sujet fondamental à comprendre avant de commencer à travailler avec l'écosystème Hadoop. Voici les composants essentiels:

- HDFS: il s'agit de la partie centrale de l'écosystème Hadoop et il peut enregistrer une énorme quantité d'informations non structurées, structurées et semi-structurées.

- YARN: Il ressemble à l'esprit de l'écosystème Hadoop et toutes les manipulations sont effectuées directement ici, ce qui peut inclure l'allocation d'actifs, le travail de planification et la préparation d'actions.

- MapReduce: C'est un mélange de deux processus, décrits comme Map and Reduce et comprend essentiellement la préparation de pièces composant d'énormes collections d'informations utilisant des algorithmes parallèles et dispersés à l'intérieur de l'écosystème Hadoop.

- Apache Pig: C'est un langage de la procédure, qui est utilisé pour les applications de gestion parallèle pour traiter de vastes collections d'informations en condition Hadoop et ce langage est une option pour la programmation Java.

- HBase: Il s'agit d'une base de données open source et non associée ou NoSQL. Il renforce tous les types d'informations et peut donc traiter n'importe quel type d'informations à l'intérieur d'une infrastructure Hadoop.

- Mahout, Spark MLib: Mahout est utilisé pour l'apprentissage automatique et donne du caractère à la création d'applications d'apprentissage automatique.

- Zookeeper: Pour faire face aux groupes, on peut utiliser Zookeeper, il est autrement appelé le seigneur de la coordination, qui peut donner des administrations opérationnelles fiables, rapides et triées pour les grappes Hadoop.

- Oozie: Apache Oozie gère la planification du travail et fonctionne comme un service d'alerte et d'horloge à l'intérieur de l'écosystème Hadoop.

- Ambari: C'est une entreprise d'Apache Software Foundation et il peut progressivement rendre l'écosystème Hadoop flexible.

Hadoop YARN:

Considérez YARN comme l'esprit de votre écosystème Hadoop. Il joue l'intégralité de vos opérations de traitement en répartissant les actifs et les tâches de planification.

Il a deux segments remarquables qui sont ResourceManager et NodeManager.

- ResourceManager: - C'est à nouveau un nœud majeur dans la division opérationnelle. Il obtient la préparation des demandes de renseignements et passe ensuite les demandes de renseignements aux NodeManagers correspondants, où la véritable manipulation a lieu.

- NodeManagers: - Ceux - ci sont installés sur chaque DataNode. Il est en charge de l'exécution d'une assignation sur chaque DataNode.

Comment fonctionne Apache Hadoop?

- Il est destiné à passer de serveurs individuels à une énorme quantité de machines, chacune fournissant des capacités et des calculs locaux. Au lieu de dépendre de l'équipement pour assurer une haute accessibilité, la bibliothèque elle-même est destinée à distinguer et à gérer les déceptions au niveau de la couche application, offrant ainsi un service extrêmement accessible sur un tas de PC, chacun pouvant être enclin à des déceptions.

- Regardez plus loin, cependant, et il y a de plus en plus de charme au travail. Hadoop est totalement modulaire, ce qui implique que vous pouvez échanger pratiquement n'importe lequel de ses segments pour un autre outil logiciel. Cela rend l'architecture fantastiquement adaptable, tout aussi puissante et efficace.

Apache Hadoop Spark:

- Apache Spark est un système d'analyse d'informations en temps réel dans un environnement informatique dispersé. Il implémente des calculs en mémoire pour accélérer la gestion des informations.

- Il est plus rapide pour gérer des informations à grande échelle car il utilise des calculs en mémoire et différentes améliorations. Dans ce sens, il nécessite une force de traitement élevée.

Comment fonctionne Apache Pig?

- Apache Pig est un système avantageux que Yahoo a été développé pour examiner efficacement et en douceur de vastes positions d'information. Il fournit un langage de flux d'informations de haut niveau Pig Latin qui est amélioré, extensible et simple à utiliser.

- La composante exceptionnelle des programmes Pig dans laquelle leur composition est disponible pour une parallélisation substantielle, ce qui simplifie la gestion de collections d'informations importantes.

Cas d'utilisation du porc:

- Les informations de santé privées d'un individu sont privées et ne doivent pas être divulguées à d'autres personnes. Ces données doivent être cachées pour garder le secret, mais les informations sur les services médicaux sont énormes au point qu'il est essentiel de reconnaître et d'exclure les informations individuelles sur les soins de santé. Apache Pig peut être utilisé dans de telles conditions pour dé-reconnaître les données de santé.

Conclusion:

- Il est prévu de passer d'un seul serveur à une énorme quantité de machines, fournissant toutes des capacités et des calculs à proximité. Regardez plus loin, cependant, et il y a de plus en plus d'enchantement au travail.

- Hadoop est totalement modulaire, ce qui implique que vous pouvez échanger pratiquement n'importe laquelle de ses pièces contre un autre outil logiciel. Cela rend la structure incroyablement adaptable, tout aussi puissante et efficace.

Articles recommandés

Ceci a été un guide pour l'écosystème Apache Hadoop. Ici, nous avons discuté de ce qu'est l'écosystème Apache Hadoop? aperçu de l'architecture Hadoop et du fonctionnement de l'écosystème Hadoop. Vous pouvez également consulter nos autres articles suggérés pour en savoir plus -

- Composants de l'écosystème Hadoop

- Comment installer Apache

- Formation Apache Spark

- Carrière à Hadoop