Introduction à Hadoop Framework

Avant de nous plonger dans le cadre technique de Hadoop, nous commencerons par un exemple simple.

Il y a une ferme qui récolte les tomates et les stocke dans une seule zone de stockage, maintenant avec la demande croissante de légumes, la ferme a commencé à récolter des pommes de terre, des carottes - avec une demande croissante, il y avait une pénurie d'agriculteurs alors ils ont embauché plus d'agriculteurs. Après un certain temps, ils ont réalisé qu'il y avait une pénurie dans la zone de stockage - ils ont donc distribué les légumes dans différentes zones de stockage. Lorsqu'il s'agit de récupérer les données, elles fonctionnent toutes en parallèle avec leur propre espace de stockage.

Alors, comment cette histoire est-elle liée aux mégadonnées?

Auparavant, nous avions des données limitées, avec le processeur limité et une unité de stockage. Mais ensuite, la génération de données a augmenté, entraînant un volume élevé et différentes variétés - structurées, semi-structurées et non structurées.La solution a donc été d'utiliser un stockage distribué pour chaque processeur, ce qui a permis un accès facile au stockage et à l'accès aux données.

Alors maintenant, nous pouvons remplacer les légumes comme différents types de données et de lieu de stockage comme des lieux distribués pour stocker les données et différents travailleurs étant chaque processeur.

Le Big Data est donc le défi et Hadoop joue le rôle de la solution.

HADOOP

1. Solution pour BIG DATA: car elle traite des complexités du volume élevé, de la vitesse et de la variété des données.

2. Ensemble du projet open-source.

3. Stocke un énorme volume de données de manière fiable et permet d'énormes calculs distribués.

4. Les attributs clés de Hadoop sont la redondance et la fiabilité (absolument aucune perte de données).

5. Se concentre principalement sur le traitement par lots.

6. Fonctionne sur du matériel de base - vous n'avez pas besoin d'acheter de matériel spécial coûteux.

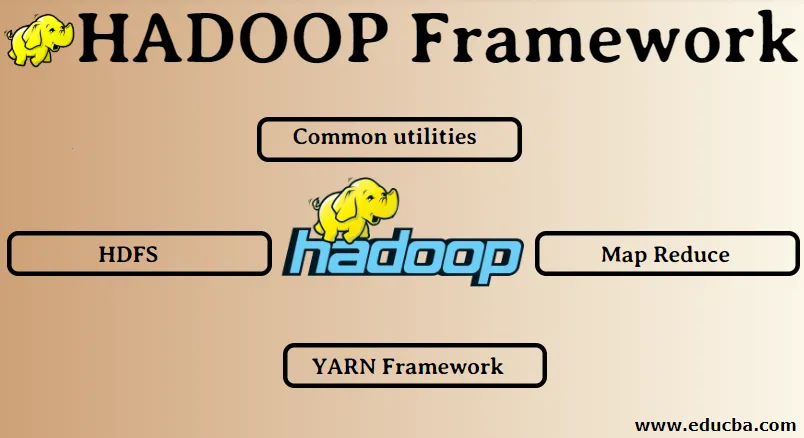

Cadre Hadoop:

1. Utilitaires communs

2. HDFS

3. Réduire la carte

4. Cadre YARN

1. Utilitaires communs:

Aussi appelé le Hadoop commun. Ce ne sont que les bibliothèques, fichiers, scripts et utilitaires JAVA réellement requis par les autres composants Hadoop pour fonctionner.

2. HDFS: système de fichiers distribué Hadoop

Pourquoi Hadoop a choisi d'intégrer un système de fichiers distribué?

Comprenons cela avec un exemple: nous devons lire 1 To de données et nous avons une machine avec 4 canaux d'E / S, chaque canal ayant 100 Mo / s, il a fallu 45 minutes pour lire la totalité des données. Maintenant, la même quantité de données est lue par 10 machines avec chacune 4 canaux d'E / S, chaque canal ayant 100 Mo / s. Devinez le temps qu'il a fallu pour lire les données? 4, 3 minutes. HDFS résout le problème du stockage des mégadonnées. Les deux principaux composants de HDFS sont NAME NODE et DATA NODE. Le nœud de nom est le maître, nous pouvons également avoir un nœud de nom secondaire au cas où le nœud de nom principal cesserait de fonctionner, le nœud de nom secondaire agirait comme une sauvegarde. Le nœud de nom gère et gère essentiellement les nœuds de données en stockant des métadonnées. Le nœud de données est l'esclave, qui est essentiellement le matériel de base à faible coût. Nous pouvons avoir plusieurs nœuds de données. Le nœud de données stocke les données réelles. Ce nœud de données prend en charge le facteur de réplication, supposons que si un nœud de données tombe en panne, les données peuvent être accessibles par l'autre nœud de données répliqué.Par conséquent, l'accessibilité des données est améliorée et la perte de données est évitée.

3. Réduire la carte:

Il résout le problème du traitement des mégadonnées. Comprenons le concept de carte réduit en résolvant ce problème du monde réel. La société ABC veut calculer ses ventes totales, par ville. Maintenant, ici, le concept de table de hachage ne fonctionnera pas car les données sont en téraoctets, nous allons donc utiliser le concept Map-Reduce.

Il y a deux phases: a) MAP. b) RÉDUIRE

a) Carte : Tout d'abord, nous allons diviser les données en petits morceaux appelés mappeurs sur la base de la paire clé / valeur. Ici, la clé sera le nom de la ville et la valeur sera le total des ventes. Chaque mappeur recevra les données de chaque mois qui donnent un nom de ville et les ventes correspondantes.

b) Réduire: Il obtiendra ces piles de données et chaque réducteur sera responsable des villes du Nord / Ouest / Est / Sud. Ainsi, le travail du réducteur consistera à collecter ces petits morceaux et à les convertir en plus grandes quantités (en les additionnant) pour une ville particulière.

4. Cadre YARN: Encore un autre négociateur de ressources.

La version initiale de Hadoop ne comportait que deux composants: Map Reduce et HDFS. Plus tard, il a été réalisé que Map Reduce ne pouvait pas résoudre beaucoup de problèmes de Big Data. L'idée était de retirer les responsabilités de gestion des ressources et de planification des tâches de l'ancien moteur de réduction de carte et de les confier à un nouveau composant. C'est ainsi que YARN est entré en scène. C'est la couche intermédiaire entre HDFS et Map Reduce qui est responsable de la gestion des ressources du cluster.

Il a deux rôles clés à jouer: a) Planification des travaux. b) Gestion des ressources

a) Planification des tâches: lorsqu'une grande quantité de données est destinée au traitement, elles doivent être réparties et réparties en différentes tâches / tâches. Maintenant, le JS décide quel travail doit recevoir la priorité absolue, l'intervalle de temps entre deux travaux, la dépendance entre les travaux, vérifie qu'il n'y a pas de chevauchement entre les travaux en cours d'exécution.

b) Gestion des ressources: pour traiter les données et stocker les données, nous avons besoin de ressources, n'est-ce pas? Ainsi, le gestionnaire de ressources fournit, gère et maintient les ressources pour stocker et traiter les données.

Alors maintenant, nous sommes clairs sur le concept de Hadoop et comment il résout les défis créés par les BIG DATA !!!

Articles recommandés

Cela a été un guide pour Hadoop Framework. Ici, nous avons également discuté des 4 meilleurs cadres Hadoop. Vous pouvez également consulter nos autres articles suggérés pour en savoir plus -

- Base de données Hadoop

- Écosystème Hadoop

- Utilisations de Hadoop

- Emplois d'administrateur Hadoop

- Administrateur Hadoop | Compétences et cheminement de carrière