Qu'est-ce que Pig?

Pig est un moteur open source, qui fait partie des technologies de l'écosystème Hadoop. Pig est excellent pour travailler avec des données qui vont au-delà des bases de données ou des entrepôts de données traditionnels. Cela peut bien gérer les données manquantes, incomplètes ou incohérentes, qui n'ont pas de schéma. Le Pig a son propre langage pour exprimer les manipulations de données, qui est le latin Pig.

Comprendre le cochon

Pig est une technologie qui vous permet d'écrire des scripts de haut niveau mais extrêmement granulaires, ce qui vous permet de travailler avec des données dont le schéma est inconnu ou incohérent. Pig est une technologie open source qui fonctionne au-dessus de Hadoop et fait partie de l'écosystème Hadoop extrêmement dynamique et populaire.

Pig fonctionne bien avec des données non structurées et incomplètes, vous n'avez donc pas besoin d'avoir la disposition traditionnelle des règles et des colonnes pour tout.

Il est bien défini et peut fonctionner directement sur des fichiers en HDFS (Hadoop Distributed File System).

Le Pig sera votre technologie de choix lorsque vous souhaitez transférer des données de la source vers un entrepôt de données.

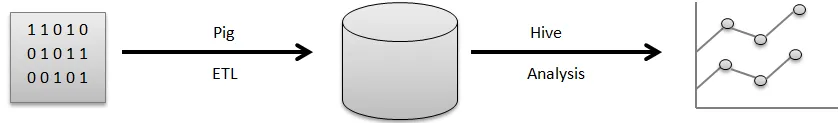

Par exemple, un pipeline visuel de la façon dont les données circulent généralement avant de pouvoir les utiliser pour générer les bons graphiques que vous utilisez pour prendre des décisions commerciales.

Les données brutes proviennent de diverses sources, telles que des capteurs, des téléphones portables, etc. Vous utiliserez ensuite Pig pour effectuer une opération ETL. ETL signifie extraire, transformer et charger, une fois ces opérations effectuées, les données nettoyées sont stockées dans une autre base de données. Un exemple d'une telle base de données serait HDFS, qui fait partie de Hadoop. Hive est un entrepôt de données qui s'exécutera au-dessus d'un système de fichiers comme celui-ci. Hive est ce que vous utiliseriez pour l'analyse, pour générer les rapports et pour extraire des informations.

ETL est une étape très importante dans le traitement des données afin de nettoyer les données brutes et de les conserver sous la bonne forme dans une base de données. L'extraction fait référence à l'opération d'extraction de données non structurées et incohérentes avec un champ et des valeurs manquants de la source d'origine. Transform représente la série d'opérations que vous appliqueriez aux données afin de les nettoyer ou de les récupérer.

Pré-calcul des informations agrégées utiles, traitement des champs pour correspondre à un certain format, tout cela fait partie du nettoyage des données des champs de transformation.

Enfin, Pig effectue l'opération de chargement où ces données propres sont stockées dans une base de données où elles peuvent être analysées plus en détail. Un exemple d'une opération standard effectuée par Pig consiste à nettoyer les fichiers journaux.

Expliquer l'architecture du cochon

Il existe de nombreuses parties de porc dans l'architecture, préférez:

- Analyseur : l'analyseur traite les scripts Pig ainsi que vérifie la syntaxe du script, saisit la vérification et diverses vérifications assorties. En outre, leur résultat pourrait être un DAG (Directed Acyclic Graph) qui signifie généralement les revendications Pig Latin avec des opérateurs logiques.

En outre, les opérateurs logiques avec le script seront affichés comme les nœuds ainsi que les flux de données seront affichés depuis les bords via DAG.

- Optimiseur: plus tard, le plan logique (DAG) est généralement dépassé vers l'optimiseur logique. Il effectue les optimisations logiques supplémentaires, y compris la projection et favorise les faibles

- Compilateur: De plus, le compilateur compile ce plan logique amélioré dans un groupe de travaux MapReduce.

- Moteur d'exécution: En fin de compte, toutes les œuvres MapReduce seront publiées sur Hadoop dans une séquence triée. Finalement, cela génère les résultats requis bien que ces travaux MapReduce soient effectués avec Hadoop.

- MapReduce: MapReduce a été initialement conçu dans Google pour traiter les pages Web afin d'alimenter la recherche Google. MapReduce distribue l'informatique sur plusieurs machines du cluster. MapReduce tire parti du parallélisme inhérent au traitement des données. Les systèmes modernes, tels que les capteurs ou même les mises à jour de statut Facebook, génèrent des millions d'enregistrements de données brutes.

Une activité de ce niveau peut être préparée en deux phases:

- Carte

- Réduire

Vous décidez quelle logique vous souhaitez mettre en œuvre au cours de ces phases pour traiter vos données.

- HDFS (Hadoop Distributed File System): Hadoop permet une explosion du stockage et de l'analyse des données à une échelle illimitée. Les développeurs utilisent une application comme Pig, Hive, HBase et Spark pour récupérer des données depuis HDFS.

traits

Apache Pig est livré avec les différentes fonctionnalités ci-dessous:

- La simplicité de programmation: Pig Latin est comparable à SQL et il est donc assez simple pour les développeurs de créer un script Pig. Dans le cas où vous avez une compréhension du langage SQL, il est incroyablement simple d'apprendre le langage latin Pig car il est comme le langage SQL.

- Ensemble riche d'opérateurs: Pig comprend une variété d'opérateurs riches pour pouvoir exécuter des procédures comme la jointure, le filer, le tri et bien plus encore.

- Possibilités d'optimisation: les performances de la tâche dans Apache Pig peuvent être instantanément améliorées par la tâche elle-même; les développeurs doivent donc se concentrer uniquement sur la sémantique de ce langage.

- Extensibilité: en utilisant des opérateurs accessibles, les utilisateurs peuvent simplement développer leurs fonctions pour lire, traiter et écrire des données.

- Fonctions de définition d'utilisateur (UDF): En utilisant le service fourni par Pig pour créer des UDF, nous pourrions produire des fonctions définies par l'utilisateur sur le nombre de langages de développement, y compris Java, ainsi que les invoquer ou les incorporer toutes dans des scripts Pig.

À quoi sert Pig?

Il est utilisé pour l'examen ainsi que pour l'exécution des responsabilités, y compris le traitement ad hoc. Apache Pig peut être utilisé pour:

L'analyse avec d'énormes collections de données brutes préfère le traitement des données pour obtenir des sites Web de recherche. Tels que Yahoo, Google profite à Apache Pig pour évaluer les données collectées via Google ainsi que les moteurs de recherche Yahoo. Gérer de grandes collections de données comme les enregistrements Web, diffuser des informations en ligne, etc. Même les mises à jour de statut de Facebook génèrent des millions d'enregistrements de données brutes.

Comment cette technologie vous aide-t-elle à progresser dans votre carrière?

De nombreuses organisations mettent en œuvre Apache Pig incroyablement rapidement. Cela signifie que les professions porcines et les carrières porcines augmentent quotidiennement. Il y a eu d'énormes progrès dans le développement d'Apache Hadoop au cours des deux dernières années. Éléments Hadoop comme Hive, Pig, HDFS, HBase, MapReduce, etc.

Bien que les offres Hadoop soient entrées dans leur deuxième décennie à ce moment-là, leur reconnaissance a explosé au cours des trois à quatre années précédentes. Un grand nombre de sociétés de logiciels appliquent incroyablement les clusters Hadoop. Cela peut certainement être la meilleure partie du Big Data. Les experts en visée pourraient devenir des experts de cette excellente technologie.

Conclusion

Apache Pig Expertise est très demandé sur le marché et peut continuer à être étendu. En comprenant simplement les concepts et en acquérant de l'expérience avec les meilleures compétences Apache Pig dans Hadoop, les experts peuvent parfaitement s'engager dans leur profession Apache Pig.

Article recommandé

Cela a été un guide pour Qu'est-ce que Pig? Ici, nous avons discuté des concepts, de la définition et de l'architecture avec les fonctionnalités de Pig. Vous pouvez également consulter nos autres articles suggérés pour en savoir plus -

- Comment installer Apache

- Questions d'entretiens chez Apache PIG

- Qu'est-ce que les services Web ASP.Net?

- Qu'est-ce que la technologie Blockchain?