Introduction à l'arbre de décision dans l'apprentissage automatique

L'arbre de décision dans l'apprentissage automatique a un large champ dans le monde moderne. Il existe de nombreux algorithmes en ML qui sont utilisés dans notre vie quotidienne. L'un des algorithmes importants est l'Arbre de décision qui est utilisé pour la classification et également une solution aux problèmes de régression. Comme il s'agit d'un modèle prédictif, l'analyse de l'arbre de décision se fait via une approche algorithmique où un ensemble de données est divisé en sous-ensembles selon les conditions. Le nom lui-même indique qu'il s'agit d'un modèle arborescent sous la forme d'instructions if-then-else. Plus l'arbre est profond et plus les nœuds sont nombreux, meilleur est le modèle.

Types d'arbre de décision dans l'apprentissage automatique

L'arbre de décision est un graphique en forme d'arbre où le tri commence du nœud racine au nœud feuille jusqu'à ce que la cible soit atteinte. Il est le plus populaire pour la décision et la classification basées sur des algorithmes supervisés. Il est construit par partitionnement récursif où chaque nœud agit comme un cas de test pour certains attributs et chaque bord, dérivant du nœud, est une réponse possible dans le cas de test. Les nœuds racine et feuille sont deux entités de l'algorithme.

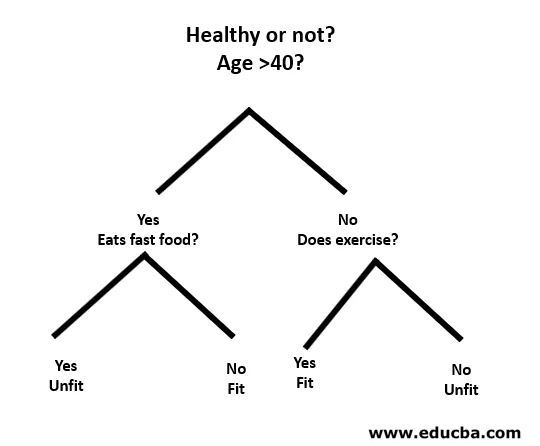

Comprenons à l'aide d'un petit exemple comme suit:

Ici, le nœud racine est de savoir si vous avez moins de 40 ans ou non. Si oui, mangez-vous de la restauration rapide? Si oui, alors vous êtes inapte, sinon vous êtes en forme. Et si vous avez plus de 40 ans, faites-vous de l'exercice? Si oui, alors vous êtes en forme, sinon vous êtes inapte. Il s'agissait essentiellement d'une classification binaire.

Il existe deux types d'arbres de décision:

- Arbres de classification: l' exemple ci-dessus est un arbre de classification catégoriel.

- Arbres de régression : dans ce type d'algorithme, la décision ou le résultat est continu. Il a une seule sortie numérique avec plus d'entrées ou de prédicteurs.

Dans l'arbre de décision, le défi typique consiste à identifier l'attribut à chaque nœud. Le processus est appelé sélection d'attribut et a quelques mesures à utiliser pour identifier l'attribut.

une. Gain d'information (IG)

Le gain d'information mesure la quantité d'informations qu'une caractéristique individuelle donne sur la classe. Il agit comme la clé principale pour construire un arbre de décision. Un attribut avec le gain d'information le plus élevé se divise en premier. Ainsi, l'arbre de décision maximise toujours le gain d'informations. Lorsque nous utilisons un nœud pour partitionner les instances en sous-ensembles plus petits, l'entropie change.

Entropie: C'est la mesure de l'incertitude ou de l'impureté dans une variable aléatoire. L'entropie décide comment un arbre de décision divise les données en sous-ensembles.

L'équation pour le gain d'information et l'entropie est la suivante:

Gain d'information = entropie (parent) - (moyenne pondérée * entropie (enfants))

Entropie: ∑p (X) log p (X)

P (X) est ici la fraction d'exemples dans une classe donnée.

b. Index de Gini

L'index de Gini est une métrique qui décide de la fréquence à laquelle un élément choisi au hasard serait incorrectement identifié. Il indique clairement que l'attribut avec un indice de Gini faible est privilégié.

Indice de Gini: 1-∑ p (X) 2

Création fractionnée

- Pour créer une scission, nous devons d'abord calculer le score de Gini.

- Les données sont divisées à l'aide d'une liste de lignes ayant un index d'un attribut et une valeur de fractionnement de cet attribut. Une fois le jeu de données droit et gauche trouvé, nous pouvons obtenir la valeur de fractionnement par le score de Gini de la première partie. Maintenant, la valeur fractionnée sera le décideur où résidera l'attribut.

- La partie suivante évalue toutes les divisions. La meilleure valeur possible est calculée en évaluant le coût de la scission. La meilleure répartition est utilisée comme nœud de l'arbre de décision.

Construire un arbre - Arbre de décision dans l'apprentissage automatique

La construction d'un arbre de décision se déroule en deux étapes.

1. Création d'un nœud terminal

Lors de la création du nœud terminal, le plus important est de noter si nous devons arrêter de faire pousser des arbres ou continuer. Les méthodes suivantes peuvent être utilisées pour cela:

- Profondeur maximale de l'arborescence: lorsque l'arborescence atteint le nombre maximal de nœuds, l'exécution s'arrête là.

- Enregistrements de noeud minimum: il peut être défini comme un minimum de modèles requis par un noeud. Ensuite, nous pouvons arrêter d'ajouter des nœuds terminaux immédiatement, nous obtenons ces enregistrements de nœuds minimum.

2. Fractionnement récursif

Une fois que le nœud est créé, nous pouvons créer un nœud enfant récursivement en divisant l'ensemble de données et en appelant la même fonction plusieurs fois.

Prédiction

Après la construction d'un arbre, la prédiction est effectuée à l'aide d'une fonction récursive. Le même processus de prédiction est à nouveau suivi avec les nœuds enfants gauche ou droit et ainsi de suite.

Avantages et inconvénients de l'arbre de décision

Vous trouverez ci-dessous certains avantages et inconvénients:

Les avantages

L'arbre de décision présente certains avantages dans le Machine Learning:

- Complet: il prend en considération chaque résultat possible d'une décision et trace chaque nœud jusqu'à la conclusion en conséquence.

- Spécifique: les arbres de décision attribuent une valeur spécifique à chaque problème, décision et résultat (s). Il réduit l'incertitude et l'ambiguïté et augmente également la clarté.

- Simplicité: l' arbre de décision est l'un des algorithmes les plus faciles et les plus fiables car il n'a pas de formules ou de structures de données complexes. Seules des statistiques et des mathématiques simples sont requises pour le calcul.

- Polyvalent: les arbres de décision peuvent être construits manuellement en utilisant les mathématiques et peuvent également être utilisés avec d'autres programmes informatiques.

Désavantages

L'arbre de décision présente certains inconvénients dans le Machine Learning comme suit:

- Les arbres de décision sont moins appropriés pour l'estimation et les tâches financières où nous avons besoin d'une ou de valeurs appropriées.

- Il s'agit d'un algorithme de classification sujet aux erreurs par rapport à d'autres algorithmes de calcul.

- C'est coûteux en calcul. À chaque nœud, la répartition des candidats doit être triée avant de déterminer la meilleure. Il existe d'autres alternatives que de nombreuses entités commerciales suivent pour les tâches financières, car l'arbre de décision est trop coûteux pour l'évaluation.

- Tout en travaillant avec des variables continues, l'Arbre de décision n'est pas la meilleure solution car il a tendance à perdre des informations lors de la catégorisation des variables.

- Il est parfois instable car de petites variations dans l'ensemble de données peuvent conduire à la formation d'un nouvel arbre.

Conclusion - Arbre de décision dans l'apprentissage automatique

En tant que l'un des algorithmes les plus importants et supervisés, Decision Tree joue un rôle essentiel dans l'analyse des décisions dans la vie réelle. En tant que modèle prédictif, il est utilisé dans de nombreux domaines pour son approche fractionnée qui aide à identifier des solutions basées sur différentes conditions par une méthode de classification ou de régression.

Articles recommandés

Ceci est un guide de l'arbre de décision dans l'apprentissage automatique. Nous discutons ici de l'introduction, Types d'arbre de décision dans l'apprentissage automatique, création de fractionnement et construction d'un arbre. Vous pouvez également consulter nos autres articles suggérés pour en savoir plus–

- Types de données Python

- Ensembles de données Tableau

- Modélisation des données Cassandra

- Test de la table de décision

- Les 8 principales étapes du cycle de vie de l'apprentissage automatique