Différence entre TensorFlow et Spark

Qu'est-ce que TensorFlow?

TensorFlow implique une bibliothèque open source compatible Python pour le calcul numérique qui effectue un apprentissage automatique plus rapide et plus simple. TensorFlow permet aux développeurs de concevoir des graphiques de flux de données, des structures qui définissent la façon dont les données se déplacent sur un graphique, soit une série de nœuds de traitement. Un nœud individuel dans un graphique particulier signifie une opération mathématique. De plus, tous les points, soit l'association entre les nœuds, impliquent un tenseur multidimensionnel, de préférence une collecte de données. TensorFlow donne tout cela pour le développeur à travers un moyen du langage populaire, Python. Ce langage est simple à utiliser et facile à apprendre et offre des approches acceptables pour représenter par lesquelles des abstractions de haut niveau peuvent être liées à des tenseurs, et les nœuds sont collectivement des objets Python dans TensorFlow.

De plus, les applications de TensorFlow restent elles-mêmes des applications Python. En Python, les opérations mathématiques correctes, cependant, ne sont pas implémentées. Les modifications dans les bibliothèques accessibles via TensorFlow sont composées de la même manière que les binaires C ++ avec des performances plus élevées. Python fournit des abstractions de programmation de haut niveau en dirigeant directement le trafic entre les pièces et en les sécurisant ensemble. Les applications de TensorFlow peuvent être exploitées sur presque toutes les cibles accessibles: une machine locale, iOS, un cluster dans le cloud, des processeurs ou GPU et des appareils Android. Si le cloud privé de Google est familier, pour une accélération supplémentaire, vous pouvez exécuter le silicium TPU (TensorFlow Processing Unit) personnalisé de Google vers TensorFlow. Et puis, les modèles résultants développés par TensorFlow, cependant, peuvent être déployés sur la plupart des appareils où ils seront gérés pour servir les prévisions.

Qu'est-ce que Spark?

Apache Spark est un système informatique en grappe à haute vitesse et à usage général. Il fournit des API de haut niveau dans Scala, Python, Java et R, et un moteur optimisé qui favorise les graphiques d'exécution généraux. Il aide également un ensemble riche d'outils de niveau supérieur, notamment MLlib pour l'apprentissage automatique, GraphX pour le traitement des graphiques, et Spark SQL pour SQL et le traitement de données structurées, Spark Streaming. Apache Spark a pour base structurelle le jeu de données réparties résilient (RDD), un multiset en lecture seule d'éléments de données dispersés sur un cluster de machines, qui maintient d'une manière tolérante aux pannes. Dans Spark 1.x, le RDD a fait l'interface de programmation d'application (API) initiale, cependant, à partir de l'utilitaire Spark 2.x du jeu de données, l'API est prise en charge même si cette API RDD n'est pas déconseillée. La technologie RDD détient toujours l'API Dataset. Spark a également créé ses RDD en 2012 en réponse aux restrictions de la norme de calcul de cluster MapReduce, qui force une structure de flux de données linéaire appropriée sur les programmes partagés: les programmes MapReduce analysent les données d'entrée du disque, mappent une fonction sur les données, diminuent les résultats de la carte, stockez en outre les résultats de réduction vers le disque.

Les RDD de Spark fonctionnent comme un ensemble de travail essentiellement pour les programmes distribués qui contribuent à une forme (délibérément) limitée de mémoire partagée allouée. Spark favorise la mise en œuvre à la fois d'algorithmes itératifs, qui visitent leur ensemble de données à plusieurs reprises dans une boucle, et l'analyse de données interactive / exploratoire, c'est-à-dire l'interrogation de données de style base de données répliquée. La latence de ces applications peut être réduite de plusieurs ordres de grandeur associés à une implémentation MapReduce (comme cela était courant dans les piles Apache Hadoop). Avec la classe des algorithmes itératifs sont les algorithmes de base pour les systèmes d'apprentissage automatique, qui ont créé l'impulsion principale pour développer Apache Spark.

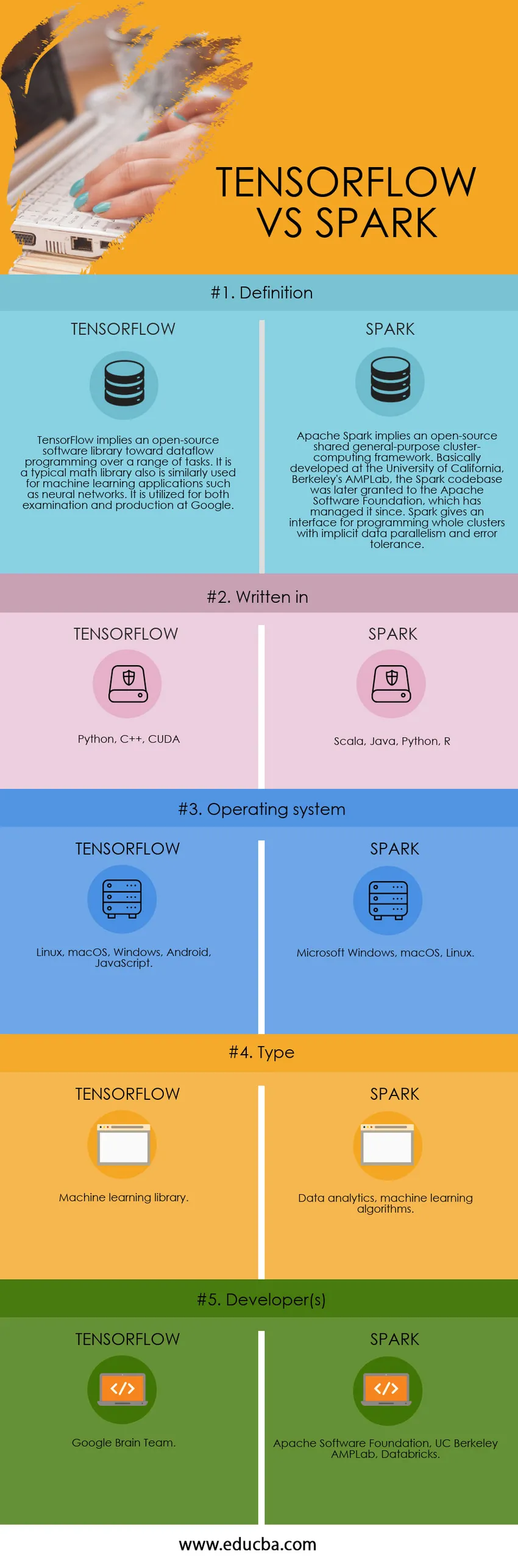

Comparaison directe entre TensorFlow et Spark (infographie)

Ci-dessous est la différence entre les 5 meilleurs TensorFlow et Spark

Différences clés entre TensorFlow et Spark

Les deux TensorFlow vs Spark sont des choix populaires sur le marché; laissez-nous discuter de certaines des principales différences entre TensorFlow vs Spark

- Apache Spark, de préférence Spark, car il est communément appelé framework d'informatique en grappes open source qui fournit une interface pour des clusters de programmation entiers avec un parallélisme de données implicite et une tolérance aux pannes.TensorFlow, d'autre part, est une bibliothèque compacte développée par Google qui aide en améliorant les performances du calcul numérique, même les réseaux de neurones et en générant un flux de données sous forme de graphiques, composé de nœuds indiquant les opérations et les bords signifiant le tableau de données.

- Spark, essentiellement un grand cadre de données, a permis à un grand nombre de sociétés générant une quantité massive de données utilisateur de les traiter efficacement et de proposer des recommandations à grande échelle. Alors que, Tensorflow, essentiellement un cadre d'apprentissage automatique, il aide les gens à créer des modèles d'apprentissage étendus sans avoir besoin des compétences rigoureuses d'un spécialiste de l'apprentissage automatique.

- Dans Spark, un moteur rapide et complet pour le traitement de données à grande échelle permet diverses fonctionnalités telles que le streaming et des analyses sophistiquées, haute vitesse, facilité d'utilisation, il peut se connecter à SQL, peut fonctionner partout comme Mesos, Hadoop et le cloud. D'autre part, dans Tensorflow, une API Google permettant le calcul sur un excellent apprentissage et l'apprentissage machine, TensorFlow donne un flux de calcul de représentation graphique. L'API encourage l'utilisateur à écrire une conception de réseau neuronal complexe et à l'ajuster en fonction des valeurs d'activation.

- Tensorflow écrit en Python, C ++, CUDA. En revanche, Spark est écrit en Scala, Java, Python, R

- TensorFlow On Spark résout la difficulté de déployer un apprentissage de haut niveau sur des clusters de données importants de manière distribuée, ce qui n'est pas un paradigme de connaissances robuste entièrement moderne, mais de préférence une mise à niveau des cadres actuels qui nécessitaient le développement de divers programmes pour développer l'intelligence sur des groupes de données importants. En connectant les deux TensorFlow et Spark, il offre une portée à la complexité du système indésirable ainsi qu'à une latence d'apprentissage de bout en bout.

Tableau de comparaison TensorFlow vs Spark

Vous trouverez ci-dessous la comparaison 5 supérieure entre TensorFlow et Spark

| La base de comparaison entre TensorFlow vs Spark |

TENSORFLOW |

ÉTINCELLE |

| Définition | TensorFlow implique une bibliothèque de logiciels open source vers la programmation de flux de données sur une gamme de tâches. Il s'agit d'une bibliothèque mathématique typique qui est également utilisée de manière similaire pour des applications d'apprentissage automatique telles que les réseaux de neurones. Il est utilisé à la fois pour l'examen et la production chez Google. | Apache Spark implique un cadre de calcul en cluster partagé et open source. Fondamentalement développé à l'Université de Californie, l'AMPLab de Berkeley, la base de code Spark a ensuite été accordée à l'Apache Software Foundation, qui l'a géré depuis. Spark fournit une interface pour programmer des clusters entiers avec un parallélisme de données implicite et une tolérance aux erreurs. |

| Écrit en | Python, C ++, CUDA | Scala, Java, Python, R |

| Système opérateur | Linux, macOS, Windows, Android, JavaScript | Microsoft Windows, macOS, Linux |

| Type | Bibliothèque d'apprentissage automatique | Analyse des données, algorithmes d'apprentissage automatique |

| Développeur (s) | Google Brain Team | Fondation Apache Software, UC Berkeley AMPLab, Databricks |

Conclusion

En résumé, Apache Spark implique un cadre de traitement des données, tandis que TensorFlow est utilisé pour un excellent apprentissage personnalisé et une conception de réseau de neurones. Par conséquent, si un utilisateur a besoin de mettre en œuvre des algorithmes d'apprentissage en profondeur, TensorFlow est la solution, et pour le traitement des données, c'est Spark.

Articles recommandés

Cela a été un guide pour la principale différence entre TensorFlow et Spark. Ici, nous discutons également des principales différences entre TensorFlow et Spark avec des infographies et un tableau de comparaison. Vous pouvez également consulter les articles suivants pour en savoir plus.

- Tensorflow vs Pytorch

- Splunk vs Spark

- SOAP vs WSDL

- Hadoop vs Spark

- Top 7 des méthodes architecturales pour l'apprentissage en profondeur