Différence entre la science des données et l'apprentissage automatique

La science des données est une extension évolutive des statistiques capable de faire face à des quantités massives à l'aide des technologies informatiques. L'apprentissage automatique est un domaine d'étude qui donne aux ordinateurs la possibilité d'apprendre sans être explicitement programmé. La science des données couvre un large éventail de technologies de données, y compris SQL, Python, R et Hadoop, Spark, etc. L'apprentissage automatique est considéré comme un processus, il peut être défini comme le processus par lequel un ordinateur peut fonctionner plus précisément lorsqu'il collecte et apprend des données qui lui sont données.

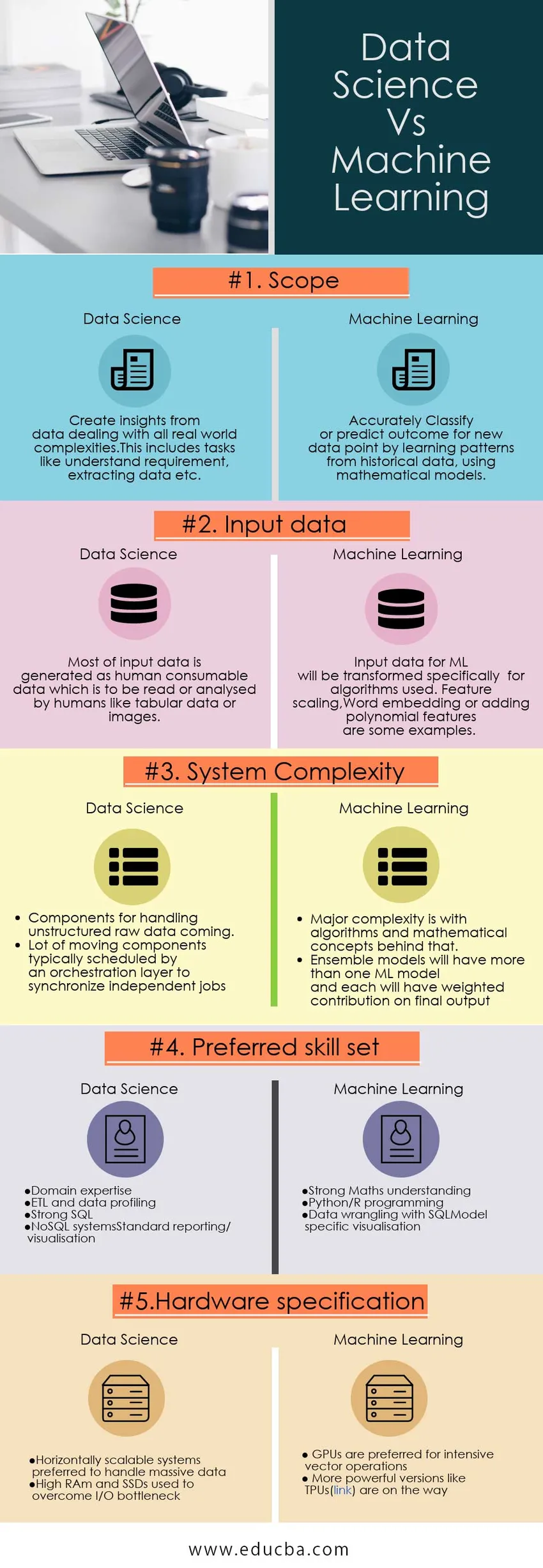

Comparaison directe de la science des données et de l'apprentissage automatique (infographie)

Ci-dessous se trouve le top 5 de la comparaison entre la science des données et l'apprentissage automatique

Différence clé entre la science des données et l'apprentissage automatique

Vous trouverez ci-dessous la différence entre la science des données et l'apprentissage automatique.

- Composants - Comme mentionné précédemment, les systèmes Data Science couvrent l'intégralité du cycle de vie des données et ont généralement des composants pour couvrir les éléments suivants:

- Collecte et profilage des données - Pipelines ETL (Extract Transform Load) et travaux de profilage

- Informatique distribuée - Distribution et traitement des données évolutives horizontalement

- Automatisation de l'intelligence - Modèles ML automatisés pour les réponses en ligne (prédiction, recommandations) et la détection des fraudes.

- Visualisation des données - Explorez visuellement les données pour obtenir une meilleure intuition des données.La partie intégrante de la modélisation ML.

- Tableaux de bord et BI - Tableaux de bord prédéfinis avec capacité de découpage et de dés pour les parties prenantes de niveau supérieur.

- Ingénierie des données - S'assurer que les données chaudes et froides sont toujours accessibles. Couvre la sauvegarde des données, la sécurité, la reprise après sinistre

- Déploiement en mode production - Migrez le système en production avec les pratiques standard de l'industrie.

- Décisions automatisées - Cela inclut l'exécution de la logique métier sur des données ou un modèle mathématique complexe formé à l'aide de n'importe quel algorithme ML.

La modélisation du Machine Learning commence avec les données existantes et les composants typiques sont les suivants:

- Comprendre le problème - Assurez-vous que le moyen efficace de résoudre le problème est le ML. Notez que tous les problèmes ne peuvent pas être résolus avec ML.

- Explorez les données - Pour obtenir une intuition des fonctionnalités à utiliser dans le modèle ML. Cela peut nécessiter plus d'une itération. La visualisation des données joue ici un rôle essentiel.

- Préparer les données - Il s'agit d'une étape importante avec un impact élevé sur la précision du modèle ML. Il traite des problèmes de données comme que faire des données manquantes pour une fonctionnalité? Remplacez par une valeur fictive telle que zéro ou la moyenne d'autres valeurs ou supprimez la fonction du modèle?. La mise à l'échelle des fonctionnalités, qui garantit que les valeurs de toutes les fonctionnalités sont dans la même plage, est essentielle pour de nombreux modèles ML.Beaucoup d'autres techniques comme la génération de fonctionnalités polynomiales sont également utilisées ici pour dériver de nouvelles fonctionnalités.

- Sélectionner un modèle et former - Le modèle est sélectionné en fonction d'un type de problème (prédiction ou classification, etc.) et du type d'ensemble de fonctionnalités (certains algorithmes fonctionnent avec un petit nombre d'instances avec un grand nombre de fonctionnalités et d'autres dans d'autres cas) .

- Mesure de performance - Dans la science des données, les mesures de performance ne sont pas standardisées, elles changeront au cas par cas, ce sera généralement une indication de l'actualité des données, de la qualité des données, de la capacité d'interrogation, des limites de concurrence dans l'accès aux données, de la capacité de visualisation interactive, etc.

Dans les modèles ML, les mesures de performance sont limpides.Chaque algorithme aura une mesure pour indiquer dans quelle mesure le modèle décrit les données d'entraînement données.Par exemple, RME (Root Mean Square Error) est utilisé dans la régression linéaire comme indication d'un erreur dans le modèle.

- Méthodologie de développement - Les projets de science des données sont davantage alignés sur un projet d'ingénierie avec des étapes clairement définies, mais les projets de ML sont plutôt sur le modèle de la recherche, qui commencent par une hypothèse et tentent de la prouver avec les données disponibles.

- Visualisation - La visualisation en général Data Science représente les données directement à l'aide de graphiques populaires comme les barres, les tartes, etc. Mais en ML, les visualisations également utilisées représentent un modèle mathématique des données de formation. Par exemple, la visualisation de la matrice de confusion d'une classification multiclasse permet d'identifier rapidement les faux positifs et négatifs.

- Langages - Les langages de syntaxe SQL et SQL (HiveQL, Spark SQL, etc.) sont les langages les plus utilisés dans le monde de la science des données.Les langages de script de traitement de données populaires comme Perl, awk, sed sont également utilisés.Les langages bien pris en charge spécifiques au cadre en sont un autre. largement utilisé (Java pour Hadoop, Scala pour Spark, etc.).

Python et R sont les langages les plus utilisés dans le monde du Machine Learning.Aujourd'hui, Python prend de l'ampleur alors que les nouveaux chercheurs en deep learning sont principalement convertis en python.SQL joue également un rôle important dans la phase d'exploration des données de ML

Tableau comparatif Data Science vs Machine Learning

| Base de comparaison | Science des données | Apprentissage automatique |

| Portée | Créez des informations à partir de données traitant de toutes les complexités du monde réel, notamment des tâches telles que la compréhension des exigences, l'extraction de données, etc. | Classer avec précision ou prédire le résultat de nouveaux points de données en apprenant des modèles à partir de données historiques, en utilisant des modèles mathématiques. |

| Des données d'entrée | La plupart des données d'entrée sont générées sous forme de données consommables humaines qui doivent être lues ou analysées par des humains comme des données tabulaires ou des images. | Les données d'entrée pour ML seront transformées spécifiquement pour les algorithmes utilisés. Mise à l'échelle des fonctionnalités, intégration de Word ou ajout de fonctionnalités polynomiales en sont quelques exemples |

| Complexité du système | ● Composants pour la gestion des données brutes non structurées à venir.

● Beaucoup de composants mobiles généralement planifiés par une couche d'orchestration pour synchroniser des travaux indépendants | ● La complexité majeure réside dans les algorithmes et les concepts mathématiques

● Les modèles d'ensemble auront plus d'un modèle ML et chacun aura une contribution pondérée sur la production finale |

| Ensemble de compétences préféré | ● Expertise de domaine

● ETL et profilage des données ● SQL fort ● Systèmes NoSQL ● Rapports / visualisation standard | ● Bonne compréhension des mathématiques

● Programmation Python / R ● Conflit de données avec SQL ● Visualisation spécifique au modèle |

| Spécifications matérielles | ● Systèmes évolutifs horizontalement préférés pour gérer des données massives

● RAm élevé et SSD utilisés pour surmonter le goulot d'étranglement d'E / S | ● Les GPU sont préférés pour les opérations vectorielles intensives

● Des versions plus puissantes comme les TPU (lien) sont en route |

Conclusion - Data Science vs Machine Learning

Dans les domaines de la science des données et de l'apprentissage automatique, nous essayons d'extraire des informations et des idées à partir des données. Apprentissage automatique essayant de faire apprendre les algorithmes par eux-mêmes.Actuellement, des modèles ML avancés sont appliqués à Data Science pour détecter et profiler automatiquement les données.Le Cloud Dataprep de Google en est le meilleur exemple.

Article recommandé:

Il s'agit d'un guide de la science des données par rapport à l'apprentissage automatique, de leur signification, de leur comparaison directe, des principales différences, du tableau de comparaison et de la conclusion. Vous pouvez également consulter les articles suivants pour en savoir plus -

- Questions d'entretiens pour le poste de Hadoop developer

- Big Data vs Data Science - En quoi sont-ils différents?

- La science des données et son importance croissante

- Statistiques vs Machine Learning-Différences entre

- Comment cracker l'interview du développeur Hadoop?