Présentation d'Install Hadoop

L'article suivant, Installer Hadoop fournit un aperçu des modules clés de structure Hadoop les plus courants et une installation pas à pas pour Hadoop. L'Apache Hadoop est une collection de logiciels qui permet de traiter de grands ensembles de données et un stockage distribué sur un cluster de différents types de système informatique. À l'heure actuelle, Hadoop demeure la plate-forme d'analyse la plus utilisée pour les mégadonnées («Sanchita Lobo, auteur sur Analytics Training Blog», sd).

Cadre Hadoop

Le framework Apache Hadoop comprend les modules clés suivants.

- Apache Hadoop Common.

- Système de fichiers distribués Apache Hadoop (HDFS).

- Apache Hadoop MapReduce

- Apache Hadoop YARN (encore un autre gestionnaire de ressources).

Apache Hadoop Common

Le module Apache Hadoop Common se compose de bibliothèques partagées qui sont utilisées par tous les autres modules, y compris la gestion des clés, les packages d'E / S génériques, les bibliothèques pour la collecte de mesures et les utilitaires pour le registre, la sécurité et la diffusion en continu.

HDFS

Le HDFS est basé sur le système de fichiers Google et est structuré pour fonctionner sur du matériel à faible coût. HDFS tolère les pannes et est conçu pour les applications ayant de grands ensembles de données.

MapReduce

MapReduce est un modèle de programmation parallèle inhérent au traitement des données et Hadoop peut exécuter des programmes MapReduce écrits dans divers langages tels que Java. MapReduce fonctionne en divisant le traitement en phase de carte et réduit la phase.

Apache Hadoop YARN

Apache Hadoop YARN est un composant central et est une technologie de gestion des ressources et de planification des travaux dans le cadre de traitement distribué Hadoop.

Dans cet article, nous allons discuter de l'installation et de la configuration de Hadoop 2.7.4 sur un cluster à nœud unique et tester la configuration en exécutant le programme MapReduce appelé wordcount pour compter le nombre de mots dans le fichier. Nous examinerons en outre quelques commandes importantes du système de fichiers Hadoop.

Étapes pour installer Hadoop

Ce qui suit est un résumé des tâches impliquées dans la configuration d'Apache Hadoop.

Tâche 1: La première tâche de l'installation Hadoop comprenait la configuration d'un modèle de machine virtuelle configuré avec Cent OS7. Des packages tels que Java SDK 1.8 et les systèmes d'exécution requis pour exécuter Hadoop ont été téléchargés et la variable d'environnement Java pour Hadoop a été configurée en modifiant bash_rc.

Tâche 2: le package Hadoop version 2.7.4 a été téléchargé à partir du site Web d'Apache et a été extrait dans le dossier opt. Qui a ensuite été renommé Hadoop pour un accès facile.

Tâche 3: Une fois les packages Hadoop extraits, l'étape suivante consistait à configurer la variable d'environnement pour l'utilisateur Hadoop, puis à configurer les fichiers XML du nœud Hadoop. Dans cette étape, NameNode a été configuré dans core-site.xml et DataNode a été configuré dans hdfs-site.xml. Le gestionnaire de ressources et le gestionnaire de nœuds ont été configurés dans yarn-site.xml.

Tâche 4: le pare-feu a été désactivé pour démarrer YARN et DFS. La commande JPS a été utilisée pour vérifier si les démons pertinents s'exécutent en arrière-plan. Le numéro de port pour accéder à Hadoop a été configuré sur http: // localhost: 50070 /

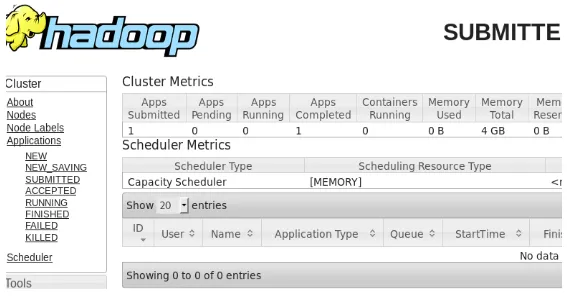

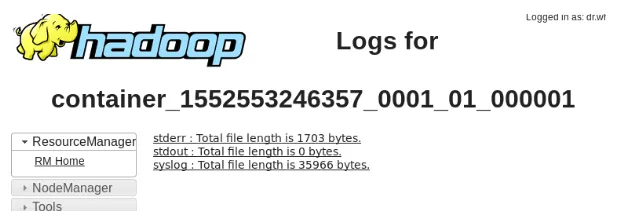

Tâche 5: les étapes suivantes ont été utilisées pour vérifier et tester Hadoop. Pour cela, nous avons créé un fichier de test temporaire dans le répertoire d'entrée du programme WordCount. Le programme de réduction de carte Hadoop-MapReduce-examples2.7.4.jar a été utilisé pour compter le nombre de mots dans le fichier. Les résultats ont été évalués sur l'hôte local et les journaux de la demande soumise ont été analysés. Toutes les demandes MapReduce soumises peuvent être consultées sur l'interface en ligne, le numéro de port par défaut étant 8088.

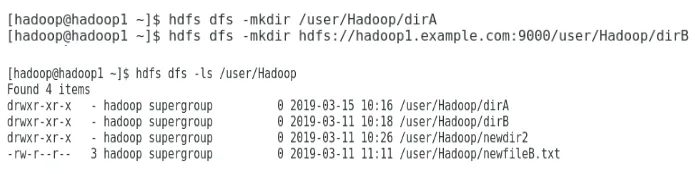

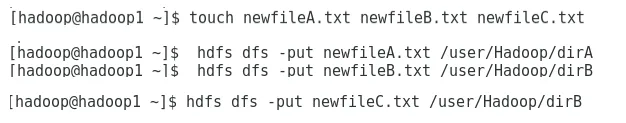

Tâche 6: dans la dernière tâche, nous allons présenter quelques commandes de base du système de fichiers Hadoop et vérifier leurs utilisations. Nous verrons comment un répertoire peut être créé dans le système de fichiers Hadoop, pour lister le contenu d'un répertoire, sa taille en octets. Nous verrons plus loin comment supprimer un répertoire et un fichier spécifiques.

Résultats dans l'installation Hadoop

Voici les résultats de chacune des tâches ci-dessus:

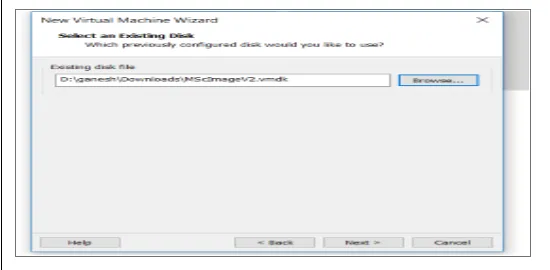

Résultat de la tâche 1

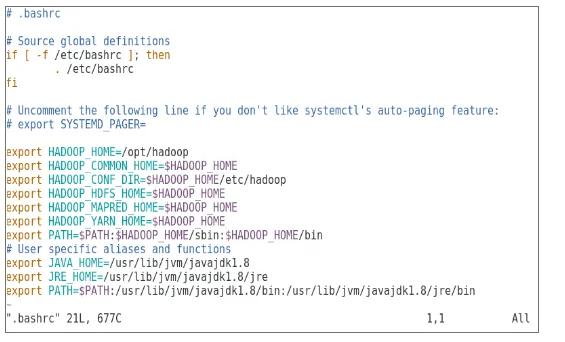

Une nouvelle machine virtuelle avec une image cenOS7 a été configurée pour exécuter Apache Hadoop. La figure 1 montre comment l'image CenOS 7 a été configurée dans la machine virtuelle. La figure 1.2 montre la configuration des variables d'environnement JAVA dans .bash_rc.

Figure 1: configuration de la machine virtuelle

Figure 1.2: Configuration des variables d'environnement Java

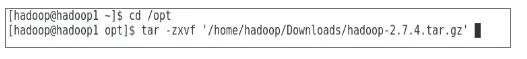

Résultat de la tâche 2

La figure 2 montre la tâche effectuée pour extraire le package Hadoop 2.7.4 dans le dossier opt.

Figure 2: Extraction du package Hadoop 2.7.4

Résultat de la tâche 3

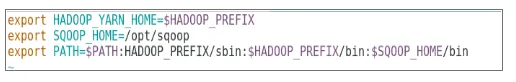

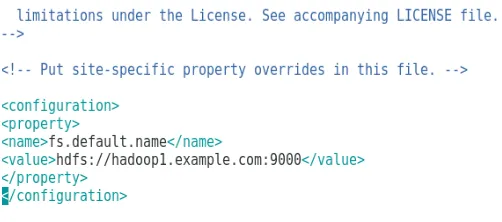

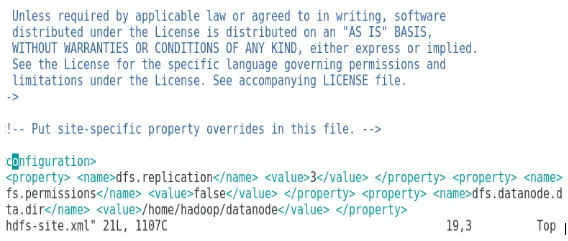

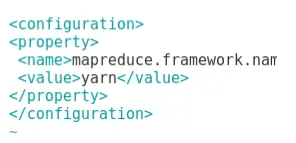

La figure 3 montre la configuration de la variable d'environnement pour l'utilisateur Hadoop, la figure 3.1 à 3.4 montre la configuration des fichiers XML requis pour la configuration Hadoop.

Figure 3: Configuration de la variable d'environnement pour l'utilisateur Hadoop

Figure 3.1: Configuration de core-site.xml

Figure 3.2: Configuration de hdfs-site.xml

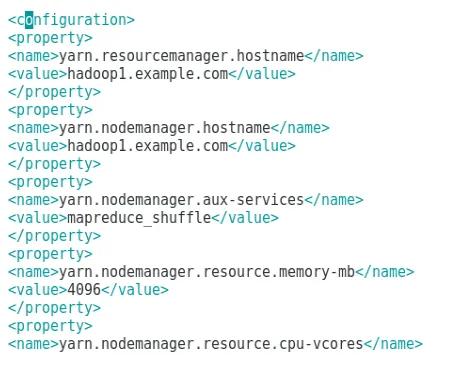

Figure 3.3: Configuration du fichier mapred-site.xml

Figure 3.4: Configuration du fichier yarn-site.xml

Résultat de la tâche 4

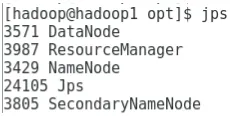

La figure 4 montre l'utilisation de la commande jps pour vérifier que les démons pertinents fonctionnent en arrière-plan et la figure suivante montre l'interface utilisateur en ligne de Hadoop.

Figure 4: commande jps pour vérifier les démons en cours d'exécution.

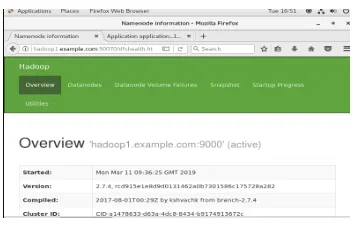

Figure 4.1: Accès à l'interface en ligne Hadoop sur le port http://hadoop1.example.com:50070/

Résultat de la tâche 5

La figure 5 montre le résultat du programme MapReduce appelé wordcount qui compte le nombre de mots dans le fichier. Les deux chiffres suivants affichent l'interface utilisateur en ligne du gestionnaire de ressources YARN pour la tâche soumise.

Figure 5: Résultats du programme MapReduce

Figure 5.1: Application de réduction de carte soumise.

Figure 5.2: Journaux de l'application MapReduce soumise.

Résultat de la tâche 6

La figure 6 montre comment créer un répertoire dans le système de fichiers Hadoop et effectuer une liste du répertoire hdfs.

Figure 6: création d'un répertoire dans le système de fichiers Hadoop

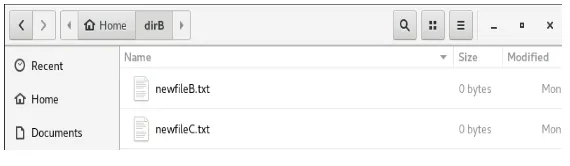

La figure 6.1 montre comment placer un fichier sur le système de fichiers distribué Hadoop et la figure 6.2 montre le fichier créé dans le répertoire dirB.

Figure 6.1: Création d'un fichier dans HDFS.

Figure 6.2: Nouveau fichier créé.

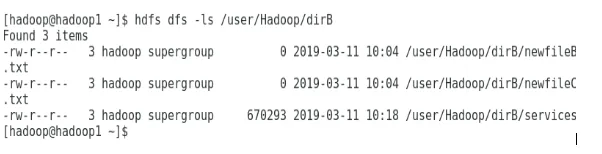

Les figures suivantes montrent comment lister le contenu de répertoires particuliers:

Figure 6.3: Contenu de dirA

Figure 6.4: Contenu de dirB

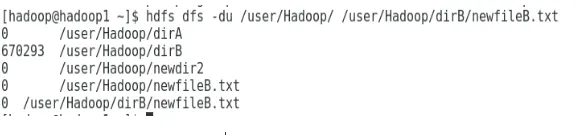

La figure suivante montre comment la taille du fichier et du répertoire peut être affichée:

Figure 6.5: Affichez la taille d'un fichier et d'un répertoire.

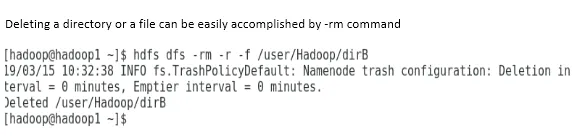

La suppression d'un répertoire ou d'un fichier peut être facilement effectuée par la commande -rm.

Figure 6.6: Pour supprimer un fichier.

Conclusion

Le Big Data a joué un rôle très important dans la formation du marché mondial actuel. Le framework Hadoop facilite la vie de l'analyste de données tout en travaillant sur de grands ensembles de données. La configuration d'Apache Hadoop était assez simple et l'interface utilisateur en ligne offrait à l'utilisateur plusieurs options pour régler et gérer l'application. Hadoop a été utilisé massivement dans les organisations pour le stockage de données, les analyses d'apprentissage automatique et la sauvegarde de données. La gestion d'une grande quantité de données a été très pratique en raison de l'environnement distribué Hadoop et de MapReduce. Le développement Hadoop était assez étonnant par rapport aux bases de données relationnelles car elles manquent d'options de réglage et de performances. Apache Hadoop est une solution conviviale et peu coûteuse pour gérer et stocker efficacement les mégadonnées. HDFS contribue également grandement au stockage des données.

Articles recommandés

Ceci est un guide pour installer Hadoop. Nous discutons ici de l'introduction à Instal Hadoop, de l'installation étape par étape de Hadoop ainsi que des résultats de l'installation de Hadoop. Vous pouvez également consulter nos autres articles suggérés pour en savoir plus -

- Introduction au streaming Hadoop

- Qu'est-ce que le cluster Hadoop et comment fonctionne-t-il?

- Écosystème Apache Hadoop et ses composants

- Quelles sont les alternatives Hadoop?