Qu'est-ce que la technologie Big Data?

Comme nous le savons, les données évoluent constamment. La croissance des données a mis les esprits humains au défi d'extraire, d'analyser et de gérer cela. En effet, les méthodes traditionnelles de traitement des données ne prennent pas en charge ces données volumineuses. Les mégadonnées sont généralement décrites par trois concepts: volume, variété et vitesse.

Les données sont désormais devenues l'actif le plus important de chaque entreprise. Analyser ces mégadonnées pour aider l'entreprise à analyser le comportement de leurs clients et prédire les éléments pertinents associés à ces décisions basées sur les données rendent l'organisation, prennent des mesures plus confiantes et élaborent des stratégies plus solides.

Connaissant le rythme avec lequel les données augmentent à l'ère actuelle, les mégadonnées seront un domaine géant dans lequel travailler dans un proche avenir. Tous les étudiants, débutants et professionnels seront nécessaires pour se tenir au courant des technologies émergentes du Big Data. Se tenir à jour apportera une belle carrière réussie dans son cheminement professionnel.

Technologies Big Data

Ici, je répertorie quelques technologies de Big Data avec une explication lucide à ce sujet, pour vous informer des tendances et technologies à venir:

-

Apache Spark:

C'est un moteur de traitement rapide des mégadonnées. Ceci est construit en gardant à l'esprit le traitement en temps réel des données. Sa riche bibliothèque de Machine Learning est bonne pour travailler dans l'espace de l'IA et du ML. Il traite les données en parallèle et sur des ordinateurs en cluster. Le type de données de base utilisé par Spark est RDD (ensemble de données réparties résilientes).

-

Bases de données NoSQL:

Il s'agit de bases de données non relationnelles qui permettent un stockage et une récupération rapides des données. Sa capacité à traiter toutes sortes de données telles que les données structurées, semi-structurées, non structurées et polymorphes est unique. Aucune base de données SQL n'est des types suivants:

- Bases de données de documents : il stocke les données sous forme de documents qui peuvent contenir de nombreuses paires clé-valeur différentes.

- Stocks de graphiques : il stocke des données qui sont généralement stockées sous forme de réseau, telles que des données de médias sociaux.

- Magasins de valeurs-clés : ce sont les bases de données NoSQL les plus simples. Chaque élément de la base de données est stocké en tant que nom d'attribut (ou «clé»), avec sa valeur.

- Magasins à colonnes larges : cette base de données stocke les données au format en colonnes plutôt qu'au format basé sur les lignes. Cassandra et HBase en sont de bons exemples.

-

Apache Kafka:

Kafka est une plateforme de streaming d'événements distribuée qui gère de nombreux événements chaque jour. Comme il est rapide et évolutif, cela est utile pour créer des pipelines de données en streaming en temps réel qui récupèrent de manière fiable les données entre les systèmes ou les applications.

-

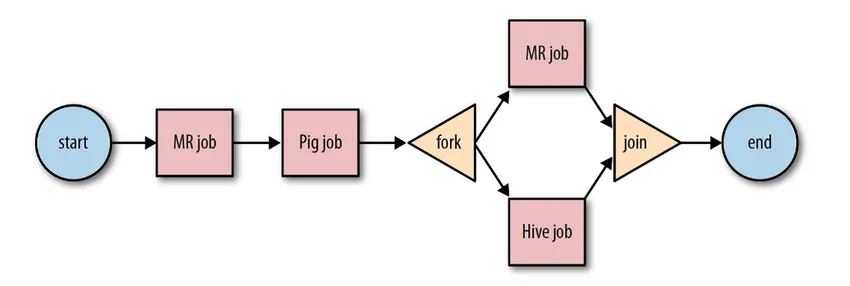

Apache Oozie:

Il s'agit d'un système de planificateur de workflow pour gérer les travaux Hadoop. Ces travaux de workflow sont planifiés sous forme de graphiques acycliques dirigés (DAG) pour les actions.

Source: Google

Sa solution évolutive et organisée pour les activités Big Data.

-

Apache Airflow:

Il s'agit d'une plateforme qui planifie et surveille le flux de travail. La planification intelligente aide à organiser efficacement l'exécution du projet. Airflow possède la capacité de réexécuter une instance DAG en cas d'échec. Son interface utilisateur riche facilite la visualisation des pipelines fonctionnant à différentes étapes comme la production, le suivi des progrès et le dépannage des problèmes en cas de besoin.

-

Faisceau Apache:

C'est un modèle unifié, pour définir et exécuter des pipelines de traitement de données qui incluent ETL et le streaming continu. Le framework Apache Beam fournit une abstraction entre la logique de votre application et l'écosystème du Big Data, car il n'existe aucune API qui lie tous les frameworks comme Hadoop, Spark, etc.

-

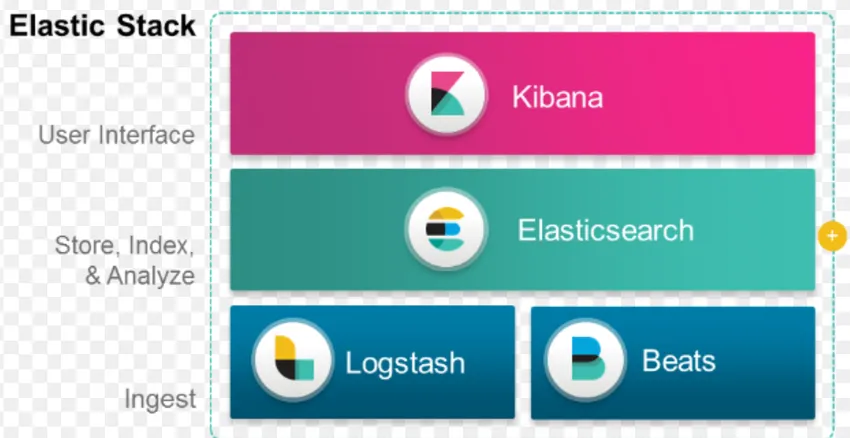

Pile ELK:

ELK est connu pour Elasticsearch, Logstash et Kibana.

Elasticsearch est une base de données sans schéma (qui indexe chaque champ) qui dispose de puissantes capacités de recherche et facilement évolutive.

Logstash est un outil ETL qui nous permet de récupérer, transformer et stocker des événements dans Elasticsearch.

Kibana est un outil de tableau de bord pour Elasticsearch, où vous pouvez analyser toutes les données stockées. Les informations exploitables extraites de Kibana aident à élaborer des stratégies pour une organisation. De la capture des changements à la prédiction, Kibana s'est toujours avéré très utile.

-

Docker & Kubernete:

Ce sont les technologies émergentes qui aident les applications à s'exécuter dans des conteneurs Linux. Docker est une collection open source d'outils qui vous aident à «créer, expédier et exécuter n'importe quelle application, n'importe où».

Kubernetes est également une plate-forme de conteneur / orchestration open source, permettant à un grand nombre de conteneurs de travailler ensemble en harmonie. Cela réduit finalement la charge opérationnelle.

-

TensorFlow:

Il s'agit d'une bibliothèque d'apprentissage automatique open source qui est utilisée pour concevoir, construire et former des modèles d'apprentissage en profondeur. Tous les calculs sont effectués dans TensorFlow avec des graphiques de flux de données. Les graphiques comprennent des nœuds et des bords. Les nœuds représentent des opérations mathématiques, tandis que les bords représentent les données.

TensorFlow est utile pour la recherche et la production. Il a été conçu en gardant à l'esprit qu'il pouvait fonctionner sur plusieurs processeurs ou GPU et même sur des systèmes d'exploitation mobiles. Cela pourrait être implémenté en Python, C ++, R et Java.

-

Presto:

Presto est un moteur SQL open source développé par Facebook, qui est capable de gérer des pétaoctets de données. Contrairement à Hive, Presto ne dépend pas de la technique MapReduce et donc plus rapide dans la récupération des données. Son architecture et son interface sont suffisamment simples pour interagir avec d'autres systèmes de fichiers.

En raison de la faible latence et de la requête interactive facile, il devient de nos jours très populaire pour la gestion des mégadonnées.

-

Polybase:

Polybase fonctionne au-dessus de SQL Server pour accéder aux données stockées dans PDW (Parallel Data Warehouse). PDW conçu pour traiter n'importe quel volume de données relationnelles et offre une intégration avec Hadoop.

-

Ruche:

Hive est une plate-forme utilisée pour la requête et l'analyse de données sur de grands ensembles de données. Il fournit un langage de requête de type SQL appelé HiveQL, qui est converti en interne en MapReduce puis traité.

Avec la croissance rapide des données et l'effort énorme de l'organisation pour analyser les mégadonnées, la technologie a introduit tellement de technologies arrivées à maturité sur le marché que les connaître est extrêmement avantageux. De nos jours, la technologie Big Data répond à de nombreux besoins et problèmes de l'entreprise, en augmentant l'efficacité opérationnelle et en prédisant le comportement pertinent. Une carrière dans le Big Data et ses technologies associées peut ouvrir de nombreuses portes d'opportunités pour la personne ainsi que pour les entreprises.

Désormais, il est grand temps d'adopter les technologies du big data.

Articles recommandés

Ceci a été un guide sur ce qu'est la technologie Big Data. Ici, nous avons discuté de quelques technologies de Big Data comme Hive, Apache Kafka, Apache Beam, ELK Stack, etc. Vous pouvez également consulter l'article suivant pour en savoir plus -

- Qu'est-ce que le Deep Learning?

- Guide de Minitab?

- Qu'est-ce que la technologie Salesforce?

- Qu'est-ce que l'analyse Big Data?