Qu'est-ce que Hadoop?

Cinq mesures de Hadoop sont le volume, la variété, la vitesse, la véracité et la valeur. Les données augmentent rapidement et se présentent sous un format structuré, non structuré et semi-structuré. Les données augmentent à grande vitesse et nous devrions obtenir un aperçu significatif des données. Les données doivent avoir une certaine valeur, mais certaines incohérences et incertitudes sont présentes dans les données. Les systèmes traditionnels qui stockent des données ne sont pas en mesure de stocker ces données en augmentation rapide en raison de l'espace de stockage. Le système traditionnel n'est pas en mesure de traiter les données dans une structure de données complexe et il faut énormément de temps pour traiter les données. Hadoop résoudrait le problème du système de base de données traditionnel. Hadoop est un framework qui traite une énorme quantité de données en parallèle et les stocke dans un environnement distribué. Hadoop a deux composants 1) HDFS (stocker les données sur un cluster) 2) MapReduce (traiter les données en parallèle). HDFS stockera les données sous la forme de différents blocs. La taille de bloc par défaut est de 128 Mo.

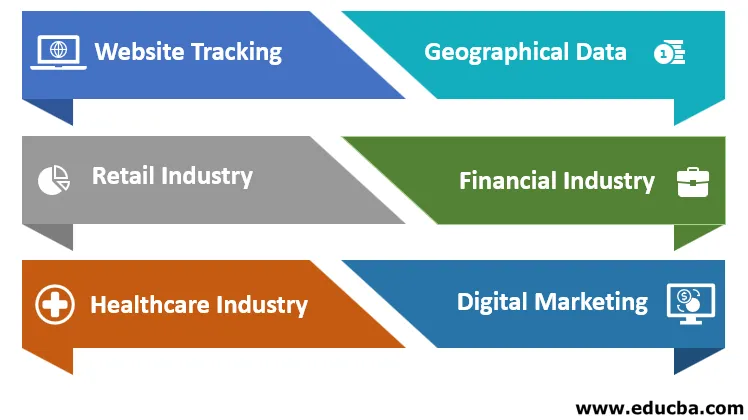

Applications de Hadoop

Les applications de Hadoop sont expliquées ci-dessous:

une. Suivi de site Web

Supposons que vous ayez créé un site Web et que vous souhaitiez connaître les détails des visiteurs. Hadoop va capturer une énorme quantité de données à ce sujet. Il fournira des informations sur l'emplacement du visiteur, la page visitée en premier et le plus, combien de temps passé sur le site Web et sur quelle page, combien de fois un visiteur a visité la page, quel visiteur aime le plus. Cela fournira une analyse prédictive de l'intérêt des visiteurs, les performances du site Web prédiront ce qui serait l'intérêt des utilisateurs. Hadoop accepte les données dans plusieurs formats provenant de plusieurs sources. Apache HIVE sera utilisé pour traiter des millions de données.

b. Données géographiques

Lorsque nous achetons des produits sur un site Web de commerce électronique. Le site Web suivra l'emplacement de l'utilisateur, prédira les achats des clients à l'aide de smartphones, de tablettes. Le cluster Hadoop aidera à comprendre les activités de géolocalisation. Cela aidera les industries à afficher le graphique des entreprises dans chaque domaine (positif ou négatif).

c. Commerce de détail

Les détaillants utiliseront les données des clients qui sont présentes dans le format structuré et non structuré, pour comprendre, analyser les données. Cela aidera un utilisateur à comprendre les besoins des clients et à leur offrir de meilleurs avantages et des services améliorés.

ré. Secteur financier

L'industrie financière et les sociétés financières évalueront le risque financier, la valeur marchande et construiront le modèle qui donnera aux clients et à l'industrie de meilleurs résultats en termes d'investissement comme le marché boursier, FD, etc. Comprenez l'algorithme de négociation. Hadoop exécutera le modèle de build.

e. L'industrie de la santé

Hadoop peut stocker de grandes quantités de données. Les données médicales sont présentes dans un format non structuré. Cela aidera le médecin pour un meilleur diagnostic. Hadoop conservera des antécédents médicaux du patient de plus d'un an, analysera les symptômes de la maladie.

F. Le marketing numérique

Nous sommes à l'ère des années 20, chaque personne est connectée numériquement. Les informations sont communiquées à l'utilisateur par le biais de téléphones portables ou d'ordinateurs portables et les gens sont informés de chaque détail concernant les actualités, les produits, etc. Hadoop stockera massivement les données générées en ligne, stockera, analysera et fournira le résultat aux sociétés de marketing numérique.

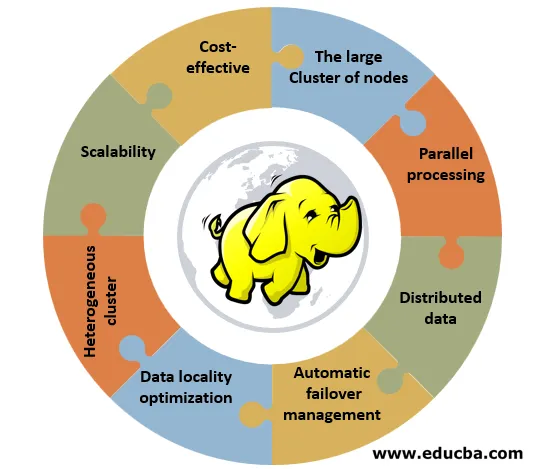

Caractéristiques de Hadoop

Ci-dessous sont les caractéristiques de Hadoop:

1. Rentable: Hadoop ne nécessite aucun matériel spécialisé ou efficace pour le mettre en œuvre. Il peut être implémenté sur du matériel simple appelé matériel communautaire.

2. Le grand cluster de nœuds: Un cluster peut être composé de 100 ou 1000 de nœuds. L'avantage d'avoir un grand cluster est qu'il offre plus de puissance de calcul et un énorme système de stockage aux clients.

3. Traitement parallèle: les données peuvent être traitées simultanément sur tous les clusters et ce processus vous fera gagner beaucoup de temps. Le système traditionnel n'était pas en mesure d'accomplir cette tâche.

4. Données distribuées: le framework Hadoop s'occupe de diviser et de distribuer les données sur tous les nœuds d'un cluster. Il réplique les données sur tous les clusters. Le facteur de réplication est 3.

5. Gestion automatique du basculement: supposons qu'en cas de défaillance de l'un des nœuds d'un cluster, la structure Hadoop remplace la machine défaillante par une nouvelle machine. Les paramètres de réplication de l'ancienne machine sont automatiquement transférés vers la nouvelle machine. L'administrateur n'a pas à s'en soucier.

6. Optimisation de la localisation des données: supposons que le programmeur ait besoin des données du nœud d'une base de données située à un emplacement différent, le programmeur enverra un octet de code à la base de données. Cela économisera de la bande passante et du temps.

7. Cluster hétérogène: il a un nœud différent prenant en charge différentes machines avec différentes versions. La machine IBM prend en charge Red Hat Linux.

8. Évolutivité: ajout ou suppression de nœuds et ajout ou suppression de composants matériels vers ou depuis le cluster. Nous pouvons effectuer cette tâche sans perturber le fonctionnement du cluster. La RAM ou le disque dur peut être ajouté ou supprimé du cluster.

Avantages de Hadoop

Les avantages de Hadoop sont expliqués ci-dessous:

- Hadoop peut gérer un grand volume de données et peut mettre à l'échelle les données en fonction de leurs besoins. Maintenant, les données d'un jour sont présentes dans 1 à 100 téra-octets.

- Il fera évoluer un énorme volume de données sans avoir de nombreux défis Prenons un exemple de Facebook - des millions de personnes se connectent, partagent des idées, des commentaires, etc. Il peut gérer sans problème les pannes logicielles et matérielles.

- Si un système tombe en panne, les données ne seront pas perdues ou aucune perte d'informations car le facteur de réplication est 3, les données sont copiées 3 fois et Hadoop déplacera les données d'un système à un autre. Il peut gérer différents types de données comme structurées, non structurées ou semi-structurées.

- Structurez des données comme une table (nous pouvons facilement récupérer la valeur des lignes ou des colonnes), des données non structurées comme des vidéos et des photos et des données semi-structurées comme une combinaison de structures et semi-structures.

- Le coût de mise en œuvre de Hadoop avec le projet bigdata est faible car les entreprises achètent des services de stockage et de traitement auprès de fournisseurs de services cloud car le coût du stockage par octet est faible.

- Il offre une flexibilité tout en générant de la valeur à partir des données comme structurées et non structurées. Nous pouvons obtenir des données précieuses à partir de sources de données comme les médias sociaux, les canaux de divertissement, les sites Web commerciaux.

- Hadoop peut traiter des données avec des fichiers CSV, XML, etc. Les données sont traitées en parallèle dans l'environnement de distribution, nous pouvons mapper les données lorsqu'elles se trouvent sur le cluster. Le serveur et les données sont situés au même emplacement, ce qui accélère le traitement des données.

- Si nous avons un énorme ensemble de données non structurées, nous pouvons traiter des téraoctets de données en une minute. Les développeurs peuvent coder pour Hadoop en utilisant différents langages de programmation comme python, C, C ++. Il s'agit d'une technologie open source. Le code source est facilement accessible en ligne. Si les données augmentent de jour en jour, nous pouvons ajouter des nœuds au cluster. Nous n'avons pas besoin d'ajouter plus de clusters. Chaque nœud exécute son travail en utilisant ses propres ressources.

Conclusion

Hadoop peut effectuer des calculs de données volumineux. Pour traiter cela, Google a développé un algorithme Map-Reduce, Hadoop exécutera l'algorithme. Cela jouera un rôle majeur dans l'analyse statistique, l'intelligence d'affaires et le traitement ETL. Facile à utiliser et moins coûteux disponible. Il peut gérer des téraoctets de données, les analyser et fournir de la valeur à partir de données sans aucune difficulté, sans perte d'informations.

Articles recommandés

Ceci est un guide sur Qu'est-ce que Hadoop?. Nous discutons ici de l'application de Hadoop et des fonctionnalités ainsi que des avantages. Vous pouvez également consulter nos autres articles suggérés pour en savoir plus–

- Méthodes de regroupement

- Logiciel IoT

- Liste de commandes Hadoop FS

- Avantages de Hadoop

- Comment les commentaires fonctionnent-ils en PHP?