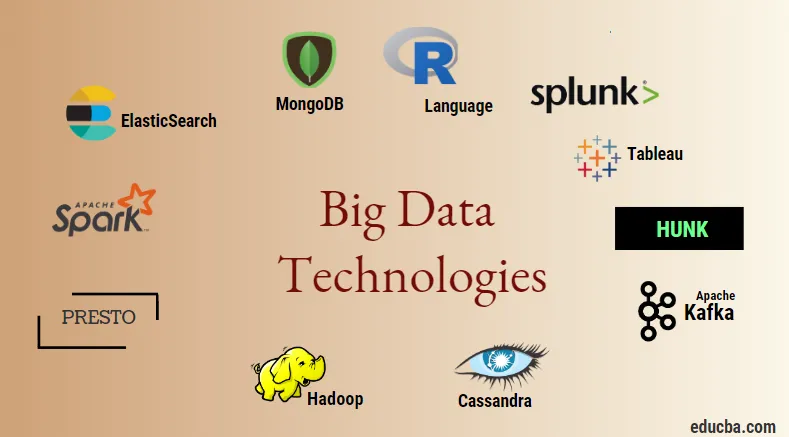

Introduction aux technologies Big Data

La technologie des mégadonnées et Hadoop est un gros mot à la mode, comme cela peut paraître. Comme il y a eu une énorme augmentation du domaine des données et de l'information de chaque industrie et domaine, il devient très important d'établir et d'introduire une technique efficace qui prend en charge tous les besoins et exigences des clients et des grandes industries qui sont responsables de la génération de données. . Auparavant, les données étaient gérées par des langages de programmation normaux et un langage de requête structuré simple, mais maintenant ces systèmes et outils ne semblent pas faire grand-chose en cas de big data. La technologie des mégadonnées est définie comme la technologie et un utilitaire logiciel conçus pour l'analyse, le traitement et l'extraction des informations d'un grand ensemble de structures extrêmement complexes et de grands ensembles de données, ce qui est très difficile à gérer pour les systèmes traditionnels. La technologie Big Data est utilisée pour gérer à la fois les données en temps réel et celles liées aux lots. L'apprentissage automatique est devenu une composante très critique de la vie quotidienne et de chaque industrie et, par conséquent, la gestion des données via les mégadonnées devient très importante.

Types de technologies Big Data

Avant de commencer par la liste des technologies, voyons d'abord le classement général de toutes ces technologies. Ils peuvent principalement être classés en 4 domaines.

- Stockage de données

- Analytique

- Exploration de données

- Visualisation

Couvrons d'abord toutes les technologies qui entrent dans le cadre du stockage.

1. Hadoop : en ce qui concerne les mégadonnées, Hadoop est la première technologie qui entre en jeu. Il est basé sur une architecture de réduction de carte et aide au traitement des travaux liés aux lots et au traitement des informations sur les lots. Il a été conçu pour stocker et traiter les données dans un environnement de traitement de données distribué avec du matériel de base et un modèle d'exécution de programmation simple. Il peut être utilisé pour stocker et analyser les données présentes dans différentes machines avec un stockage, une vitesse et des coûts élevés. Cela constitue l'un des principaux composants de base de la technologie des mégadonnées développée par la fondation du logiciel Apache en 2011 et écrite en Java.

1. Hadoop : en ce qui concerne les mégadonnées, Hadoop est la première technologie qui entre en jeu. Il est basé sur une architecture de réduction de carte et aide au traitement des travaux liés aux lots et au traitement des informations sur les lots. Il a été conçu pour stocker et traiter les données dans un environnement de traitement de données distribué avec du matériel de base et un modèle d'exécution de programmation simple. Il peut être utilisé pour stocker et analyser les données présentes dans différentes machines avec un stockage, une vitesse et des coûts élevés. Cela constitue l'un des principaux composants de base de la technologie des mégadonnées développée par la fondation du logiciel Apache en 2011 et écrite en Java.

2. MongoDB : Un autre composant très essentiel et central de la technologie des mégadonnées en termes de stockage est la base de données MongoDB NoSQL. Il s'agit d'une base de données NoSQL, ce qui signifie que les propriétés relationnelles et autres propriétés liées au SGBDR ne s'appliquent pas à elle. Il est différent des bases de données SGBDR traditionnelles qui utilisent un langage de requête structuré. Il utilise des documents de schéma et la structure du stockage de données est également différente et, par conséquent, ils sont utiles pour contenir une grande quantité de données. Il s'agit d'un programme de conception et de base de données orienté document multiplateforme qui utilise des documents de type JSON avec un schéma. Cela devient un cas d'utilisation très utile des magasins de données opérationnelles dans la majorité des institutions financières et travaille ainsi à remplacer les mainframes traditionnels. MongoDB gère la flexibilité et également une grande variété de types de données à des volumes élevés et parmi les architectures distribuées.

2. MongoDB : Un autre composant très essentiel et central de la technologie des mégadonnées en termes de stockage est la base de données MongoDB NoSQL. Il s'agit d'une base de données NoSQL, ce qui signifie que les propriétés relationnelles et autres propriétés liées au SGBDR ne s'appliquent pas à elle. Il est différent des bases de données SGBDR traditionnelles qui utilisent un langage de requête structuré. Il utilise des documents de schéma et la structure du stockage de données est également différente et, par conséquent, ils sont utiles pour contenir une grande quantité de données. Il s'agit d'un programme de conception et de base de données orienté document multiplateforme qui utilise des documents de type JSON avec un schéma. Cela devient un cas d'utilisation très utile des magasins de données opérationnelles dans la majorité des institutions financières et travaille ainsi à remplacer les mainframes traditionnels. MongoDB gère la flexibilité et également une grande variété de types de données à des volumes élevés et parmi les architectures distribuées.

3. Hunk : il est utile pour accéder aux données via des clusters Hadoop distants en utilisant des index virtuels et utilise également le langage de traitement de recherche Splunk qui peut être utilisé pour l'analyse des données. Le morceau peut être utilisé pour signaler et visualiser d'énormes quantités de données provenant des bases de données et des sources Hadoop et NoSQL. Il a été développé par l'équipe Splunk en 2013 qui a été écrit en Java.

3. Hunk : il est utile pour accéder aux données via des clusters Hadoop distants en utilisant des index virtuels et utilise également le langage de traitement de recherche Splunk qui peut être utilisé pour l'analyse des données. Le morceau peut être utilisé pour signaler et visualiser d'énormes quantités de données provenant des bases de données et des sources Hadoop et NoSQL. Il a été développé par l'équipe Splunk en 2013 qui a été écrit en Java.

4. Cassandra : Cassandra constitue un premier choix parmi la liste des bases de données NoSQL populaires qui est une base de données gratuite et open-source, qui est distribuée et possède un large stockage en colonnes et peut gérer efficacement les données sur les grands clusters de produits, c'est-à-dire qu'elle est utilisée pour fournir une haute disponibilité sans point de défaillance unique. Parmi la liste des principales fonctionnalités, citons celles telles que la nature distribuée, l'évolutivité, le mécanisme de tolérance aux pannes, la prise en charge de MapReduce, la cohérence ajustable, la propriété du langage de requête, la réplication multi-centre de données et la cohérence éventuelle.

4. Cassandra : Cassandra constitue un premier choix parmi la liste des bases de données NoSQL populaires qui est une base de données gratuite et open-source, qui est distribuée et possède un large stockage en colonnes et peut gérer efficacement les données sur les grands clusters de produits, c'est-à-dire qu'elle est utilisée pour fournir une haute disponibilité sans point de défaillance unique. Parmi la liste des principales fonctionnalités, citons celles telles que la nature distribuée, l'évolutivité, le mécanisme de tolérance aux pannes, la prise en charge de MapReduce, la cohérence ajustable, la propriété du langage de requête, la réplication multi-centre de données et la cohérence éventuelle.

Ensuite, nous allons parler des différents domaines de la technologie des mégadonnées, c'est-à-dire l'exploration de données.

5. Presto : c'est un moteur de requête distribué open source et basé sur SQL qui est utilisé pour exécuter des requêtes interactives sur les sources de données de toutes les échelles et les plages de tailles allant de Gigabytes à Petabytes. Avec son aide, nous pouvons interroger des données dans Cassandra, Hive, des magasins de données propriétaires et des systèmes de stockage de bases de données relationnelles. Il s'agit d'un moteur de requête basé sur java qui a été développé par la fondation Apache en 2013. Quelques groupes d'entreprises qui font bon usage de l'outil Presto sont Netflix, Airbnb, Checkr, Repro et facebook.

5. Presto : c'est un moteur de requête distribué open source et basé sur SQL qui est utilisé pour exécuter des requêtes interactives sur les sources de données de toutes les échelles et les plages de tailles allant de Gigabytes à Petabytes. Avec son aide, nous pouvons interroger des données dans Cassandra, Hive, des magasins de données propriétaires et des systèmes de stockage de bases de données relationnelles. Il s'agit d'un moteur de requête basé sur java qui a été développé par la fondation Apache en 2013. Quelques groupes d'entreprises qui font bon usage de l'outil Presto sont Netflix, Airbnb, Checkr, Repro et facebook.

6. ElasticSearch : C'est un outil très important aujourd'hui en matière de recherche. Cela constitue un composant essentiel de la pile ELK, à savoir la recherche élastique, Logstash et Kibana. ElasticSearch est un moteur de recherche basé sur la bibliothèque Lucene qui est similaire à Solr et est utilisé pour fournir un moteur de recherche en texte intégral purement distribué qui est multi-tenant capable. Il contient une liste de documents JSON sans schéma et une interface Web HTTP. Il est écrit dans la langue JAVA et est développé par Elastic Company dans la société 2012. Les noms de quelques sociétés qui utilisent elasticsearch sont: LinkedIn, StackOverflow, Netflix, Facebook, Google, Accenture, etc.

6. ElasticSearch : C'est un outil très important aujourd'hui en matière de recherche. Cela constitue un composant essentiel de la pile ELK, à savoir la recherche élastique, Logstash et Kibana. ElasticSearch est un moteur de recherche basé sur la bibliothèque Lucene qui est similaire à Solr et est utilisé pour fournir un moteur de recherche en texte intégral purement distribué qui est multi-tenant capable. Il contient une liste de documents JSON sans schéma et une interface Web HTTP. Il est écrit dans la langue JAVA et est développé par Elastic Company dans la société 2012. Les noms de quelques sociétés qui utilisent elasticsearch sont: LinkedIn, StackOverflow, Netflix, Facebook, Google, Accenture, etc.

Lisons maintenant toutes ces technologies de Big Data qui font partie de l'analyse de données:

7. Apache Kafka : Connu pour sa publication-abonnement ou pub-sub comme il est communément appelé, est un système de courtage de messagerie asynchrone à messagerie directe qui est utilisé pour ingérer et effectuer un traitement de données sur des données de streaming en temps réel. Il prévoit également une période de conservation et les données peuvent être canalisées au moyen d'un mécanisme producteur-consommateur. C'est l'une des plates-formes de streaming les plus populaires, très similaire au système de messagerie d'entreprise ou à une file d'attente de messagerie. Kafka a lancé de nombreuses améliorations à ce jour et un type majeur est celui de Kafka confluent qui fournit un niveau supplémentaire de propriétés à Kafka telles que le registre de schéma, Ktables, KSql, etc. Il a été développé par la communauté Apache Software en 2011 et est écrit en Java. Les entreprises qui utilisent cette technologie sont Twitter, Spotify, Netflix, Linkedin, Yahoo, etc.

7. Apache Kafka : Connu pour sa publication-abonnement ou pub-sub comme il est communément appelé, est un système de courtage de messagerie asynchrone à messagerie directe qui est utilisé pour ingérer et effectuer un traitement de données sur des données de streaming en temps réel. Il prévoit également une période de conservation et les données peuvent être canalisées au moyen d'un mécanisme producteur-consommateur. C'est l'une des plates-formes de streaming les plus populaires, très similaire au système de messagerie d'entreprise ou à une file d'attente de messagerie. Kafka a lancé de nombreuses améliorations à ce jour et un type majeur est celui de Kafka confluent qui fournit un niveau supplémentaire de propriétés à Kafka telles que le registre de schéma, Ktables, KSql, etc. Il a été développé par la communauté Apache Software en 2011 et est écrit en Java. Les entreprises qui utilisent cette technologie sont Twitter, Spotify, Netflix, Linkedin, Yahoo, etc.

8. Splunk : Splunk est utilisé pour capturer, corréler et indexer les données de streaming en temps réel à partir d'un référentiel consultable à partir duquel il peut générer des rapports, des graphiques, des tableaux de bord, des alertes et des visualisations de données. Il est également utilisé pour la sécurité, la conformité et la gestion des applications, ainsi que pour l'analyse Web, générant des informations commerciales et des analyses commerciales. Il a été développé par Splunk en Python, XML, Ajax.

8. Splunk : Splunk est utilisé pour capturer, corréler et indexer les données de streaming en temps réel à partir d'un référentiel consultable à partir duquel il peut générer des rapports, des graphiques, des tableaux de bord, des alertes et des visualisations de données. Il est également utilisé pour la sécurité, la conformité et la gestion des applications, ainsi que pour l'analyse Web, générant des informations commerciales et des analyses commerciales. Il a été développé par Splunk en Python, XML, Ajax.

9. Apache Spark : vient maintenant la technologie la plus critique et la plus attendue dans le domaine des technologies Big Data, à savoir Apache Spark. Il fait peut-être partie de ceux qui sont les plus demandés aujourd'hui et utilise Java, Scala ou Python pour son traitement. Il est utilisé pour traiter et gérer les données de streaming en temps réel en utilisant Spark Streaming qui utilise des opérations de traitement par lots et de fenêtrage pour y arriver. Spark SQL est utilisé pour créer des blocs de données, des ensembles de données au-dessus des RDD et ainsi fournir une bonne saveur des transformations et des actions qui forment un composant intégral d'Apache Spark Core. D'autres composants tels que Spark Mllib, R et graphX sont également utiles dans le cas de l'analyse et de l'apprentissage automatique et de la science des données. La technique informatique en mémoire la différencie des autres outils et composants et prend en charge une grande variété d'applications. Il a été développé par la fondation Apache Software en langage Java principalement.

9. Apache Spark : vient maintenant la technologie la plus critique et la plus attendue dans le domaine des technologies Big Data, à savoir Apache Spark. Il fait peut-être partie de ceux qui sont les plus demandés aujourd'hui et utilise Java, Scala ou Python pour son traitement. Il est utilisé pour traiter et gérer les données de streaming en temps réel en utilisant Spark Streaming qui utilise des opérations de traitement par lots et de fenêtrage pour y arriver. Spark SQL est utilisé pour créer des blocs de données, des ensembles de données au-dessus des RDD et ainsi fournir une bonne saveur des transformations et des actions qui forment un composant intégral d'Apache Spark Core. D'autres composants tels que Spark Mllib, R et graphX sont également utiles dans le cas de l'analyse et de l'apprentissage automatique et de la science des données. La technique informatique en mémoire la différencie des autres outils et composants et prend en charge une grande variété d'applications. Il a été développé par la fondation Apache Software en langage Java principalement.

10. Langage R : R est un langage de programmation et un environnement logiciel libre qui est utilisé pour le calcul statistique et également pour les graphiques dans l'un des langages les plus importants de R. C'est l'un des langages les plus populaires parmi les scientifiques des données, les mineurs de données et praticiens des données pour le développement de logiciels statistiques et principalement en analyse de données.

10. Langage R : R est un langage de programmation et un environnement logiciel libre qui est utilisé pour le calcul statistique et également pour les graphiques dans l'un des langages les plus importants de R. C'est l'un des langages les plus populaires parmi les scientifiques des données, les mineurs de données et praticiens des données pour le développement de logiciels statistiques et principalement en analyse de données.

Voyons maintenant les technologies liées à la visualisation des données.

11. Tableau: Il s'agit de l'outil de visualisation de données à la croissance la plus rapide et la plus puissante utilisé dans le domaine de l'intelligence d'affaires. L'analyse des données est une machine très rapide qui est possible à l'aide de Tableau et les visualisations sont créées sous forme de feuilles de travail et de tableaux de bord. Il est développé par la société tableau en 2013 et est écrit en Python, C ++, Java et C.Les entreprises qui utilisent Tableau sont: QlikQ, Oracle Hyperion, Cognos, etc.

11. Tableau: Il s'agit de l'outil de visualisation de données à la croissance la plus rapide et la plus puissante utilisé dans le domaine de l'intelligence d'affaires. L'analyse des données est une machine très rapide qui est possible à l'aide de Tableau et les visualisations sont créées sous forme de feuilles de travail et de tableaux de bord. Il est développé par la société tableau en 2013 et est écrit en Python, C ++, Java et C.Les entreprises qui utilisent Tableau sont: QlikQ, Oracle Hyperion, Cognos, etc.

12. Plotly : Plotly est principalement utilisé pour rendre les graphiques et les composants associés plus rapides et plus efficaces. Il dispose d'un ensemble plus riche de bibliothèques et d'API telles que MATLAB, Python, R, Arduino, Julia, etc. Cela peut être utilisé de manière interactive dans le bloc-notes Jupyter et Pycharm et peut être utilisé pour styliser des graphiques interactifs. Il a été développé pour la première fois en 2012 et écrit en javascript. Les quelques entreprises qui utilisent Plotly sont les paladins, le bitbank, etc.

12. Plotly : Plotly est principalement utilisé pour rendre les graphiques et les composants associés plus rapides et plus efficaces. Il dispose d'un ensemble plus riche de bibliothèques et d'API telles que MATLAB, Python, R, Arduino, Julia, etc. Cela peut être utilisé de manière interactive dans le bloc-notes Jupyter et Pycharm et peut être utilisé pour styliser des graphiques interactifs. Il a été développé pour la première fois en 2012 et écrit en javascript. Les quelques entreprises qui utilisent Plotly sont les paladins, le bitbank, etc.

Conclusion

Dans cet article, nous avons étudié les meilleures technologies de Big Data qui sont largement utilisées aujourd'hui. J'espère que tu l'as aimé. Continuez à nous suivre pour plus de messages comme ceux-ci.

Articles recommandés

Ceci est un guide des technologies Big Data. Ici, nous avons discuté d'une introduction et des types de technologies Big Data. Vous pouvez également consulter nos autres articles suggérés pour en savoir plus -

- Qu'est-ce que Splunk Tool?

- R vs Python

- Qu'est-ce que Matlab?

- Qu'est-ce que MongoDB?

- Étapes à suivre dans les tests mainframe

- Types de jointures dans Spark SQL (exemples)

- Apprenez les différents types d'outils Kafka