Introduction à la régression linéaire simple

Du dictionnaire : un retour à un état ancien ou moins développé.

En statistique: mesure de la relation entre la valeur moyenne d'une variable et les valeurs correspondantes des autres variables.

La régression, dans laquelle la relation entre la variable d'entrée (variable indépendante) et la variable cible (variable dépendante) est considérée comme linéaire est appelée régression linéaire. La régression linéaire simple est un type de régression linéaire où nous n'avons qu'une seule variable indépendante pour prédire la variable dépendante. La régression linéaire simple est l'un des algorithmes d'apprentissage automatique. La régression linéaire simple appartient à la famille de l'apprentissage supervisé. La régression est utilisée pour prédire des valeurs continues.

Modèle de régression linéaire simple

Rendons les choses simples. Comment tout a commencé?

Tout a commencé en 1800 avec Francis Galton. Il a étudié la relation en hauteur entre les pères et leurs fils. Il a observé un schéma: la taille de son fils serait aussi grande que la taille de son père ou la taille de son fils aura tendance à être plus proche de la taille moyenne globale de toutes les personnes. Ce phénomène n'est qu'une régression.

Par exemple, Shaq O'Neal est un joueur NBA très célèbre et mesure 2, 16 mètres. Ses fils Shaqir et Shareef O'neal mesurent respectivement 1, 96 mètre et 2, 06 mètres. La taille moyenne de la population est de 1, 76 mètre. La taille du fils régresse (dérive vers) la hauteur moyenne.

Comment faisons-nous la régression?

Calcul d'une régression avec seulement deux points de données:

Tout ce que nous voulons faire pour trouver la meilleure régression est de tracer une ligne aussi proche que possible de chaque point. Dans le cas de deux points de données, il est facile de tracer une ligne, il suffit de les joindre.

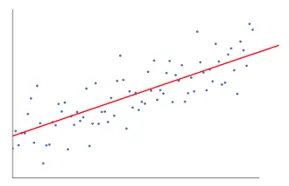

Maintenant, si nous avons un certain nombre de points de données, comment dessiner la ligne qui est aussi proche que possible de chaque point de données.

Dans ce cas, notre objectif est de minimiser la distance verticale entre la ligne et tous les points de données. De cette façon, nous prédisons la meilleure ligne pour notre modèle de régression linéaire.

Qu'est-ce que la régression linéaire simple?

Voici l'explication détaillée de la régression linéaire simple:

- Il dessine beaucoup, beaucoup de lignes de lignes possibles, puis effectue l'une de ces analyses.

- Somme des erreurs au carré.

- Somme des erreurs absolues.

- méthode des moindres carrés… etc

- Pour notre analyse, nous utiliserons la méthode des moindres carrés.

- Nous ferons une différence de tous les points et calculerons le carré de la somme de tous les points. Quelle que soit la ligne qui donne le montant minimum sera notre meilleure ligne.

Par exemple: En faisant cela, nous pourrions prendre plusieurs hommes et la taille de leur fils et faire des choses comme dire à un homme la taille de son fils. avant même sa naissance.

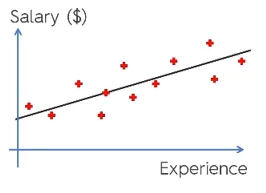

Google Image

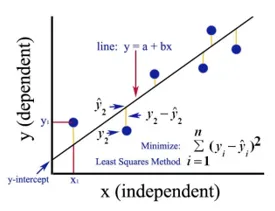

La figure ci-dessus montre une régression linéaire simple. La ligne représente la ligne de régression. Donné par: y = a + b * x

Où y est la variable dépendante (DV): par exemple, comment le salaire d'une personne change en fonction du nombre d'années d'expérience de l'employé. Donc, ici, le salaire d'un employé ou d'une personne sera votre variable dépendante.

La variable dépendante est notre variable cible, celle que nous voulons prédire par régression linéaire.

x est notre variable indépendante (IV): la variable dépendante est la cause de la variable indépendante du changement. Dans l'exemple ci-dessus, le nombre d'années d'expérience est notre variable dépendante, car le nombre d'années d'expérience est à l'origine du changement de salaire de l'employé.

- b est la variable de coefficient pour notre variable indépendante x. Ce coefficient joue un rôle crucial. Il indique comment un changement d'unité de x (IV) va affecter y (DV). Il est également appelé coefficient de proportionnel. En termes de mathématiques, c'est à vous de déterminer la pente de la ligne ou vous pouvez dire raide de la ligne.

- Dans notre exemple, si la pente (b) est inférieure, ce qui signifie que le nombre d'années produira moins d'augmentation de salaire par contre si la pente (b) est plus, cela entraînera une augmentation élevée du salaire avec une augmentation du nombre de des années d'expérience.

- a est une valeur constante. Il est également appelé interception, c'est-à-dire là où la ligne coupe l'axe Y ou DV. D'une autre manière, nous pouvons dire que lorsqu'un employé n'a aucune année d'expérience (x), le salaire (y) de cet employé sera constant (a).

Comment fonctionne Least Square?

Voici les points pour le travail le moins carré:

- Il trace une ligne arbitraire en fonction des tendances des données.

- Il prend des points de données et trace des lignes verticales. Il considère la distance verticale comme un paramètre.

- Ces lignes verticales coupent la ligne de régression et donnent le point correspondant pour les points de données.

- Il trouvera alors la différence verticale entre chaque point de données et son point de données correspondant sur la ligne de régression.

- Il calculera l'erreur au carré de la différence.

- Il calcule ensuite la somme des erreurs.

- Ensuite, il tracera une ligne et répétera la procédure ci-dessus une fois de plus.

- Il trace un certain nombre de lignes de cette manière et la ligne qui donne le moins de somme d'erreur est choisie comme la meilleure ligne.

- Cette meilleure ligne est notre simple ligne de régression linéaire.

Application de la régression linéaire simple

Une analyse de régression est effectuée pour prédire la variable continue. L'analyse de régression a une grande variété d'applications. Voici quelques exemples:

- Analyses prédictives

- Efficacité du marketing,

- prix de toute annonce

- prédiction de promotion d'un produit.

Ici, nous allons discuter d'une application de la régression linéaire pour l'analyse prédictive. Nous allons faire de la modélisation en python.

Les étapes que nous allons suivre pour construire notre modèle sont les suivantes:

- Nous importerons les bibliothèques et les jeux de données.

- Nous pré-traiterons les données.

- Nous diviserons les données entre l'ensemble de test et l'ensemble de formation.

- Nous allons créer un modèle qui tentera de prédire la variable cible en fonction de notre ensemble d'entraînement

- Nous prédirons la variable cible pour l'ensemble de test.

- Nous analyserons les résultats prédits par le modèle

Pour notre analyse, nous allons utiliser un ensemble de données sur les salaires avec les données de 30 employés.

# Importer les bibliothèques

import numpy as np

import matplotlib.pyplot as plt

import pandas as pd

# Importation de l'ensemble de données (un échantillon de données est présenté dans le tableau)

dataset = pd.read_csv('Salary_Data.csv')

| des années d'expérience | Un salaire |

| 1, 5 | 37731 |

| 1.1 | 39343 |

| 2.2 | 39891 |

| 2 | 43525 |

| 1, 3 | 46205 |

| 3.2 | 54445 |

| 4 | 55749 |

# Prétraitement de l'ensemble de données, nous allons ici diviser l'ensemble de données en variable dépendante et variable indépendante. x comme indépendant et y comme variable dépendante ou cible

X = dataset.iloc(:, :-1).values

y = dataset.iloc(:, 1).values

# Fractionnement de l'ensemble de données en ensemble de formation et ensemble de test:

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size = 1/3, random_state = 0)

Ici, la taille du test 1/3 montre qu'à partir des données totales, 2/3 partie est destinée à l'apprentissage du modèle et le reste 1/3 est utilisé pour tester le modèle.

# Adaptons notre modèle de régression linéaire simple à l'ensemble d'entraînement

from sklearn.linear_model import LinearRegression

regressor = LinearRegression()

regressor.fit(X_train, y_train)

Le modèle de régression linéaire est maintenant formé. Ce modèle sera utilisé pour prédire la variable dépendante.

# Prédiction des résultats de l'ensemble de test

y_pred = regressor.predict(X_test)

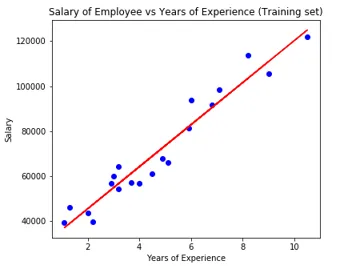

# Visualisation des résultats de l'ensemble de test

plt.scatter(X_test, y_test, color = 'blue')

plt.plot(X_train, regressor.predict(X_train), color = 'red')

plt.title('Salary of Employee vs Experience (Test set)')

plt.xlabel('Years of Experience')

plt.ylabel('Salary')

plt.show()

# Paramètre du modèle

print(regressor.intercept_)

print(regressor.coef_)

26816.19224403119

(9345.94244312)

Ainsi, la valeur de l'intercepteur (a) est 26816. Ce qui suggère que toute nouvelle expérience (zéro) représenterait environ 26816 de salaire.

Le coefficient de notre modèle est ressorti à 9345, 94. Il suggère qu'en gardant tous les autres paramètres constants, le changement d'une unité de la variable indépendante (années d'exp.) Entraînera un changement de 9345 unités de salaire.

Mesures d'évaluation de régression

Il existe essentiellement trois méthodes de mesure d'évaluation importantes disponibles pour l'analyse de régression:

- Erreur absolue moyenne (MAE): elle montre la moyenne des erreurs absolues, qui est la différence entre prédite et réelle.

- Erreur quadratique moyenne (MSE): affiche la valeur moyenne des erreurs quadratiques.

- Erreur quadratique moyenne (RMSE): elle montre la racine carrée de la moyenne des erreurs quadratiques.

Nous pouvons comparer les méthodes ci-dessus:

- MAE: Il montre l'erreur moyenne et la plus simple des trois méthodes.

- MSE: Celui-ci est plus populaire que MAE car il améliore les erreurs les plus importantes, ce qui montre plus de perspicacités.

- RMSE: Celui-ci est meilleur que MSE car nous pouvons interpréter l'erreur en termes de y.

Ces 3 ne sont que les fonctions de perte.

# Évaluation du modèle

from sklearn import metrics

print('MAE:', metrics.mean_absolute_error(y_test, y_pred))

print('MSE:', metrics.mean_squared_error(y_test, y_pred))

print('RMSE:', np.sqrt(metrics.mean_squared_error(y_test, y_pred)))

MAE: 3426.4269374307123

MSE: 21026037.329511296

RMSE: 4585.4157204675885

Conclusion

L'analyse de régression linéaire est un outil puissant pour les algorithmes d'apprentissage automatique, qui est utilisé pour prédire des variables continues comme le salaire, les ventes, les performances, etc. La régression linéaire considère la relation linéaire entre les variables indépendantes et dépendantes. La régression linéaire simple n'a qu'une seule variable indépendante sur la base de laquelle le modèle prédit la variable cible. Nous avons discuté du modèle et de l'application de la régression linéaire avec un exemple d'analyse prédictive pour prédire le salaire des employés.

Articles recommandés

Ceci est un guide de régression linéaire simple. Ici, nous discutons du modèle et de l'application de la régression linéaire, en utilisant un exemple d'analyse prédictive pour prédire les salaires des employés. Vous pouvez également consulter nos autres articles connexes pour en savoir plus-

- Analyse de régression linéaire

- Régression linéaire en R

- Modélisation de régression linéaire

- Outils de test de régression

- Matplotlib en Python | Top 14 des terrains à Matplotlib

- Dictionnaire en Python | Méthodes et exemples

- Exemples de racine carrée en PHP

- Régression linéaire vs régression logistique | Principales différences