Différence entre Hadoop et SQL

Les énormes données générées chaque seconde via les médias sociaux comme Facebook, Twitter, Instagram ont ouvert la voie au développement de l'écosystème Hadoop / Big Data. Le terme «3V» faisant référence au volume, à la vitesse et à la véracité définit l'importance de Hadoop pour gérer les données en streaming. Aujourd'hui, les données sont générées à partir de plusieurs sources qui doivent être intégrées à diverses fins telles que le reporting, l'analyse des données et la recherche et pour le stockage centralisé des données. Lorsque nous le faisons, de nombreuses questions se posent avec les approches traditionnelles comme l'espace, l'accès, l'intégrité, la structure et la bande passante. Pour gérer tous ces problèmes, Hadoop fournit un cadre qui permet de traiter les données de grande taille, de fournir un accès facile, une haute disponibilité et de charger les données de manière dynamique. Il dispose d'un cadre de système de fichiers distribués (HDFS) pour le stockage des données et d'un processeur de requêtes intégré appelé «Map Reduce» pour l'analyse et le traitement des données stockées dans HDFS.

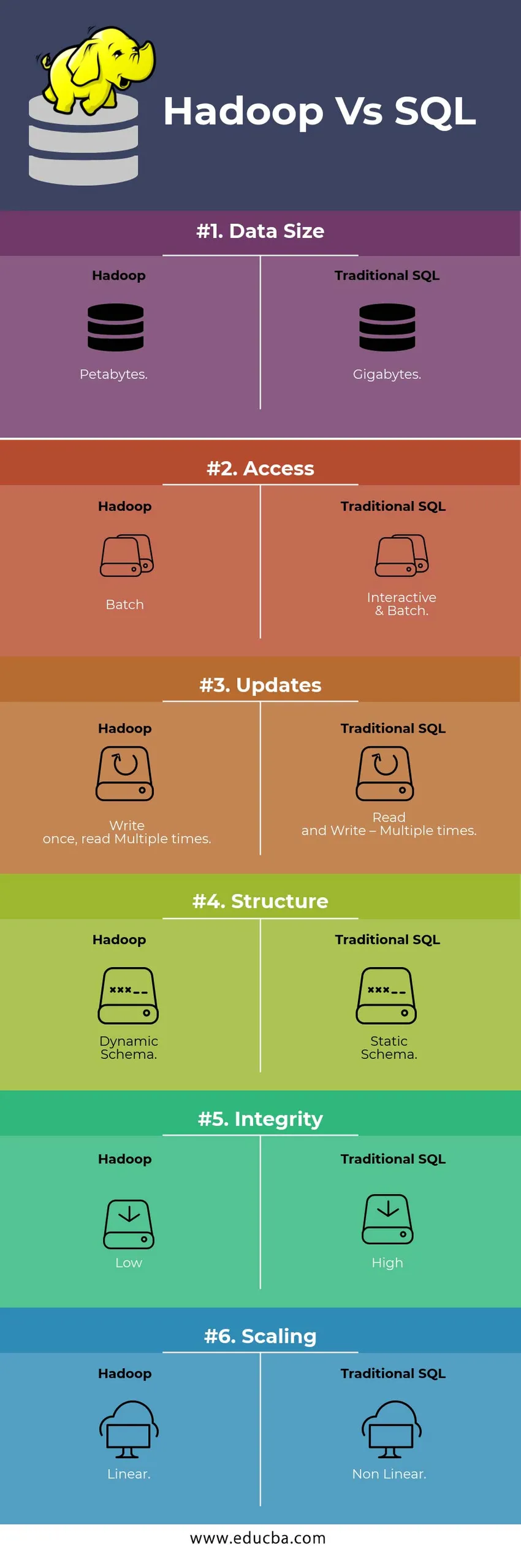

Comparaison HEAD TO HEAD entre Hadoop et SQL

Ci-dessous se trouve la principale différence entre Hadoop et SQL

Différences clés entre Hadoop et SQL

Voici la différence entre Hadoop et SQL:

- Schéma sur WRITE Vs READ

Généralement dans une base de données traditionnelle, lors du chargement / migration des données d'une base vers une autre, il suit le schéma sur l'approche Write. Cela rend le processus de chargement des données excité / abandonné et entraîne le rejet des enregistrements en raison d'une différence dans la structure des tables source et cible, alors que dans le système Hadoop - toutes les données sont stockées dans HDFS et les données sont centralisées.

Le framework Hadoop est principalement utilisé pour le processus Data Analytics. Ainsi, il prend en charge les trois catégories de données, c'est-à-dire les données structurées, semi-structurées et non structurées, et il permet l'approche du schéma sur la lecture.

- Les données structurées ont un format défini. g .: fichier XML.

- Les données des semi-structures sont plus lâches; Il peut ou non avoir un schéma. g .: Feuille de calcul

- Les données non structurées n'ont pas de structure ou de schéma spécifique. Par exemple: texte brut ou image.

Hadoop fonctionne efficacement avec les données non structurées car il a la capacité d'interpréter les données pendant le temps de traitement.

| Approche | Avantage | Désavantage |

| Schéma en écriture | · Structures prédéfinies

· Lecture plus rapide. Par exemple: SGBDR traditionnel. | Chargement lent des données

Latence élevée |

| Schéma en lecture | · Structure dynamique

· Écriture et lecture rapides. Par exemple: Hadoop | Chargement rapide des données

Faible latence |

Tableau : Schéma sur WRITE VS Schema sur READ.

- ÉVOLUTIVITÉ ET COÛT

Hadoop Framework est conçu pour traiter un grand volume de données. Chaque fois que la taille des données augmente, un certain nombre de ressources supplémentaires comme le nœud de données peuvent être ajoutées au cluster très facilement par rapport à l'approche traditionnelle de l'allocation de mémoire statique. Le temps et le budget sont relativement très moindres pour les implémenter et Hadoop fournit également une localité de données où les données sont rendues disponibles dans le nœud qui a exécuté le travail.

- TOLÉRANCE AUX DÉFAUTS

Dans le SGBDR traditionnel, lorsque des données sont perdues en raison d'une corruption ou de tout problème de réseau, il faut plus de temps, de coûts et de ressources pour récupérer les données perdues. Mais, Hadoop dispose d'un mécanisme dans lequel les données ont au moins trois niveaux de facteur de réplication pour les données stockées dans HDFS. Si l'un des nœuds de données qui contiennent des données tombe en panne, les données peuvent être facilement extraites d'autres nœuds de données avec une haute disponibilité des données. Rend donc les données facilement accessibles à l'utilisateur indépendamment de toute défaillance.

- PROGRAMMATION FONCTIONNELLE

Hadoop prend en charge l'écriture de la programmation fonctionnelle dans des langages tels que java, scala et python. Pour toute application nécessitant des fonctionnalités supplémentaires, vous pouvez l'implémenter en enregistrant UDF - Fonctions définies par l'utilisateur dans HDFS. Dans RDBMS, il n'y a aucune possibilité d'écrire UDF et cela augmente la complexité de l'écriture SQL. De plus, les données stockées dans HDFS sont accessibles à tous les écosystèmes de Hadoop comme Hive, Pig, Sqoop et HBase. Ainsi, si l'UDF est écrit, il peut être utilisé par n'importe laquelle des applications susmentionnées. Il augmente les performances et la prise en charge du système.

- OPTIMISATION

Hadoop stocke les données dans HDFS et Process via Map Reduce avec d'énormes techniques d'optimisation. Les techniques les plus utilisées pour gérer les données utilisent le partitionnement et le regroupement des données stockées. Le partitionnement est une approche pour stocker les données dans HDFS en divisant les données en fonction de la colonne mentionnée pour le partitionnement. Lorsque les données sont injectées ou chargées dans HDFS, il identifie la colonne de partition et pousse les données dans le répertoire de partition concerné. Ainsi, la requête récupère l'ensemble de résultats en récupérant directement les données du répertoire partitionné. Cela réduit l'analyse complète de la table, améliore le temps de réponse et évite la latence.

Une autre approche est appelée Bucketing des données. Cela permet à l'analyste de distribuer facilement les données entre les nœuds de données. Tous les nœuds auront un nombre égal de données distribuées. La colonne de regroupement est sélectionnée de manière à avoir le moins de cardinalité.

Ces approches ne sont pas disponibles dans la méthode traditionnelle de SQL.

- TYPE DE DONNÉES

Dans une approche traditionnelle, les types de données pris en charge sont très limités. Il prend uniquement en charge les données structurées. Ainsi, nettoyer et formater le schéma des données lui-même prendra plus de temps. Mais, Hadoop prend en charge les types de données complexes comme Array, Struct et Map. Cela encourage l'utilisation des différents types d'un ensemble de données à utiliser pour le chargement des données. Pour Ex: les données XML peuvent être chargées en définissant les données avec des éléments XML contenant un type de données complexe.

- COMPRESSION DES DONNÉES

Il existe très peu de techniques de compression intégrées disponibles pour le système de base de données traditionnel. Mais pour le framework Hadoop, il existe de nombreuses techniques de compression comme gzib, bzip2, LZO et snappy. Le mode de compression par défaut est LZ4. Même les tables peuvent être compressées en utilisant les techniques de compression comme Parquet, ORC. Les techniques de compression aident à faire en sorte que les tables occupent très moins d'espace, augmentent le débit et accélèrent l'exécution des requêtes.

Tableau de comparaison Hadoop Vs SQL

| Caractéristiques | SQL traditionnel | Hadoop |

| Taille des données | Gigaoctets | Pétaoctets |

| Accès | Interactif et batch | Lot |

| Mises à jour | Lire et écrire - plusieurs fois | Écrivez une fois, lisez plusieurs fois |

| Structure | Schéma statique | Schéma dynamique |

| Intégrité | Haute | Faible |

| Mise à l'échelle | Non linéaire | Linéaire |

Tableau : Comparaison entre Hadoop traditionnel et SQL Framework.

Conclusion - Hadoop Vs SQL

Dans l'ensemble, Hadoop devance le SQL traditionnel en termes de coût, de temps, de performances, de fiabilité, de prise en charge et de disponibilité des données pour le très grand groupe d'utilisateurs. Afin de gérer efficacement l'énorme quantité de données générées chaque jour, le framework Hadoop aide à capturer, stocker, traiter, filtrer et enfin le stocker en temps opportun dans un endroit centralisé.

Article recommandé

- Hadoop vs Hive - Découvrez les meilleures différences

- Apprenez les 10 différences utiles entre Hadoop et Redshift

- HADOOP vs RDBMS | Connaître les 12 différences utiles

- Apache Hadoop vs Apache Spark | Top 10 des comparaisons que vous devez savoir!

- Hadoop vs Spark: Caractéristiques