Introduction aux commandes Hadoop fs

Dans cet article, nous allons passer en revue les commandes de gestion de fichiers de HADOOP, qui sont utilisées pour gérer les fichiers via la console.

Vous aurez besoin d'un système Linux et de la dernière version de Hadoop. Pour imprimer la version Hadoop, pour savoir par qui la version a été construite, valeur de somme de contrôle dont nous avons juste besoin pour exécuter la commande ci-dessous après la connexion à la plate-forme Hadoop.

Commande: version Hadoop

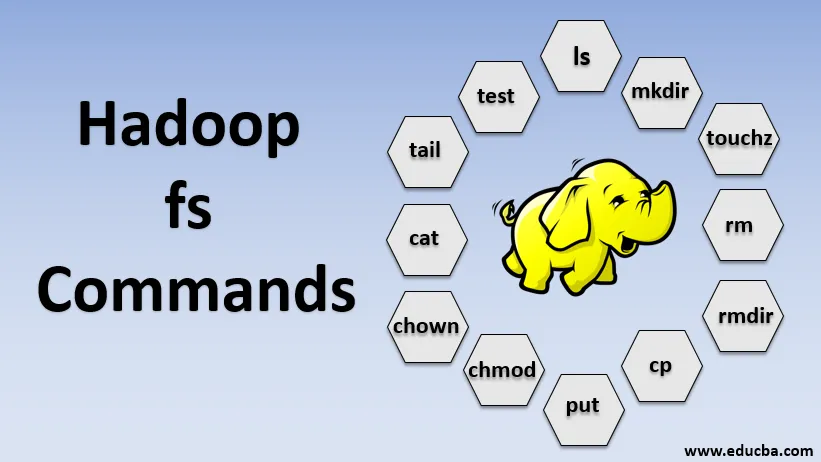

Commandes de Hadoop fs

Maintenant, apprenons à utiliser les commandes HADOOP fs.

Nous allons commencer par les bases. Tapez simplement ces commandes dans PUTTY ou dans n'importe quelle console avec laquelle vous êtes à l'aise.

1. hadoop fs -ls

Pour un répertoire, il renvoie la liste des fichiers et répertoires alors que, pour un fichier, il renvoie les statistiques sur le fichier.

hadoop fs -lsr: sert à lister récursivement les répertoires et fichiers sous des dossiers spécifiques.

- Exemple : hadoop fs -ls / ou hadoop fs -lsr

- -d: permet de répertorier les répertoires sous forme de fichiers simples.

- -h: Ceci est utilisé pour formater la taille des fichiers d'une manière lisible par l'homme que le nombre d'octets.

- -R: Ceci est utilisé pour lister récursivement le contenu des répertoires.

2. hadoop fs -mkdir

Cette commande prend le chemin en argument et crée des répertoires dans hdfs.

- Exemple : hadoop fs -mkdir / user / datahub1 / data

3. hadoop fs -touchz

Il crée un fichier vide et n'utilise aucun espace

- Exemple: hadoop fs -touchz URI

4. hadoop fs -rm

Supprimez les fichiers spécifiés comme argument. Nous devons spécifier l'option -r pour supprimer l'intégralité du répertoire. Et si l'option -skipTrash est spécifiée, elle ignorera la corbeille et le fichier sera supprimé immédiatement.

- Exemple : hadoop fs -rm -r /user/test1/abc.text

5. hadoopfs -rmdir

Il supprime les fichiers et les autorisations des répertoires et sous-répertoires. Fondamentalement, il s'agit de la version étendue de Hadoop fs -rm.

6. hadoop fs -cp

Il copie le fichier d'un emplacement à un autre

- Exemple : hadoop fs -cp /user/data/abc.csv / user / datahub

7. hadoop fs -copyFromLocal

Il copie le fichier d'edgenode vers HDFS.

8. hadoop fs -put

Il copie le fichier d'edgenode vers HDFS, il est similaire à la commande précédente mais met également les entrées de lecture à partir de l'entrée standard stdin et écrit sur HDFS

- Exemple : hadoop fs -put abc.csv / user / data

hadoop fs -put -p: Le drapeau préserve l'accès, l'heure de modification, la propriété et le mode.

hadoop fs -put -f: Cette commande écrase la destination si le fichier existe déjà avant la copie.

9. hadoop fs -moveFromLocal

Il est similaire à copier à partir du local, sauf que le fichier source est supprimé du edgenode local après avoir été copié sur HDFS

- Exemple : fs -moveFromLocal abc.text / user / data / acb.

10. hadoop fs -copyToLocal

Il copie le fichier de HDFS vers edgenode.

- Exemple : fs -copyToLocal abc.text / localpath

11. hadoop fs -chmod

Cette commande nous aide à changer l'accès à un fichier ou un répertoire

- Exemple : hadoop fs -chmod (-R) (chemin)

12. hadoop fs -chown

Cette commande nous aide à changer la propriété d'un fichier ou d'un répertoire

- Exemple : hadoop fs -chown (-R) (OWNER) (:( GROUP)) PATH

13. hadoop fs -cat

Il imprime le contenu d'un fichier HDFS sur le terminal

- Exemple : hadoop fs -cat /user/data/abc.csv

14. hadoop fs -tail

Il affiche la dernière Ko du fichier HDFS sur la sortie standard

- Exemple : hadoop fs -tail / in / xyzfile

15. hadoop fs -test

Cette commande est utilisée pour les opérations de test de fichiers HDFS, elle renvoie 0 si elle est vraie.

- - e: vérifie si le fichier existe.

- -z: vérifie si le fichier est de longueur nulle

- -d / -f: vérifie si le chemin est respectivement répertoire / fichier

Ici, nous discutons d'un exemple en détail

- Exemple : hadoop fs -test - (defz) /user/test/test1.text

16. hadoop fs -du

Affiche la taille des fichiers et des répertoires contenus dans le répertoire donné ou la longueur d'un fichier au cas où il s'agit d'un fichier

17. hadoop fs -df

Il affiche l'espace libre

18. hadoop fs -checksum

Renvoie les informations de contrôle d'un fichier

19. hadoop fs -getfacl

Il affiche la liste de contrôle d'accès (ACL) du fichier ou du répertoire particulier

20. hadoop fs -count

Il compte le nombre de répertoires, fichiers et octets sous le chemin d'accès qui correspond au modèle de fichier spécifié.

21. hadoop fs -setrep

Modifie le facteur de réplication d'un fichier. Et si le chemin est un répertoire, la commande modifie le facteur de réplication de tous les fichiers du répertoire.

- Exemple : hadoop fs -setrep -R / user / datahub: il est utilisé pour accepter la capacité en arrière et n'a aucun effet.

hadoop fs - setrep -w / user / datahub : attend la fin de la réplication

22. hadoop fs -getmerge

Il concatène les fichiers HDFS de la source dans le fichier local de destination

- Exemple : hadoop fs -getmerge / user / datahub

23. hadoop fs -appendToFile

Ajoute une source unique ou plusieurs sources du système de fichiers local à la destination.

- Exemple : hadoop fs -appendToFile xyz.log data.csv / in / appendfile

24. hadoop fs -stat

Il imprime les statistiques sur le fichier ou le répertoire.

- Exemple : hadoop fs -stat (format)

Conclusion - Commandes Hadoop fs

Ainsi, nous avons parcouru presque toutes les commandes qui sont nécessaires pour la gestion des fichiers et afficher les données à l'intérieur des fichiers. Vous pouvez maintenant modifier vos fichiers et ingérer des données dans la plateforme Hadoop.

Articles recommandés

Ceci est un guide des commandes Hadoop fs. Ici, nous discutons en détail de l'introduction aux commandes Hadoop fs ainsi que de son exemple. Vous pouvez également consulter les articles suivants pour en savoir plus-

- Installer Hadoop

- Outils Hadoop

- Architecture Hadoop

- Composants Hadoop

- Commandes Hadoop fs