Qu'est-ce que le théorème de Bayes?

Le théorème de Bayes est une recette qui décrit comment rafraîchir les probabilités des théories lorsqu'elles sont fournies. Il découle essentiellement des maximes de probabilité conditionnelle, mais il peut être utilisé pour raisonner de manière compétente sur un large éventail de questions, y compris le renouvellement des condamnations.

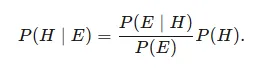

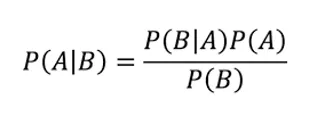

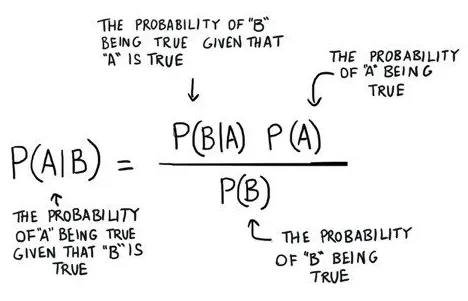

Étant donné une théorie H et une preuve E, le théorème de Bayes exprime que le lien entre la probabilité de la spéculation avant d'obtenir la preuve P (H) et la probabilité de la théorie dans le sillage d'obtenir la preuve P (H∣E) est

C'est un beau concept de probabilité où nous trouvons la probabilité quand nous connaissons une autre probabilité

Ce qui nous dit: à quelle fréquence A se produit étant donné que B se produit, composé de P (A | B),

Quand nous savons: à quelle fréquence B se produit étant donné que An se produit, composé P (B | A)

en outre, la probabilité qu'An est sans personne d'autre, composée de P (A)

de plus, quelle est la probabilité que B soit sans quelqu'un d'autre, composé de P (B)

Exemple de théorème de Bayes

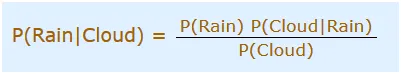

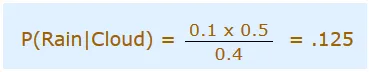

Vous organisez une sortie aujourd'hui, cependant, le matin est couvert, Dieu nous aide! la moitié de chaque jour de tempête commence dans l'ombre! Dans tous les cas, les matins ombragés sont normaux (environ 40% des jours commencent à être nuageux). De plus, il s'agit généralement d'un mois sec (seulement 3 jours sur 30 seront, en général, orageux ou 10%). Quelle est la probabilité d'averse pendant la journée? Nous utiliserons la pluie pour désigner les averses pendant la journée et les nuages pour le matin couvert. La possibilité de pluie donnée Cloud est composée de P (Rain | Cloud)

Nous devons donc placer cela dans l'équation:

- P (Pluie) Probabilité que ce sera Pluie = 10% (Donné)

- P (Nuage | Pluie) Probabilité que les nuages soient là et que la pluie se produise = 50%

- P (Cloud) est la probabilité de présence de nuages = 40%

On peut donc dire que dans c:

C'est le théorème de Bayes: que vous pouvez utiliser la probabilité d'une chose pour prévoir la probabilité d'autre chose. Pourtant, le théorème de Bayes est tout sauf une chose statique. C'est une machine que vous utilisez pour améliorer et améliorer les prévisions en tant que nouvelles surfaces de preuve. Une activité intrigante consiste à agiter les facteurs en reléguant les qualités théoriques distinctives à P (B) ou P (A) et à considérer leur effet cohérent sur P (A | B). Par exemple, dans le cas où vous incrémentez le dénominateur P (B) à droite, à ce point P (A | B) descend. Modèle solide: un nez qui coule est une indication de la rougeole, mais le nez qui coule est indéniablement plus typique que les éruptions cutanées avec de petites taches blanches. Autrement dit, dans le cas où vous choisissez P (B) où B est un nez qui coule, à ce stade, la récurrence des nez qui coule dans le grand public diminue la possibilité que le nez qui coule soit une indication de la rougeole. La probabilité d'une découverte de rougeole diminue en ce qui concerne les effets secondaires qui deviennent progressivement normaux; ces manifestations ne sont pas de solides indications. De même, alors que la rougeole devient de plus en plus normale et que P (A) augmente dans le numérateur à droite, P (A | B) augmente essentiellement, au motif que la rougeole est tout simplement plus probable, sans prêter attention à l'effet secondaire qui vous considerez.

Utilisation du théorème de Bayes dans l'apprentissage automatique

Naive Bayes Classifier

Naive Bayes est un calcul de caractérisation pour les problèmes de regroupement double (deux classes) et multi-classes. Le système est moins exigeant à comprendre lorsqu'il est représenté en utilisant des qualités d'information doubles ou directes.

On l'appelle Bayes naïfs ou Bayes imbéciles à la lumière du fait que le calcul des probabilités pour chaque théorie est simplifié pour rendre leur décompte traçable. Au lieu d'essayer de déterminer les estimations de chaque estime de trait P (d1, d2, d3 | h), elles sont considérées comme étant restrictivement libres étant donné la valeur de l'objectif et déterminées comme P (d1 | h) * P (d2 | H, etc.

Il s'agit d'une supposition solide qui est la plus farfelue dans les informations authentiques, par exemple, que les propriétés ne communiquent pas. Au fur et à mesure, la méthodologie fonctionne étonnamment bien sur les informations où cette présomption ne tient pas.

Représentation utilisée par les modèles Naive Bayes

La représentation d'un algorithme naïf de Bayes est la probabilité.

Les probabilités sont mises de côté pour demander un modèle bayésien naïf savant. Cela comprend:

Probabilité de classe: probabilité pour tout dans l'ensemble de données de préparation.

Probabilité conditionnelle: la probabilité conditionnelle pour chaque information d'instance qui vaut la peine compte tenu de l'estime de chaque classe.

Découvrez un modèle Naive Bayes à partir de données. Prendre un modèle bayésien naïf à partir des informations de préparation est rapide. La préparation est rapide compte tenu du fait que seules les valeurs de probabilité pour chaque instance de la classe et la valeur de probabilité pour chaque instance de la classe donnée des informations distinctives (x) doivent être déterminées. Aucun coefficient ne devrait être ajusté par les systèmes d'amélioration.

Calcul des probabilités de classe

Une probabilité de classe est essentiellement la récurrence des cas qui ont une place avec chaque classe isolée par le nombre complet de cas.

Par exemple, dans une classe parallèle, la probabilité qu'un cas ait une place avec la classe 1 est déterminée comme:

Probabilité (classe = 1) = total (classe = 1) / (total (classe = 0) + total (classe = 1))

Dans le cas le plus simple, chaque classe a une probabilité de 0, 5 ou de moitié pour un problème de classification double avec un nombre similaire d'occurrences dans chaque instance de la classe.

Calcul de la probabilité conditionnelle

Les probabilités conditionnelles sont la récurrence de l'estime de chaque trait pour une classe donnée qui mérite d'être divisée par la récurrence d'exemples avec cette estime de classe.

Toutes les applications du théorème de Bayes

Il y a beaucoup d'utilisations du théorème de Bayes en réalité. Essayez de ne pas insister sur le risque que vous ne voyiez pas tout l'arithmétique inclus immédiatement. Il suffit de se faire une idée de son fonctionnement pour commencer.

La théorie de la décision bayésienne est un moyen mesurable de traiter la question des exemples de classification. Dans cette hypothèse, on s'attend à ce que le transport de probabilité de base pour les classes soit connu. De cette façon, nous acquérons un classificateur Bayes parfait par rapport auquel tout autre classificateur prend une décision d'exécution.

Nous parlerons des trois utilisations fondamentales du théorème de Bayes:

- Classificateur de Naive Bayes

- Fonctions discriminantes et surfaces de décision

- Estimation des paramètres bayésiens

Conclusion

La magnificence et l'intensité du théorème de Bayes ne cessent de m'étonner. Une idée de base, donnée par un prêtre qui est décédé il y a plus de 250 ans, trouve son utilisation dans les procédures d'IA les plus incomparables aujourd'hui.

Articles recommandés

Ceci est un guide du théorème de Bayes. Ici, nous discutons de l'utilisation du théorème de Bayes dans l'apprentissage automatique et de la représentation utilisée par les modèles Naive Bayes avec des exemples. Vous pouvez également consulter les articles suivants pour en savoir plus -

- Algorithme Naive Bayes

- Types d'algorithmes d'apprentissage automatique

- Modèles d'apprentissage automatique

- Méthodes d'apprentissage automatique