Différence entre Hadoop et Spark

Hadoop est un framework open-source qui permet de stocker et de traiter des mégadonnées, dans un environnement distribué sur des clusters d'ordinateurs. Hadoop est conçu pour passer d'un serveur unique à des milliers de machines, où chaque machine offre un calcul et un stockage locaux. Spark est un cluster computing open source conçu pour un calcul rapide. Il fournit une interface pour la programmation de clusters entiers avec parallélisme de données implicite et tolérance aux pannes. La principale caractéristique de Spark est l'informatique en grappes en mémoire qui augmente la vitesse d'une application.

Hadoop

- Hadoop est une marque déposée de la fondation de logiciels Apache. Il utilise un modèle de programmation simple pour effectuer l'opération requise parmi les clusters. Tous les modules dans Hadoop sont conçus avec l'hypothèse fondamentale que les pannes matérielles sont des occurrences courantes et doivent être traitées par le framework.

- Il exécute l'application à l'aide de l'algorithme MapReduce, où les données sont traitées en parallèle sur différents nœuds de CPU. En d'autres termes, le framework Hadoop est suffisamment capable pour développer des applications, qui sont en outre capables de fonctionner sur des clusters d'ordinateurs et ils pourraient effectuer une analyse statistique complète pour une énorme quantité de données.

- Le cœur de Hadoop se compose d'une partie de stockage, connue sous le nom de système de fichiers distribués Hadoop et d'une partie de traitement appelée modèle de programmation MapReduce. Hadoop divise essentiellement les fichiers en grands blocs et les distribue sur les clusters, transfère le code du package dans des nœuds pour traiter les données en parallèle.

- Cet ensemble de données d'approche doit être traité plus rapidement et plus efficacement. D'autres modules Hadoop sont communs à Hadoop, qui est un tas de bibliothèques Java et d'utilitaires renvoyés par les modules Hadoop. Ces bibliothèques fournissent une abstraction au niveau du système de fichiers et du système d'exploitation, contiennent également les fichiers et scripts Java requis pour démarrer Hadoop. Hadoop Yarn est également un module utilisé pour la planification des travaux et la gestion des ressources de cluster.

Étincelle

- Spark a été construit sur le dessus du module Hadoop MapReduce et il étend le modèle MapReduce pour utiliser efficacement plus de types de calculs qui incluent les requêtes interactives et le traitement de flux. Spark a été introduit par la fondation du logiciel Apache, pour accélérer le processus du logiciel de calcul informatique Hadoop.

- Spark a sa propre gestion de cluster et n'est pas une version modifiée de Hadoop. Spark utilise Hadoop de deux manières: la première est le stockage et la seconde le traitement. Étant donné que la gestion des clusters arrive de Spark lui-même, elle utilise Hadoop à des fins de stockage uniquement.

- Spark est l'un des sous-projets de Hadoop qui a été développé en 2009, et plus tard il est devenu open source sous une licence BSD. Il a beaucoup de fonctionnalités merveilleuses, en modifiant certains modules et en incorporant de nouveaux modules. Il permet d'exécuter une application dans un cluster Hadoop, plusieurs fois plus rapidement en mémoire.

- Ceci est rendu possible en réduisant le nombre d'opérations de lecture / écriture sur le disque. Il stocke les données de traitement intermédiaires en mémoire, sauvant les opérations de lecture / écriture. Spark fournit également des API intégrées en Java, Python ou Scala. Ainsi, on peut écrire des applications de plusieurs manières. Spark fournit non seulement une stratégie de carte et de réduction, mais prend également en charge les requêtes SQL, les données en streaming, l'apprentissage automatique et les algorithmes graphiques.

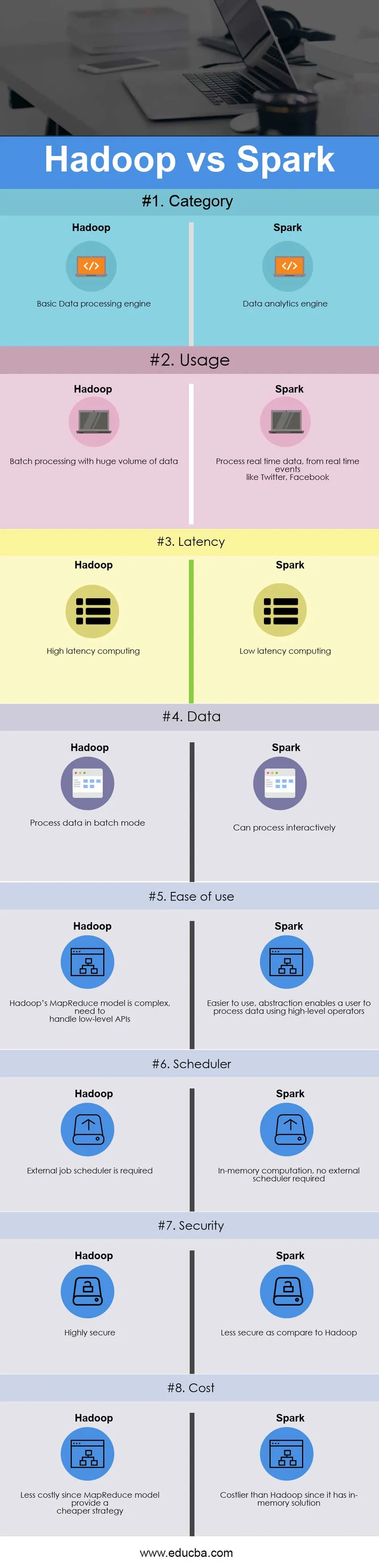

Comparaison directe entre Hadoop et Spark (infographie)

Voici la différence entre les 8 meilleurs Hadoop et Spark

Différences clés entre Hadoop et Spark

Les deux Hadoop vs Spark sont des choix populaires sur le marché; laissez-nous discuter de certaines des principales différences entre Hadoop et Spark:

- Hadoop est un framework open source qui utilise un algorithme MapReduce tandis que Spark est une technologie informatique en cluster ultra-rapide, qui étend le modèle MapReduce pour l'utiliser efficacement avec plus de types de calculs.

- Le modèle MapReduce de Hadoop lit et écrit à partir d'un disque, ralentissant ainsi la vitesse de traitement tandis que Spark réduit le nombre de cycles de lecture / écriture sur le disque et stocke les données intermédiaires en mémoire, d'où une vitesse de traitement plus rapide.

- Hadoop demande aux développeurs de coder manuellement chaque opération, tandis que Spark est facile à programmer avec RDD - Resilient Distributed Dataset.

- Le modèle Hadoop MapReduce fournit un moteur de traitement par lots, donc dépendant de différents moteurs pour d'autres exigences, tandis que Spark effectue des traitements par lots, interactifs, d'apprentissage automatique et de streaming dans le même cluster.

- Hadoop est conçu pour gérer efficacement le traitement par lots tandis que Spark est conçu pour gérer efficacement les données en temps réel.

- Hadoop est un cadre informatique à latence élevée, qui n'a pas de mode interactif, tandis que Spark est un ordinateur à faible latence et peut traiter les données de manière interactive.

- Avec Hadoop MapReduce, un développeur peut uniquement traiter des données en mode batch alors que Spark peut traiter des données en temps réel via Spark Streaming.

- Hadoop est conçu pour gérer les pannes et les pannes, il est naturellement résistant aux pannes, d'où un système très tolérant aux pannes alors qu'avec Spark, RDD permet la récupération des partitions sur les nœuds défaillants.

- Hadoop a besoin d'un planificateur de travaux externe par exemple - Oozie pour planifier des flux complexes tandis que Spark a un calcul en mémoire, donc il a son propre planificateur de flux.

- Hadoop est une option moins chère disponible en la comparant en termes de coût, tandis que Spark nécessite beaucoup de RAM pour fonctionner en mémoire, augmentant ainsi le cluster et donc le coût.

Tableau de comparaison Hadoop vs Spark

La comparaison principale entre Hadoop et Spark est discutée ci-dessous

| La base de comparaison entre Hadoop vs Spark |

Hadoop |

Étincelle |

| Catégorie | Moteur de traitement de données de base | Moteur d'analyse de données |

| Usage | Traitement par lots avec un énorme volume de données | Traitez les données en temps réel, à partir d'événements en temps réel comme Twitter, Facebook |

| Latence | Informatique à latence élevée | Informatique à faible latence |

| Les données | Traiter les données en mode batch | Peut traiter de manière interactive |

| Facilité d'utilisation | Le modèle MapReduce de Hadoop est complexe, il faut gérer les API de bas niveau | Plus facile à utiliser, l'abstraction permet à un utilisateur de traiter des données à l'aide d'opérateurs de haut niveau |

| Planificateur | Planificateur de travaux externe requis | Calcul en mémoire, aucun planificateur externe requis |

| Sécurité | Hautement sécurisé | Moins sûr que Hadoop |

| Coût | Moins coûteux car le modèle MapReduce offre une stratégie moins chère | Plus coûteux que Hadoop car il dispose d'une solution en mémoire |

Conclusion - Hadoop vs Spark

Hadoop MapReduce permet le traitement parallèle de grandes quantités de données. Il divise un gros morceau en plus petits à traiter séparément sur différents nœuds de données et rassemble automatiquement les résultats sur les multiples nœuds pour retourner un seul résultat. Dans le cas où l'ensemble de données résultant est plus grand que la RAM disponible, Hadoop MapReduce peut surpasser Spark.

Spark, en revanche, est plus facile à utiliser que Hadoop, car il est livré avec des API conviviales pour Scala (sa langue maternelle), Java, Python et Spark SQL. Étant donné que Spark fournit un moyen d'effectuer la diffusion en continu, le traitement par lots et l'apprentissage automatique dans le même cluster, les utilisateurs trouvent qu'il est facile de simplifier leur infrastructure pour le traitement des données.

La décision finale de choisir entre Hadoop et Spark dépend du paramètre de base - l'exigence. Apache Spark est un moteur informatique de cluster beaucoup plus avancé que MapReduce de Hadoop, car il peut gérer tout type d'exigence, c'est-à-dire batch, interactif, itératif, streaming, etc. tandis que Hadoop limite le traitement par lots uniquement. Dans le même temps, Spark est plus coûteux que Hadoop avec sa fonctionnalité en mémoire, qui nécessite finalement beaucoup de RAM. En fin de compte, tout dépend du budget et des exigences fonctionnelles d'une entreprise. J'espère que vous devez maintenant avoir une idée plus juste de Hadoop vs Spark.

Article recommandé

Cela a été un guide pour la différence entre Hadoop et Spark. Ici, nous discutons également des différences clés entre Hadoop et Spark avec des infographies et un tableau de comparaison. Vous pouvez également consulter les articles Hadoop vs Spark suivants pour en savoir plus.

- Entrepôt de données vs Hadoop

- Splunk vs Spark

- Hadoop vs Cassandra - 17 différences impressionnantes

- Pig vs Spark - Lequel est le meilleur

- Hadoop vs performances SQL: différence