Introduction aux commandes Sqoop

Dans Sqoop Commands, chaque ligne est traitée comme des enregistrements et les tâches sont subdivisées en sous-tâches par Map Task Internally. Les bases de données prises en charge par sqoop sont MYSQL, Oracle, IBM, PostgreSQL. Sqoop fournit une ligne de commande simple, nous pouvons récupérer les données de la base de données différente via les commandes sqoop. Ils sont écrits en Java et utilisent JDBC pour la connexion à d'autres bases de données.

Il signifie «SQL to Hadoop» et Hadoop to SQL et un outil open source. Il s'agit d'un outil de connectivité d'application com qui transfère des données en vrac entre le système de base de données relationnelle et Hadoop (Hive, map Reduce, Mahout, Pig, HBase). Ils permettent aux utilisateurs de spécifier l'emplacement cible à l'intérieur de Hadoop et de faire sqoop pour déplacer les données du RDMS vers la cible. Ils fournissent des connecteurs MySQL optimisés qui utilisent une API spécifique à la base de données pour effectuer complètement des transferts en masse. L'utilisateur importe des données à partir de sources externes comme Hive ou Hbase. Le sqoop a deux formats de fichier: format de fichier texte délimité et format de fichier séquence.

Voici les commandes de base des commandes Sqoop:

-

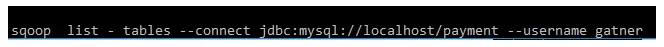

Tableau de liste:

Cette commande répertorie la table particulière de la base de données dans le serveur MYSQL.

Exemple:

-

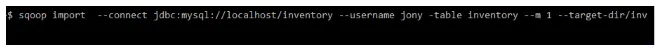

Répertoire cible:

Cette commande importe la table dans un répertoire spécifique de HDFS. -m désigne l'argument mappeur. Ils ont une valeur entière.

Exemple:

-

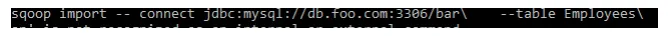

Mot de passe de protection:

Exemple:

-

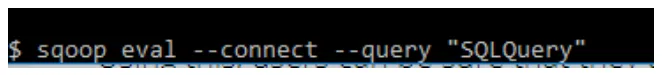

sqoop-eval:

Cette commande exécute rapidement les requêtes SQL de la base de données respective.

Exemple:

-

sqoop - version:

Cette commande affiche la version de sqoop.

Exemple:

-

sqoop-job

Cette commande nous permet de créer un job, les paramètres créés peuvent être invoqués à tout moment. Ils prennent des options comme (–créer, –supprimer, –montrer, –exit).

Exemple:

-

Chargement du fichier CSV dans SQL:

Exemple:

-

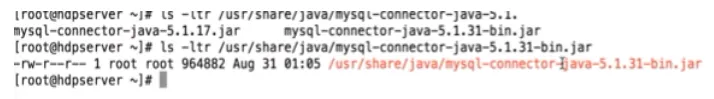

Connecteur:

Exemple:

-

code gen:

Cette commande Sqoop crée des fichiers de classe java qui encapsulent les enregistrements importés. Tous les fichiers java sont recréés et de nouvelles versions d'une classe sont générées. Ils génèrent du code pour interagir avec les enregistrements de la base de données. Récupère une liste de toutes les colonnes et de leurs types de données.

Exemple:

10.Liste-base de données:

Cette liste de commandes Sqoop contient toute la base de données disponible sur le serveur SGBDR.

exemple:

Commandes intermédiaires des commandes Sqoop:

1.sqoop -meta magasin:

Cette commande héberge un référentiel de métadonnées partagé. Les utilisateurs multiples / distants peuvent exécuter plusieurs travaux.

Commander:

$ sqoop .metastore.client.autoconnect.url

exemple: jdbc: hsqldb: hsql: // metastore .example.com / sqoop

2. sqoop -help:

Cette commande répertorie les outils disponibles dans sqoop et leur fonction.

Commander:

$ sqoop help

$ bin / sqoop help import

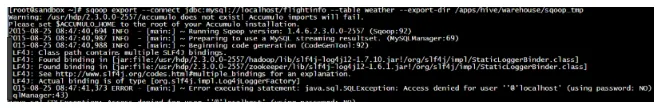

3. Exportation:

Cette commande exporte les données de HDFS vers la base de données RDMS. Dans HDFS, les données sont stockées sous forme d'enregistrements.

Commander:

$ sqoop export \ –connect jdbc: mysql: // localhost / inventory - username jony –table lib –export -dir / user / jony / inventory.

4. Insérez:

Cette commande insère un nouvel enregistrement de HDFS dans la table RDBMS.

Commander

$ sqoop export –connect JDBC: MySQL: // localhost / sqoop_export - table emp_exported –export -dir / sqoop / newemp -m -000

5. Mise à jour:

Cette commande Sqoop met à jour les enregistrements dans le SGBDR à partir des données HDFS.

Commander

$ sqoop export –connect JDBC: MySQL: // localhost / sqoop_export - table emp_exported –export -dir / sqoop / newemp -m -000 –update -key id

6. Option de lot:

Cette commande insère plusieurs lignes ensemble, elles optimisent la vitesse d'insertion en utilisant le pilote Sqoop JDBC.

Commander

$ sqoop export \ -connect JDBC: MySQL: // hostname / –username -password -export -dir

7. Split:

Lorsque cette commande est utilisée, la clause where est appliquée à l'ensemble du SQL.

Commander

$ sqoop import -D mysql: // jdbc: // where.clause.location = SPLIT –table JUNK –où “rownum <= 12”

8. Fichier AVRO en HDFS:

Ils stockent les données RDBMS sous forme de fichier Avro.

Commander

$ sqoop import –connect JDBC: MySQL: // localhost / Acadgild –username root –password pp.34 –table payment -m1 –target -dir / sqoop_data / payment / avro / == as -avrodatfile.

Commandes avancées des commandes Sqoop:

Commandes d'importation:

Les commandes d'importation ont des arguments de contrôle d'importation. les différents arguments sont les suivants:

- limite: utilisé pour créer des divisions.

- as - fichier texte: importe des données en texte brut

- -colonnes (: importer des colonnes pour la table

- -m, - num: pour importer des tâches de mappage parallèles

- divisé par: fractionne la colonne du tableau

- -z, - compress: la compression des données est activée.

Arguments d'importation incrémentielle:

- check-column: indique les colonnes pour déterminer les lignes à importer.

- incrémental (mode): indique les nouvelles lignes (inclure l'ajout et la dernière ligne de modification)

Arguments de ligne de sortie:

- lignes terminées -par: elles définissent le caractère eol

- MySQL - délimiteurs: ils définissent \ n champs: lignes:

Importer dans Hive

-hive - import: ils importent des tables dans la ruche

-hive - partition-key: le nom de la partition est partagé.

-hive - overwrite: ils écrasent les données de la table existante.

Importer dans les arguments Hbase:

-accumulo-table: Ceci spécifie la table cible dans HBase.

-accumulo -column: Pour l'importer, il définit la colonne cible.

-accumulo -: Pour importer le nom de l'accumulo

–Accumulo -: Pour importer le mot de passe de l'accumulo

Stockage dans des fichiers de séquence:

$ sqoop import -connect jdbc: mysql: //db.foo.com/emp -table Inventory \ - nom-classe com.foo.com.Inventory -as - sequencefile

Importation de requête:

Cette commande spécifie l'instruction Sql avec l'argument -query.

$ sqoop import \ –query 'SELECT a. *, b. * from a JOIN b on (a.id = b.id) where $ conditions' \ -split - by / target-dir / user

Exportations incrémentielles:

$ sqoop export –connect –table –username –password –incremental –check-row –last-value

Importation de toutes les tables vers HDFS:

$ sqoop import -all - tables –connect jdbc: mysql: // localhost / sale_db - root du nom d'utilisateur.

Importation de données dans Hive:

$ sqoop import –connect –table –username –password –hive -import - hive -table

Importation de données vers HBase:

commander:

$ sqoop import –connect –table –username –password –hive -import - HBase -table

Encode des valeurs nulles:

commander:

$ mysql import \ –connect JDBC: MySQL: //mysql.ex.com/sqoop \ –username sqoop \ -password sqoop \ –table lib \ –null -string '

Trucs et astuces pour utiliser les commandes Sqoop:

Si nous voulons exécuter les opérations de données efficacement, nous devons utiliser sqoop, juste à travers une seule ligne de commande, nous pouvons y effectuer de nombreuses tâches et sous-tâches. Sqoop se connecte à différentes bases de données relationnelles via des connecteurs, ils utilisent le pilote JDBC pour interagir avec lui. Étant donné que sqoop s'exécute sur sa propre source, nous pouvons exécuter sqoop sans processus d'installation. L'exécution de sqoop est simple car exécutez les données en parallèle. En utilisant Map Reduce, nous pouvons importer et exporter des données, ce qui permet une exécution parallèle.

Conclusion - Commandes Sqoop:

Pour conclure, Sqoop Commands régule le processus d'importation et d'exportation des données. Sqoop fournit la possibilité de mettre à jour les parties de la table par la charge incrémentielle. L'importation de données dans sqoop n'est pas pilotée par les événements. Et il y a sqoop2 avec une interface graphique activée pour un accès facile avec la ligne de commande. Le transfert de données est rapide car ils transfèrent en parallèle. Ils jouent un rôle vital dans l'environnement Hadoop. Ils font leur travail seuls, ce qui n'est pas nécessaire lors de l'importation de petits ensembles de données.

Articles recommandés

Cela a été un guide pour les commandes Sqoop. Ici, nous avons discuté des commandes Sqoop de base et avancées et de certaines commandes Sqoop immédiates. Vous pouvez également consulter l'article suivant pour en savoir plus -

- Questions et réponses de l'entrevue de Sqoop

- Aide-mémoire SQL (commandes, conseils gratuits et astuces)

- Commandes VBA importantes

- Commandes Tableau