Différence entre Apache Hive et Apache Spark SQL

Avec l'augmentation massive des technologies de Big Data aujourd'hui, il devient très important d'utiliser le bon outil pour chaque processus. Le processus peut être quelque chose comme l'ingestion de données, le traitement des données, la récupération de données, le stockage de données, etc. Dans cet article, nous allons lire deux de ces outils de récupération de données, Apache Hive et Apache Spark SQL. Hive, d'une part, est connu pour son traitement efficace des requêtes en utilisant HQL (Hive Query Language) de type SQL et est utilisé pour les données stockées dans Hadoop Distributed File System tandis que Spark SQL utilise un langage de requête structuré et s'assure que tous les opérations de lecture et d'écriture en ligne sont prises en charge. Hive est connu pour être le composant de l'écosystème Big Data où les mappeurs et réducteurs hérités sont nécessaires pour traiter les données de HDFS tandis que Spark SQL est connu pour être le composant de l'API Apache Spark qui a rendu le traitement sur l'écosystème Big Data beaucoup plus facile et réel. -temps. Une idée fausse majeure que la plupart des professionnels ont aujourd'hui est que la ruche ne peut être utilisée qu'avec des technologies et des outils de Big Data hérités tels que PIG, HDFS, Sqoop, Oozie. Cette affirmation n'est pas complètement vraie car Hive est compatible non seulement avec les outils hérités mais également avec d'autres composants basés sur Spark, comme Spark Streaming. L'idée sous-jacente à leur utilisation est de réduire l'effort et d'apporter de meilleurs résultats pour l'entreprise. Étudions en détail Apache Hive et Apache Spark SQL.

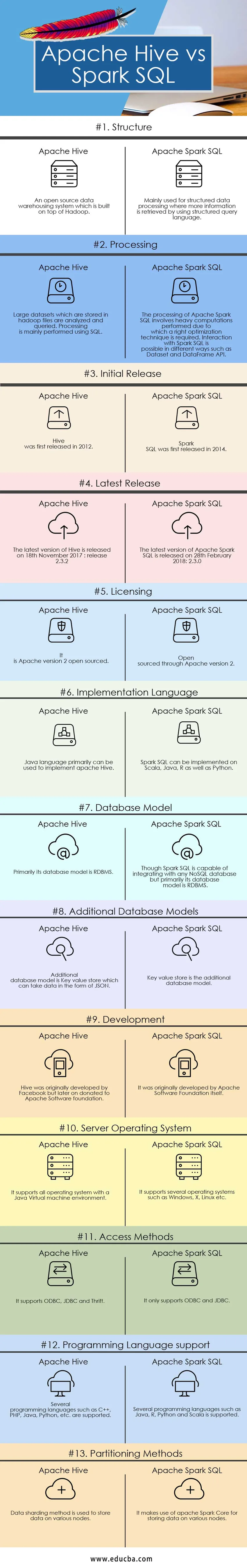

Comparaison directe entre Apache Hive et Apache Spark SQL (Infographie)

Vous trouverez ci-dessous le top 13 des comparaisons entre Apache Hive et Apache Spark SQL

Différences clés entre Apache Hive et Apache Spark SQL

Différences clés entre Apache Hive et Apache Spark SQL

Les différences entre Apache Hive et Apache Spark SQL sont discutées dans les points mentionnés ci-dessous:

- Hive est connu pour utiliser HQL (Hive Query Language) tandis que Spark SQL est connu pour utiliser le langage Structured Query pour le traitement et l'interrogation des données

- Hive offre une flexibilité de schéma, un fractionnement et un regroupement des tables, tandis que Spark SQL effectue des requêtes SQL, il est uniquement possible de lire les données de l'installation Hive existante.

- Hive fournit des droits d'accès pour les utilisateurs, les rôles ainsi que les groupes, tandis que Spark SQL ne fournit aucun droit d'accès à un utilisateur.

- Hive offre la possibilité d'un facteur de réplication sélectif pour le stockage redondant des données tandis que spark SQL, d'autre part, ne fournit aucun facteur de réplication pour le stockage des données

- Comme les pilotes JDBC, ODBC et thrift sont disponibles dans Hive, nous pouvons les utiliser pour générer des résultats alors que dans le cas d'Apache Spark SQL, nous pouvons récupérer les résultats sous la forme de Datasets et DataFrame API si Spark SQL est exécuté avec un autre langage de programmation

- Il existe plusieurs limitations:

- Les mises à jour au niveau des lignes et les requêtes OLTP en temps réel ne sont pas possibles avec Apache Hive, tandis que les mises à jour au niveau des lignes et le traitement des transactions en ligne en temps réel sont possibles avec Spark SQL.

- Fournit une latence élevée acceptable pour la navigation interactive de données alors que dans Spark SQL, la latence fournie est au minimum pour améliorer les performances.

- Hive, comme les instructions et les requêtes SQL, prend en charge le type UNION tandis que Spark SQL est incapable de prendre en charge le type UNION.

Tableau de comparaison Apache Hive vs Apache Spark SQL

| Base de comparaison | Apache Hive | Apache Spark SQL |

| Structure | Un système d'entreposage de données open source qui est construit sur Hadoop | Principalement utilisé pour le traitement de données structurées où plus d'informations sont récupérées en utilisant un langage de requête structuré. |

| En traitement | Les grands ensembles de données qui sont stockés dans des fichiers hadoop sont analysés et interrogés. Le traitement est principalement effectué à l'aide de SQL. | Le traitement d'Apache Spark SQL implique des calculs lourds effectués en raison desquels une bonne technique d'optimisation est requise. L'interaction avec Spark SQL est possible de différentes manières telles que Dataset et DataFrame API. |

| Première version | Hive est sorti pour la première fois en 2012 | Spark SQL a été lancé pour la première fois en 2014 |

| Dernière version | La dernière version de Hive est sortie le 18 novembre 2017: release 2.3.2 | La dernière version d'Apache Spark SQL est sortie le 28 février 2018: 2.3.0 |

| Licence | C'est Apache version 2 open source | Open source via Apache version 2 |

| Langage d'implémentation | Le langage Java peut principalement être utilisé pour implémenter apache Hive | Spark SQL peut être implémenté sur Scala, Java, R ainsi que Python |

| Modèle de base de données | Son modèle de base de données est principalement le SGBDR | Bien que Spark SQL soit capable de s'intégrer à n'importe quelle base de données NoSQL, mais principalement son modèle de base de données est RDBMS |

| Modèles de base de données supplémentaires | Le modèle de base de données supplémentaire est un magasin de valeurs-clés qui peut prendre des données sous forme de JSON | Le magasin de valeurs-clés est le modèle de base de données supplémentaire |

| Développement | Hive a été développé à l'origine par Facebook, mais plus tard donné à la fondation Apache Software | Il a été initialement développé par Apache Software Foundation elle-même |

| Système d'exploitation serveur | Il prend en charge tous les systèmes d'exploitation avec un environnement de machine virtuelle Java | Il prend en charge plusieurs systèmes d'exploitation tels que Windows, X, Linux, etc. |

| Méthodes d'accès | Il prend en charge ODBC, JDBC et Thrift | Il prend uniquement en charge ODBC et JDBC |

| Prise en charge du langage de programmation | Plusieurs langages de programmation tels que C ++, PHP, Java, Python, etc. sont pris en charge | Plusieurs langages de programmation tels que Java, R, Python et Scala sont pris en charge |

| Méthodes de partitionnement | La méthode de partage des données est utilisée pour stocker des données sur divers nœuds | Il utilise Apache Spark Core pour stocker des données sur différents nœuds |

Conclusion - Apache Hive vs Apache Spark SQL

Nous ne pouvons pas dire qu'Apache Spark SQL remplace Hive ou vice-versa. C'est juste que Spark SQL peut être considéré comme une API basée sur Spark conviviale pour les développeurs qui vise à faciliter la programmation. Hive a sa capacité spéciale de commutation fréquente entre les moteurs et est donc un outil efficace pour interroger de grands ensembles de données. L'utilisation et la mise en œuvre des choix dépendent de vos objectifs et de vos exigences. Ils sont tous les deux Apache Hive et Apache Spark SQL dans leur propre domaine. J'espère qu'après avoir lu le message, vous aurez une idée assez juste des besoins de votre organisation. Suivez notre blog pour plus de messages comme ceux-ci et nous nous assurons de fournir des informations qui favorisent votre entreprise.

Article recommandé

Ceci a été un guide pour Apache Hive vs Apache Spark SQL, leur signification, comparaison tête à tête, différences clés, tableau de comparaison et conclusion. Vous pouvez également consulter les articles suivants pour en savoir plus -

- Différences entre Java et Node JS

- Apache Pig vs Apache Hive - 12 principales différences utiles

- Hadoop vs Hive - Découvrez les meilleures différences

- 7 choses importantes et utiles sur Apache Spark (Guide)

- Apache Hadoop vs Apache Spark | Top 10 des comparaisons que vous devez savoir!

- Utilisation de la fonction ORDER BY dans Hive