Comment installer Hive?

Apache Hadoop est une collection du framework qui permet le traitement des mégadonnées réparties sur le cluster. Selon Apache Hive est un projet de logiciel d'entrepôt de données construit sur Apache Hadoop pour fournir des requêtes et des analyses de données. Apache hive fournit une interface de type SQL pour interroger et traiter une grande quantité de données appelées HQL (Hive query language). La ruche Apache s'exécute au-dessus de l'écosystème Hadoop et les données stockées sous forme de fichier correspondent au système de fichiers distribué Hadoop (HDFS). Apache Hive fournit une excellente interface à l'utilisateur pour accéder et effectuer une opération sur les données sous la forme d'un tableau, il fournit une excellente technique d'optimisation pour améliorer les performances. Il est très difficile d'accélérer la requête avec les mégadonnées et croyez-moi, cela compte dans un environnement de production.

Dans le backend, le compilateur convertit la requête HQL en carte réduit les travaux et ensuite soumis au framework Hadoop pour les exécutions.

Différence entre Hive et SQL

Apache Hive est très similaire à SQL, mais comme nous le savons, la ruche fonctionne au-dessus de l'écosystème Hadoop et convertit en interne les travaux en MR (travaux de réduction de carte), cela fait une différence entre Hive et SQL.

Hive ne serait pas la meilleure approche pour les applications nécessitant une réponse très rapide et il est très important de comprendre que Hive est mieux adapté au traitement par lots sur de très grands ensembles de données immuables et nous devons noter que Hive est un SGBDR régulier et en dernier mais pas moins apache hive est un schéma sur les moyens de lecture (lors de l'insertion de données dans la table de ruche, il ne se souciera pas de la non-concordance du type de données, mais lors de la lecture des données, il affichera une valeur nulle si le type de données n'est pas associé au type de données d'une colonne spécifique).

Exigence préalable pour installer Hive

Comme je l'ai dit plus tôt, il est très important de comprendre que les ruches Apache se trouvent au-dessus de l'écosystème Hadoop et que Hadoop devrait être opérationnel avec tous les démons.

Certains des démons de base Hadoop sont les suivants:

- Nœud de nom

- Nœud de données

- Gestionnaire de ressources

- Gestionnaire de nœuds

Pour vérifier la version Hadoop ci-dessous est la commande:

Tapez → Version Hadoop dans l'invite de commande, il vous donnera la version de Hadoop.

Pour vérifier la commande de déclenchement du rapport de cluster Hadoop ci-dessous:

Tapez → Hadoop dfsadmin –report dans l'invite de commande, il vous donnera le rapport de cluster entier si votre serveur est en cours d'exécution.

Si Hadoop n'est pas installé sur votre machine, vous demandant de suivre les instructions apache pour installer Hadoop sur votre système.

J'espère que java a déjà été installé sur votre système également. pour vérifier la version java, veuillez vous référer à la capture d'écran ci-dessous.

Étapes pour installer Hive sur Ubuntu

Voici les étapes pour installer Hive sur Ubuntu:

Étape 1 : Hive tar que nous pouvons télécharger en utilisant la commande ci-dessous dans le terminal, nous pouvons également télécharger directement à partir du terminal.

Commande: nous obtenons http://archive.apache.org/dist/hive/hive-2.1.0/apache-hive-2.1.0-bin.tar.gz

Étape 2 : Extraire le fichier tar en utilisant la commande ci-dessous dans le terminal, nous pouvons extraire directement le fichier tar au-dessus du fichier tar tar ruche tar.

Commande: tar -xzf apache-hive-2.1.0-bin.tar.gz

Je vous suggère de vérifier avec la commande ls le fichier de ruche extrait.

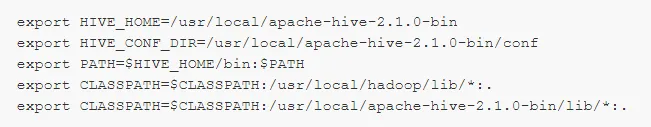

Étape 3: modifiez le fichier « .bashrc » pour mettre à jour les variables d'environnement pour l'utilisateur.

Commande: sudo le .bashrc

Ajoutez ce qui suit à la fin du fichier:

# Définir HIVE_HOME

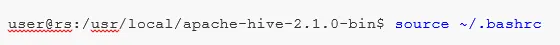

Exécutez la commande ci-dessous pour terminer le travail de modification dans le terminal actuel.

Commande: source .bashrc

Étape 5 : Nous devons créer des répertoires Hive dans un emplacement HDFS et ce répertoire «entrepôt» sera l'emplacement où stocker les informations relatives aux métadonnées de la table Hive et les données liées à Hive.

Commande :

- hdfs dfs -mkdir -p / utilisateur / ruche / entrepôt

- hdfs dfs -mkdir / tmp

Étape 6 : Pour définir l'autorisation de lecture et d'écriture pour la table ruche, exécutez la commande ci-dessous.

Commander:

Dans la commande ci-dessous, fournissant une autorisation d'écriture au groupe d'utilisateurs:

- hdfs dfs -chmod g + w / utilisateur / ruche / entrepôt

- hdfs dfs -chmod g + w / tmp

Configuration de Hive: Il est très important de pointer l'installation de la ruche pour la configurer avec Hadoop. Nous devons éditer hive-env.sh, un fichier qui est placé dans le répertoire $ HIVE_HOME / conf. Les commandes suivantes redirigent vers le dossier Hive conf et copient le fichier modèle:

Étape 7 : Définissez un chemin Hadoop dans hive-env.sh

Modifiez le fichier hive-env.sh en ajoutant la ligne suivante:

Maintenant, par ce processus, nous avons presque terminé et les installations de ruche ont été effectuées avec succès, il est important de configurer Metastore avec le serveur de base de données externe et par défaut, le framework Apache Hive utilise la base de données Derby. En utilisant la commande ci-dessous Initialisation de la base de données Derby.

Commande: bin / schematool -initSchema -dbType derby

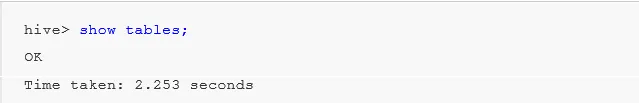

Étape 8 : Lancez Hive .

Commande: ruche (tapez ruche dans le terminal dans le deuxième terminal de ruche s'ouvrira.)

Travailler avec Hive: Maintenant, nous allons voir certaines des opérations dans la ruche pour voir combien de tables que nous avons dans la base de données par défaut utilisent se référer aux captures d'écran ci-dessous dans les captures d'écran ci-dessous, il n'affiche aucune table signifie que nous n'avons pas de tables dans la base de données par défaut .

Pour créer une table dans la ruche, il est très important de se référer à la base de données requise, sinon toute table sera créée sous la base de données par défaut.

Commandes importantes dans Hive

1: afficher les bases de données (il affichera toutes les bases de données créées jusqu'à présent).

2: créer la base de données si elle n'existe pas mydb (cette commande créera une base de données avec le nom de ' mydb' si ' mydb' n'existe pas et si ' mydb existe déjà elle ne donnera pas d'erreur non plus')

3: utiliser la base de données chaque fois que nous devons utiliser une commande DDl sur la base de données particulière, nous devons utiliser la commande "utiliser la base de données" dans notre cas, nous avons déjà créé "mydb" La commande show serait utilisée mydb.

Commande Hive DDL importante

CRÉER, DÉPOSER, TRONCER, MONTRER, DÉCRIRE .

- Créer : - Créez une instruction utilisée pour créer une base de données ou créez une table dans la ruche.

Exemple: ruche> créer une base de données Société; (création de base de données)

Ruche> utiliser la société;

Hive> créer un employé de table (id int, chaîne de nom, chaîne de salaire); (cela créera une table employee sous la base de données Company car nous avons déjà exécuté la commande Use database.)

- Décrire fournit des informations sur le schéma de la table.

Ruche> décrire l'employé; (cela donnera les détails du schéma de la table des employés en détails)

- TRUNCATE supprimera les données de la table.

Hive> employé de table tronquée;

Nous pouvons également installer la ruche sur une fenêtre, mais pour les meilleures pratiques, je préférerai Ubuntu à utiliser, cela donnera une meilleure vue de l'environnement de production et vos données augmenteront à l'avenir, elles seront faciles à gérer.

Articles recommandés

Cela a été un guide pour installer Hive. Ici, nous avons discuté des différentes étapes pour installer Hive, la commande DDL, etc. Vous pouvez également consulter les articles suivants pour en savoir plus:

- Comment installer SQL Server

- Comment installer MATLAB

- Commandes et fonctionnalité de la ruche

- Questions d'entretiens chez Basic Hive

- Architecture de la ruche | WorkFlow

- Utilisation de la fonction ORDER BY dans Hive

- Installation de ruche