Différences entre l'exploration de texte et l'analyse de texte

Les données structurées existent depuis le début des années 1900, mais ce qui rend l'extraction de texte et l'analyse de texte si spéciales, c'est qu'elles exploitent les informations à partir de données non structurées (Natural Language Processing). Une fois que nous serons en mesure de convertir ce texte non structuré en données semi-structurées ou structurées, il sera disponible pour appliquer tous les algorithmes d'exploration de données ex. Algorithmes statistiques et d'apprentissage automatique.

Même Donald Trump a été en mesure d'exploiter les données et de les convertir en informations qui l'ont aidé à remporter les élections présidentielles américaines, eh bien, fondamentalement, il n'a pas fait ce que ses subordonnés ont fait. Il y a un très bon article là-bas http://fivethirtyeight.com/features/the-real-story-of-2016/ vous pouvez le parcourir.

De nombreuses entreprises ont commencé à utiliser l'exploration de texte pour utiliser des entrées précieuses à partir du texte disponible sur le marché, par exemple, une entreprise basée sur un produit peut utiliser les données Twitter / Facebook pour savoir à quel point son produit se porte bien dans le monde en utilisant Sentimental. Une analyse. Au début, le traitement prenait beaucoup de temps, des jours, en fait, pour traiter ou même implémenter les algorithmes d'apprentissage automatique, mais avec l'introduction d'outils tels que Hadoop, Azure, KNIME et d'autres logiciels de traitement de données volumineuses, c'est le l'exploration de texte a gagné une énorme popularité sur le marché. L'un des meilleurs exemples d'analyse de texte utilisant le minage d'association est le moteur de recommandation d'Amazon, où il donne automatiquement à ses clients des recommandations sur ce que d'autres personnes ont acheté lors de l'achat d'un produit particulier.

L'un des plus grands défis de l'application d'outils d'exploration de texte à quelque chose qui n'est pas au format numérique / sur un ordinateur est le processus de fabrication. Les anciennes archives et de nombreux documents importants qui ne sont disponibles que sur papier sont parfois lus par OCR (Optical Character Recognition) qui contiennent de nombreuses erreurs et parfois les données sont entrées manuellement, ce qui est sujet à des erreurs humaines. La raison pour laquelle nous les voulons est que nous pouvons être en mesure de tirer d'autres idées qui ne sont pas visibles de la lecture traditionnelle.

Certaines des étapes de l'exploration de texte sont les suivantes

- Récupération de l'information

- Préparation et nettoyage des données

- Segmentation

- Tokenisation

- Suppression des chiffres et des signes de ponctuation

- Stemming

- Convertir en minuscules

- Marquage POS

- Créer un corpus de texte

- Matrice terme-document

Et ci-dessous sont les étapes de l'analyse de texte qui sont appliquées après la préparation de la matrice de documents terminologiques

- Modélisation (Cela peut inclure des modèles inférentiels, des modèles prédictifs ou des modèles normatifs)

- Formation et évaluation de modèles

- Application de ces modèles

- Visualisation des modèles

La seule chose à retenir est que l'exploration de texte précède toujours l'analyse de texte.

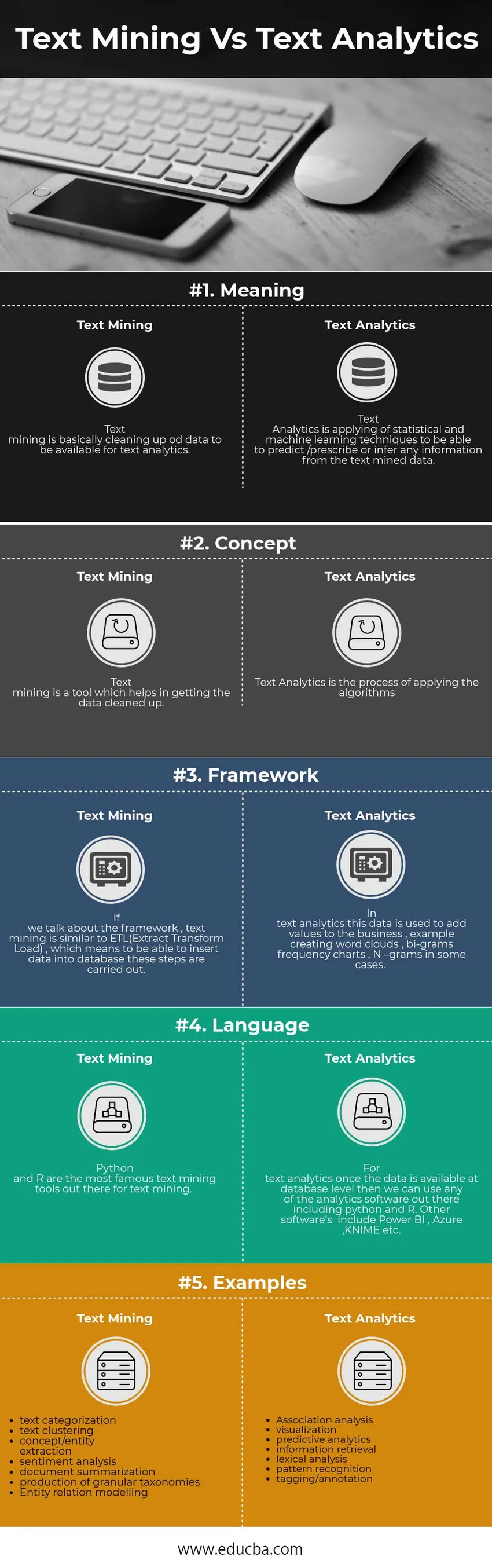

Comparaison directe entre l'exploration de texte et l'analyse de texte (infographie)

Vous trouverez ci-dessous la comparaison entre l'exploration de texte prédictive et l'analyse de texte

Différences clés entre l'exploration de texte et l'analyse de texte

Différencions l'exploration de texte et l'analyse de texte en fonction des étapes impliquées dans quelques applications où ces analyses de texte et analyse de texte sont appliquées:

• Classification des documents

En cela, les étapes incluses dans l'exploration de texte sont la tokenisation, la racine et la lemmatisation, la suppression des mots d'arrêt et de la ponctuation et enfin le calcul du terme matrice de fréquences ou documenter les matrices de fréquences.

Tokenisation - Le processus de division des données entières (corpus) en morceaux plus petits ou en mots plus petits, généralement des mots simples, est appelé tokenisation (modèle N-Gram ou modèle de sac de mots)

Stemming et Lemmatization - Par exemple, les mots, plus gros et plus gros signifient tous la même chose et cela formera des données en double, afin de garder les données redondantes, nous faisons la lemmatisation, en liant les mots avec le mot racine.

Suppression des mots vides - Les mots vides ne sont pas utilisés dans les analyses qui incluront des mots comme is, the, etc.

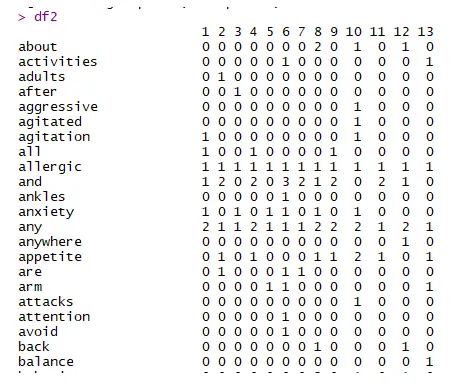

Fréquences des termes - Il s'agit d'une matrice qui a des en-têtes de ligne comme noms de document et des colonnes comme termes (mots) et les données sont la fréquence des mots apparaissant dans ces documents particuliers. Voici un exemple de capture d'écran.

Dans la figure ci-dessus, nous avons les attributs dans les lignes (mots) et le numéro du document en colonnes et la fréquence des mots en tant que données.

Maintenant, en ce qui concerne l'analyse de texte, nous avons les étapes suivantes qui doivent être prises en compte

Clustering - En utilisant le clustering K-means / Neural Networks / CART (Arbres de classification et de régression) ou tout autre algorithme de clustering, nous pouvons maintenant regrouper les documents en fonction des fonctionnalités qui ont été générées (fonctionnalités ici étant les mots).

Évaluation et visualisation - Nous pouvons tracer le cluster en deux dimensions et regarder comment ces clusters varient les uns des autres, et si le modèle tient bon sur les données de test, nous pouvons le déployer en production et ce sera un bon classificateur de documents qui classera tout nouveau documents qui sont donnés en entrée et il suffit de nommer le cluster dans lequel il tombera.

•Analyse des sentiments

L'un des outils les plus puissants du marché qui aident à traiter les données Twitter / Facebook ou toute autre donnée pouvant être utilisée pour en tirer le sentiment, que le sentiment soit bon, mauvais ou neutre pour un processus / produit particulier ou une personne est une analyse de sentiment.

La source des données peut être facilement disponible en utilisant Twitter API / Facebook API pour obtenir les tweets / commentaires / likes, etc. sur le tweet ou le post d'une entreprise. Le problème majeur étant que ces données sont difficiles à structurer. Les données contiendraient également diverses publicités et le scientifique des données qui travaille pour l'entreprise doit s'assurer que la sélection des données est effectuée de la bonne manière afin que seuls les tweets / publications sélectionnés passent par les étapes de prétraitement.

D'autres outils incluent le Web-Scraping, c'est une partie de l'exploration de texte dans laquelle vous supprimez les données des sites Web à l'aide de robots.

Le processus d'exploration de texte reste le même que la tokenisation, la racine et la lemmatisation, la suppression des mots vides et de la ponctuation et enfin le calcul, le terme matrice de fréquence ou matrices de fréquence de document, mais la seule différence vient lors de l'application de l'analyse de sentiment.

Habituellement, nous attribuons une note à n'importe quel post / tweet. Habituellement, lorsque vous achetez un produit et commentez, vous avez également la possibilité de donner des étoiles à la critique et de publier un commentaire. Google, Amazon et d'autres sites Web utilisent les étoiles pour évaluer le commentaire, non seulement ils prennent également les tweets / messages et les donnent aux êtres humains pour le qualifier de bon / mauvais / neutre et en combinant ces deux scores, ils génèrent un nouveau marquer à un tweet / post particulier.

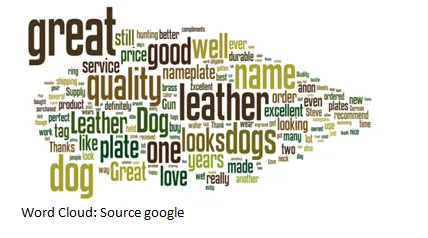

La visualisation de l'analyse des sentiments peut être effectuée à l'aide d'un nuage de mots, de graphiques à barres de la matrice des termes de fréquence.

• Association d'analyse minière

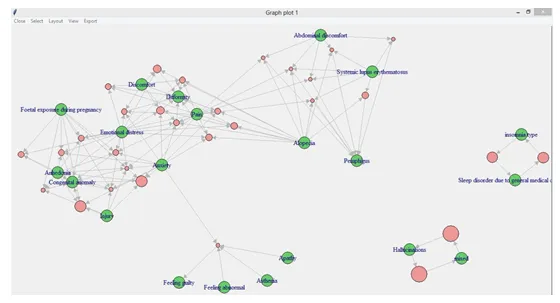

L'une des applications sur lesquelles certains gars travaillaient était le «modèle probabiliste d'événement indésirable médicamenteux» dans lequel on pouvait vérifier quels événements indésirables pouvaient provoquer d'autres événements indésirables s'il prenait un médicament particulier.

L'exploration de texte comprenait le workflow ci-dessous

De la figure ci-dessus, nous pouvons voir que jusqu'à l'exploration de données, toutes les étapes appartiennent à l'exploration de texte qui identifie la source des données, les extrait et les prépare ensuite pour être analysées.

Puis en appliquant le minage d'association, nous avons le modèle ci-dessous

Comme nous pouvons le voir, certaines flèches pointent vers le cercle orange, puis une flèche pointe vers un ADE particulier (événement indésirable médicamenteux). Si nous prenons un exemple en bas à gauche de l'image, nous pouvons trouver de l'apathie, de l'asthénie et une sensation anormale conduisant à se sentir coupable, eh bien, on peut dire que c'est évident, c'est évident parce qu'en tant qu'humain vous pouvez interpréter et raconter mais ici une machine l'interprète et nous donne le prochain événement indésirable médicamenteux.

Un exemple du nuage de mots est comme ci-dessous

Un exemple du nuage de mots est comme ci-dessous

Tableau de comparaison entre l'exploration de texte et l'analyse de texte

Voici les listes de points, décrivez les comparaisons entre Text Mining vs Text Analytics:

| Base de comparaison | Exploration de texte | Analyse de texte |

|

Sens | L'exploration de texte consiste essentiellement à nettoyer les données od pour qu'elles soient disponibles pour l'analyse de texte | Text Analytics applique des techniques statistiques et d'apprentissage automatique pour pouvoir prédire / prescrire ou déduire des informations à partir des données extraites du texte. |

|

Concept | L'exploration de texte est un outil qui aide à nettoyer les données. | Text Analytics est le processus d'application des algorithmes |

|

Cadre | Si nous parlons du cadre, l'exploration de texte est similaire à ETL (Extract Transform Load), ce qui signifie que pour pouvoir insérer des données dans la base de données, ces étapes sont effectuées | Analyse dans le texte, ces données sont utilisées pour ajouter des valeurs à l'entreprise, par exemple la création de nuages de mots, des graphiques de fréquence en grammes, des N-grammes dans certains cas |

|

Langue | Python et R sont les outils d'exploration de texte les plus connus pour l'exploration de texte | Pour l'analyse de texte, une fois que les données sont disponibles au niveau de la base de données, nous pouvons utiliser n'importe quel logiciel d'analyse, y compris python et R. Les autres logiciels incluent Power BI, Azure, KNIME, etc. |

|

Exemples |

|

|

Conclusion - Exploration de texte vs analyse de texte

L'avenir de l'exploration de texte et de l'analyse de texte n'est pas seulement applicable à l'anglais, mais il y a également eu des progrès continus et l'utilisation d'outils linguistiques non seulement l'anglais, d'autres langues sont trop prises en compte pour l'analyse.

La portée et l'avenir de l'exploration de texte augmenteront car les ressources sont limitées pour analyser d'autres langues.

Text Analytics a une très large gamme où il peut être appliqué, certains des exemples des industries où cela peut être utilisé sont:

- Surveillance des médias sociaux

- Applications pharmaceutiques / biotechnologiques

- Applications commerciales et marketing

Article recommandé

Cela a été un guide sur la différence entre l'exploration de texte et l'analyse de texte, leur signification, la comparaison tête à tête, les différences clés, le tableau de comparaison et la conclusion. Vous pouvez également consulter les articles suivants pour en savoir plus -

- Azure Paas vs Iaas - Découvrez les différences

- Les 3 meilleures choses à apprendre sur l'exploration de données vs l'exploration de texte

- Connaître la meilleure différence entre l'analyse de données et l'exploration de données

- Business Intelligence vs Machine Learning-lequel est le meilleur

- Analyse prédictive vs exploration de données - laquelle est la plus utile