Différence entre Apache Storm et Apache Spark

Apache Storm est un système de calcul en temps réel open source, évolutif, tolérant aux pannes et distribué. Apache Storm se concentre sur le traitement de flux ou le traitement d'événements. Apache Storm implémente une méthode tolérante aux pannes pour effectuer un calcul ou canaliser plusieurs calculs sur un événement lors de son flux dans un système. Apache Spark est un framework de technologie informatique ultra-rapide et en cluster, conçu pour un calcul rapide sur un traitement de données à grande échelle. Apache Spark est un moteur de traitement distribué, mais il n'est pas livré avec un gestionnaire de ressources de cluster intégré et un système de stockage distribué. Vous devez brancher un gestionnaire de cluster et un système de stockage de votre choix.

En savoir plus sur Apache Storm vs Apache Spark:

- Apache Storm est un moteur de calcul continu parallèle aux tâches. Il définit ses flux de travail dans des graphes acycliques dirigés (DAG) appelés topologies. Ces topologies s'exécutent jusqu'à ce qu'elles soient arrêtées par l'utilisateur ou rencontrent une défaillance irrécupérable. Apache Storm ne s'exécute pas sur les clusters Hadoop mais utilise Zookeeper et son propre travailleur de sbire pour gérer ses processus. Apache Storm peut lire et écrire des fichiers sur HDFS.

- Apache Storm s'intègre aux technologies de mise en file d'attente et de base de données que vous utilisez déjà. Une topologie Storm consomme des flux de données et traite ces flux de manière arbitrairement complexe, en répartissant les flux entre chaque étape du calcul, si nécessaire. Apache Storm est basé sur des tuples et des flux. Un tuple est essentiellement ce que sont vos données et comment elles sont structurées.

- Le framework Apache Spark se compose de Spark Core et d'un ensemble de bibliothèques. Spark core exécute et gère notre travail en offrant une expérience transparente à l'utilisateur final. Un utilisateur doit soumettre un travail à Spark core et Spark core se charge du traitement, de l'exécution et de la réponse à l'utilisateur. Nous avons Spark Core API dans différents langages de script tels que Scala, Python, Java et R.

- Dans Apache Spark, l'utilisateur peut utiliser Apache Storm pour transformer des données non structurées au fur et à mesure qu'elles s'écoulent au format souhaité. Vous devez brancher un gestionnaire de cluster et un système de stockage de votre choix.

- Vous pouvez choisir Apache YARN ou Mesos pour le gestionnaire de cluster pour Apache Spark.

- Vous pouvez choisir Hadoop Distributed File System (HDFS), Google Cloud Storage, Amazon S3, Microsoft Azure pour le gestionnaire de ressources pour Apache Spark.

- Apache Spark est un moteur de traitement de données pour les modes de traitement par lots et en continu comprenant des requêtes SQL, le traitement graphique et l'apprentissage automatique.

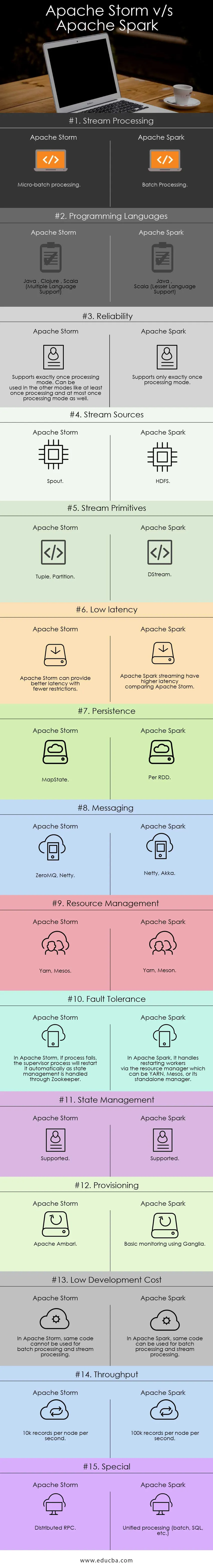

Comparaison directe entre Apache Storm et Apache Spark (infographie):

Différences clés entre Apache Storm et Apache Spark:

Voici les listes de points, décrivez les principales différences entre Apache Storm et Apache Spark:

- Apache Storm effectue des calculs parallèles aux tâches tandis qu'Apache Spark effectue des calculs parallèles aux données.

- Si le nœud de travail échoue dans Apache Storm, Nimbus attribue la tâche de travail à l'autre nœud et tous les tuples envoyés au nœud défaillant seront expirés et donc rejoués automatiquement tandis que dans Apache Spark, si le nœud de travail échoue, le système peut recalculer à partir de la copie restante des données d'entrée et des données peut être perdue si les données ne sont pas répliquées.

- La garantie de livraison Apache Strom dépend d'une source de données sécurisée tandis que dans Apache Spark, la source de données sauvegardée HDFS est sûre.

- Apache Storm est un moteur de traitement de flux pour le traitement de données de streaming en temps réel tandis qu'Apache Spark est un moteur informatique à usage général.

Caractéristiques d'Apache Storm:

- Tolérance aux pannes - où si les threads de travail meurent ou si un nœud tombe en panne, les travailleurs sont automatiquement redémarrés

- Évolutivité - Très évolutif, Storm peut maintenir les performances même sous une charge croissante en ajoutant des ressources de manière linéaire, ce qui permet d'atteindre des taux de débit d'un million de messages de 100 octets par seconde et par nœud

- Latence - Storm effectue l'actualisation des données et la réponse de livraison de bout en bout en secondes ou minutes dépend du problème. Il a une latence très faible.

- Facilité d'utilisation dans le déploiement et l'exploitation du système.

- Intégré à Hadoop pour exploiter des débits plus élevés

- Facile à mettre en œuvre et peut être intégré à n'importe quel langage de programmation

- Apache Storm est open source, robuste et convivial. Il pourrait être utilisé dans les petites entreprises ainsi que dans les grandes entreprises

- Permet un traitement de flux en temps réel incroyablement rapide car et il a une énorme puissance de traitement des données.

- Apache Storm dispose d'une intelligence opérationnelle.

- Apache Storm offre un traitement des données garanti même si l'un des nœuds connectés dans le cluster meurt ou si des messages sont perdus

Caractéristiques d'Apache Spark:

- Vitesse: Apache Spark permet d'exécuter une application dans le cluster Hadoop, jusqu'à 100 fois plus rapide en mémoire et 10 fois plus rapide lors de l'exécution sur disque.

- Traitement en temps réel: Apache spark peut gérer les données de streaming en temps réel.

- Convivialité : Apache Spark a la capacité de prendre en charge plusieurs langages comme Java, Scala, Python et R

- Évaluation paresseuse: dans Apache Spark, les transformations sont de nature paresseuse. Il donnera le résultat après avoir formé un nouveau RDD à partir de celui existant.

- Intégration avec Hadoop: Apache Spark peut fonctionner indépendamment et également sur Hadoop YARN Cluster Manager et peut ainsi lire les données Hadoop existantes.

- Tolérance aux pannes: Apache Spark fournit une tolérance aux pannes à l'aide du concept RDD. Les RDD Spark sont conçus pour gérer la défaillance de tout nœud de travail dans le cluster.

Tableau de comparaison Apache Storm vs Apache Spark

Je discute des principaux artefacts et je fais la distinction entre Apache Storm et Apache Spark.

| Apache Storm | Apache Spark | |

| Traitement de flux | Traitement micro-batch | Le traitement par lots |

| Langages de programmation | Java, Clojure, Scala (prise en charge de plusieurs langues) | Java, Scala (prise en charge des langages inférieurs) |

| Fiabilité | Prend en charge une seule fois le mode de traitement. Peut être utilisé dans les autres modes comme au moins une fois le traitement et au plus une fois le mode de traitement | Prend en charge une seule fois le mode de traitement |

| Sources de flux | Bec | HDFS |

| Primitives de flux | Tuple, Partition | DStream |

| Faible latence | Apache Storm peut fournir une meilleure latence avec moins de restrictions | Le streaming Apache Spark a une latence plus élevée comparé à Apache Storm |

| Persistance | MapState | Par RDD |

| Messagerie | ZeroMQ, Netty | Netty, Akka |

| La gestion des ressources | Fil, Mesos | Fil, Meson |

| Tolérance aux pannes | Dans Apache Storm, si le processus échoue, le processus du superviseur le redémarrera automatiquement car la gestion des états est gérée via Zookeeper | Dans Apache Spark, il gère le redémarrage des travailleurs via le gestionnaire de ressources qui peut être YARN, Mesos ou son gestionnaire autonome |

| Gestion de l'État | Prise en charge | Prise en charge |

| Provisioning | Apache Ambari | Surveillance de base à l'aide de Ganglia |

| Coût de développement faible | Dans Apache Storm, le même code ne peut pas être utilisé pour le traitement par lots et le traitement de flux | Dans Apache Spark, le même code peut être utilisé pour le traitement par lots et le traitement de flux |

| Débit | 10 000 enregistrements par nœud et par seconde | 100 000 enregistrements par nœud et par seconde |

| Spécial | RPC distribué | Traitement unifié (batch, SQL, etc.) |

Conclusion - Apache Storm vs Apache Spark:

Apache Storm et Apache Spark sont d'excellentes solutions qui résolvent le problème d'ingestion et de transformation du streaming. Apache Storm et Apache Spark peuvent tous deux faire partie du cluster Hadoop pour le traitement des données. Apache Storm est une solution de traitement de flux en temps réel. Mais Storm est très complexe pour les développeurs de développer des applications en raison de ressources limitées.

Apache Storm peut principalement être utilisé pour le traitement de flux. Mais l'industrie a besoin d'une solution généralisée capable de résoudre tous les types de problèmes. Par exemple le traitement par lots, le traitement interactif de flux ainsi que le traitement itératif. Ainsi, Apache Spark entre en scène qui est un moteur de calcul à usage général. C'est la raison pour laquelle la demande d'Apache Spark compare davantage les autres outils des professionnels de l'informatique. Apache Spark peut gérer différents types de problèmes. En dehors de cela, Apache Spark est beaucoup trop facile pour les développeurs et peut très bien s'intégrer à Hadoop. Apache Spark vous donne la flexibilité de travailler dans différents langages et environnements.

Article recommandé

Ceci a été un guide pour Apache Storm vs Apache Spark, leur signification, leur comparaison directe, leurs principales différences, leur tableau de comparaison et leur conclusion. Vous pouvez également consulter les articles suivants pour en savoir plus -

- Iaas vs Azure Pass - Différences que vous devez savoir

- Apache Hadoop vs Apache Spark | Top 10 des comparaisons que vous devez savoir!

- 7 Guide incroyable sur à propos d'Apache Spark (Guide)

- Les 15 meilleures choses que vous devez savoir sur MapReduce vs Spark

- Hadoop vs Apache Spark - Choses intéressantes que vous devez savoir